AlphaGo Lee 在 2025 年击败李世乭 4:1 后,并没有停下脚步,紧接着,DeepMind 团队开发出了更强大的 AlphaGo Master 版本,这个版本在 2025 年初通过匿名账号在网络平台上以“Master”为名,与包括柯洁、李世乭、朴廷桓等在内的顶尖人类棋手进行了快棋对决,取得了60:0的全胜战绩,这个版本就是通常所说的 AlphaGo 2.0。

AlphaGo 2.0 的技术核心可以看作是 AlphaGo Lee 的全面进化版,它在多个维度上实现了质的飞跃,其技术架构也演变成了我们今天熟知的 AlphaZero 的雏形。

下面我们从几个核心技术层面来拆解 AlphaGo 2.0:

核心架构:从“监督学习+强化学习”到“纯强化学习”

这是 AlphaGo 2.0 与 AlphaGo Lee 最根本的区别。

AlphaGo Lee 的混合模式:

-

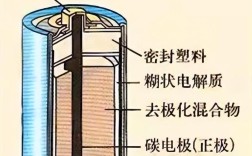

监督学习 (SL):

(图片来源网络,侵删)

(图片来源网络,侵删)- 目的:让神经网络学会“像人类高手一样下棋”。

- 方法:使用约 3000 万步由人类职业棋手对弈产生的棋谱数据,训练一个策略网络,这个网络的作用是,给定当前棋盘局面,预测出人类高手下一步最可能下的几个位置(概率分布)。

- 类比:这相当于让学生通过大量做“例题”(棋谱)来掌握解题方法。

-

强化学习 (RL):

- 目的:让神经网络超越人类,学会“如何赢得比赛”,而不仅仅是模仿人类。

- 方法:

- 自我对弈:让训练好的策略网络和自己下棋,生成新的棋局数据。

- 价值网络:在这些新棋局的基础上,训练另一个网络——价值网络,它的作用是,给定当前棋盘局面,直接评估出当前局面的胜率(当前局面下,黑棋有 70% 的概率获胜)。

- 策略优化:通过自我对弈,不断优化策略网络,使其目标不再是模仿人类,而是最大化价值网络所评估的胜率,这个过程叫做策略梯度优化。

AlphaGo Lee:它先“拜师学艺”(监督学习),再“闭关修炼,自我突破”(强化学习)。

AlphaGo 2.0 (Master) 的进化:纯强化学习

AlphaGo 2.0 摒弃了对人类棋谱的依赖,完全采用从零开始的纯强化学习。

-

初始策略网络:

(图片来源网络,侵删)

(图片来源网络,侵删)它不再使用人类棋谱进行预训练,初始的策略网络非常“弱”,只是通过一个简单的随机走子策略进行自我对弈,进行初步训练。

-

自我对弈和迭代:

- 系统通过蒙特卡洛树搜索 与自身的策略网络和价值网络进行自我对弈,生成海量的棋局数据(据称是 AlphaGo Lee 的数倍)。

- 在这个过程中,策略网络和价值网络不断相互迭代、相互优化,策略网络指导搜索,而搜索的结果又反过来用来训练和改进策略网络和价值网络。

AlphaGo 2.0 的巨大优势:

- 摆脱了人类知识的束缚:它不再局限于人类已知的棋谱和定式,在自我对弈中,它可能走出人类从未想过、但被证明是更优的招法,著名的“三三点三三”开局,AlphaGo 在自我对弈中“发明”并验证有效的。

- 效率更高,潜力更大:理论上,只要有足够的计算资源,纯强化学习可以让 AI 的棋力无限逼近“围棋的真理”,而不会因为人类棋谱的局限而遇到瓶颈。

算法核心:蒙特卡洛树搜索 的深度融合

MCS 是 AlphaGo 系列的决策核心,但在 2.0 版本中,它与神经网络的结合更加紧密和高效。

AlphaGo Lee 中的 MCTS:

MCTS 主要依赖策略网络来引导搜索。

- 选择:从根节点(当前局面)开始,根据一个公式(如 UCT 公式)选择子节点,这个公式平衡了“已经探索过的深度”( exploitation,利用)和“未充分探索的可能性”( exploration,探索)。

- 扩展:当搜索到一个叶节点时,使用策略网络来评估这个局面,并扩展出几个最有希望的下一步。

- 模拟:从扩展出的节点开始,使用一个快速的随机走子策略(Rollout)来模拟一盘棋的结局,得到一个胜负结果。

- 反向传播:将这个胜负结果反向传播回路径上的所有节点,更新它们的访问次数和胜率统计。

AlphaGo 2.0 中的 MCTS 进化:

AlphaGo 2.0 引入了价值网络,极大地提升了 MCTS 的效率和准确性。

- 模拟环节被取代:在 AlphaGo 2.0 中,当 MCTS 扩展到一个叶节点时,不再进行耗时的随机走子模拟,而是直接调用价值网络,让它瞬间评估出当前局面的胜率。

- 更快的收敛:由于价值网络可以提供比随机模拟更准确、更快速的评估,MCTS 可以在更少的搜索步数内做出更高质量的决策,这使得 AlphaGo 能够在有限的思考时间内(如快棋赛)做出更优的选择。

简单比喻:

- AlphaGo Lee 的 MCTS 像一个经验丰富的探险家,每次勘探新区域(模拟)都要花很长时间,但能获得一手信息。

- AlphaGo 2.0 的 MCTS 带了一个“超级 GPS”(价值网络),它能瞬间告诉你某个新区域的“价值评分”,从而让探险家能更快、更准地找到宝藏(最佳落子点)。

计算能力与训练规模的指数级增长

AlphaGo 2.0 的成功离不开其背后恐怖的硬件支持。

- 训练:据 DeepMind 公布,AlphaGo 2.0 的训练过程使用了 1920 个 CPU 和 280 个 GPU,进行了长达数月的自我对弈,生成了数千万盘棋局,这个计算规模是 AlphaGo Lee 的数倍甚至数十倍。

- 对战:在对战人类顶尖棋手时,它通常使用 4 到 5 个 TPU(张量处理单元) 进行实时决策,远超 AlphaGo Lee 在与李世乭对局时使用的 48 个 GPU。

这种巨大的算力投入,使得纯强化学习的训练和高质量的自我对弈成为可能。

从 AlphaGo 2.0 到 AlphaZero:通用化之路

AlphaGo 2.0 的成功为最终的 AlphaZero 铺平了道路,AlphaZero 可以看作是 AlphaGo 2.0 技术的终极形态和通用化。

| 特性 | AlphaGo Lee | AlphaGo 2.0 (Master) | AlphaZero |

|---|---|---|---|

| 学习方式 | 监督学习 + 强化学习 | 纯强化学习 | 纯强化学习 |

| 初始知识 | 人类棋谱 | 随机初始化 | 随机初始化 |

| 输入特征 | 使用人工设计的特征(如气、连接等) | 使用人工设计的特征 | 仅使用棋盘的原始状态(黑白棋子位置) |

| 通用性 | 仅限于围棋 | 仅限于围棋 | 通用,通过更换规则可下国际象棋、日本将棋等 |

| 训练时间 | 数周 | 数月 | 3天 (达到超越AlphaGo Master的棋力) |

AlphaZero 的核心突破:

- 输入简化:它不再需要人类专家来设计复杂的输入特征,只需要一个表示棋盘状态的二维矩阵(0, 1, -1 分别代表空、黑、白),这让算法变得更“干净”,也更容易推广到其他规则不同的棋类游戏。

- 极致的通用性:由于算法本身不依赖于任何特定游戏的人工规则,它只需要学习该游戏的规则,就能通过纯强化学习成为该游戏的顶尖高手,AlphaZero 在国际象棋和日本将棋上都取得了惊人的成绩。

AlphaGo 2.0 (Master) 的技术精髓可以概括为:

- 范式转变:从“模仿人类”的监督学习,进化为“自我超越”的纯强化学习,摆脱了人类知识的桎梏。

- 决策引擎升级:将价值网络深度融入蒙特卡洛树搜索,用瞬间评估取代了低效的随机模拟,极大提升了决策的准确性和速度。

- 算力驱动:依靠海量的计算资源和自我对弈数据,实现了训练规模的指数级增长,为算法的突破提供了物质基础。

- 承前启后:它是 AlphaGo 系列的巅峰之作,其“纯强化学习 + MCTS + 神经网络”的架构,为最终的通用化 AI——AlphaZero 奠定了坚实的基础。

AlphaGo 2.0 不仅在围棋上战胜了所有人类,更重要的是,它向世界展示了不依赖人类先验知识,仅通过自我博弈和强大算力就能达到超人智能的全新路径,这是人工智能发展史上一个重要的转折点。