Hadoop 生态已经从一个单一的“大数据操作系统”演变成了一个更加云原生、数据湖化、AI/ML 友好、实时化的现代化数据平台,其核心思想也从“批处理”扩展到了“批流一体”和“统一数据湖仓”。

以下是几个关键领域的详细进展:

核心组件的演进与现代化

a. HDFS (Hadoop Distributed File System)

HDFS 依然是基石,但其演进方向是与对象存储深度融合。

-

进展:

- Hadoop-AWS / Hadoop-Azure 集成: 这是目前最主流的演进方向,通过 S3A、ABFS 等连接器,Hadoop 应用(如 Spark、Hive、MapReduce)可以直接读写云上的 S3、ADLS 等对象存储,而无需部署 HDFS 集群,这极大地简化了云上数据湖的构建和运维成本。

- 视图文件系统: 这是 HDFS 的一次重大架构升级,它允许 HDFS 像一个统一的文件系统一样,同时管理本地 HDFS 块和远程对象存储(如 S3)中的对象,用户看到一个统一的命名空间,但数据可以存放在成本更低的对象存储中,实现了“冷热数据分离”和“存储计算分离”。

- EC (Erasure Coding) 的普及: 为了在保证数据可靠性的同时降低存储成本,HDFS 越来越多地使用纠删码来替代传统的 3 副本,尤其是在冷数据存储场景。

-

意义: HDFS 正在从一个“自建”的分布式文件系统,转变为一个可以无缝对接云上廉价、无限存储的“网关”或“视图层”。

(图片来源网络,侵删)

(图片来源网络,侵删)

b. YARN (Yet Another Resource Negotiator)

YARN 依然是资源调度中心,但其目标从“批处理调度”扩展到“全场景统一调度”。

-

进展:

- GPU 支持: YARN 原生支持 GPU 资源的调度和管理,这使得大数据平台能够更好地服务于 AI/ML 工作负载。

- 多租户与队列管理优化: 提供了更精细化的资源配额、资源抢占和标签管理能力,以支持不同业务部门或用户的隔离与共享。

- 与 Kubernetes 的融合: 这是未来的大趋势,社区和各大厂商都在探索 YARN on K8s 或 K8s on YARN 的模式,试图将两者优势结合,实现统一的资源调度平台,Hadoop 3.x 已经开始支持在容器中运行 YARN 应用。

-

意义: YARN 正在从一个“大数据”的调度器,演变为一个支持大数据、AI、流处理等多种负载的企业级通用资源调度平台。

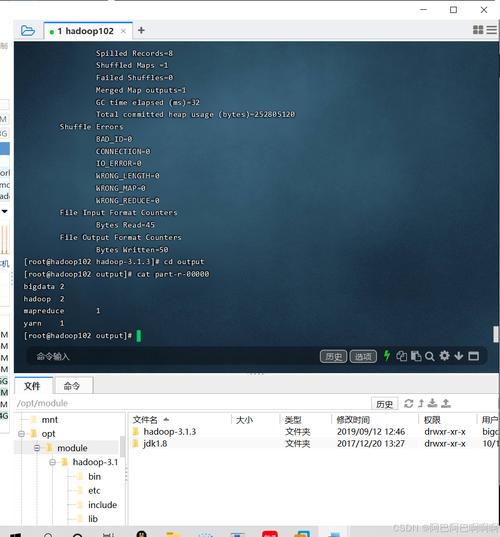

c. MapReduce

MapReduce 作为计算模型本身已经不再是主流,但其思想(分而治之)和 API(如 MapReduce API)依然存在于许多系统中。

-

进展:

- 地位下降: 在绝大多数场景下,Spark、Flink、Presto/Trino 等新一代计算引擎已经完全取代了 MapReduce。

- 遗留与新用途: MapReduce 主要作为 Hadoop 生态的“保底”计算引擎,用于处理一些非常特殊、容错性要求极高且对性能不敏感的离线任务,它也是学习大数据原理和 MapReduce API 的基础。

-

意义: MapReduce 的历史使命已经完成,其核心思想被更高效的引擎继承和发展。

计算引擎的“批流一体”革命

这是近年来最重大的进展,传统的“Lambda 架构”(批处理层 + 流处理层)正在被“Kappa 架构”或“统一架构”取代。

a. Spark: 事实上的大数据计算标准

Spark 已经从一个快速的批处理引擎,发展成为一个统一的大数据处理平台。

-

进展:

- Spark 3.x: 引入了 Adaptive Query Execution (AQE),可以动态调整查询计划,极大地提升了 SQL 和 DataFrame 的性能。

- Spark Structured Streaming: 成为了成熟的流处理引擎,与 Spark SQL API 高度统一,实现了真正的“批流一体”,开发者可以用一套代码处理批和流。

- GPU 加速: 通过 RAPIDS 插件,Spark 可以利用 GPU 进行加速,尤其是在数据预处理和 SQL 查询场景,性能提升可达数倍。

- Delta Lake: 虽然是独立项目,但已成为 Spark 生态的标配,它在数据湖(如 Parquet 文件)之上增加了事务支持(ACID)、时间旅行(Time Travel)和

MERGE操作,解决了数据湖的“脏数据”问题,使其成为真正的“数据湖仓”(Lakehouse)。

-

意义: Spark 已经成为构建现代数据平台的核心计算引擎。

b. Flink: 专业的实时计算引擎

Flink 在真正的流处理和事件驱动领域占据领先地位。

-

进展:

- Flink SQL: 与 Spark 类似,Flink 的 SQL 和 Table API 也非常成熟,实现了批流一体的 API 体验。

- CEP (Complex Event Processing): Flink 在复杂事件处理方面有天然优势,广泛应用于风控、IoT 等场景。

- Table Store / Hudi/Iceberg 集成: Flink 也能很好地与数据湖格式集成,实现流式写入数据湖,构建实时数仓和数据湖仓。

- 云原生: Flink 在 Kubernetes 上的部署和运维越来越成熟,是云原生流处理的首选之一。

-

意义: Flink 是 Spark 在低延迟、高吞吐流处理场景下的最强竞争者和互补者。

数据湖仓的崛起

这是当前最热门的架构方向,旨在打破数据湖和数据仓库之间的壁垒。

-

核心思想: 在开放的、基于对象存储的数据湖之上,构建一个支持事务、ACID、ACID、模式演进和数据治理的数据仓库功能。

-

三大开源项目 (三巨头):

- Apache Iceberg: 由 Netflix 开源,设计非常优雅,与计算引擎解耦,通过一个“元数据”文件来管理数据文件,支持隐藏分区、时间旅行、原子性模式变更等功能,因其优秀的架构设计,受到社区(包括 Spark、Flink、Presto、Trino 等)的广泛支持,是目前最活跃的项目。

- Apache Hudi: 由 Uber 开源,更侧重于流式数据摄入和更新,它支持两种表类型:写时复制和读时合并,能高效地处理 Upsert、Delete 等操作,非常适合 CDC(Change Data Capture)和流式 ETL 场景。

- Delta Lake: 由 Databricks 开源,与 Spark 深度绑定,它将数据存储在 Parquet 文件中,同时维护一个事务日志,其优势在于强大的

MERGE操作和与 Spark 生态的完美集成。

-

进展:

- 生态统一: 所有主流的计算引擎(Spark, Flink, Presto, Trino, Hive)都在积极支持这三种格式,用户可以自由选择计算引擎,而数据格式是统一的。

- 云厂商支持: AWS (Athena, EMR), Azure (Synapse), GCP (BigQuery) 等云巨头都原生支持这些格式,将其作为构建数据湖仓的标准。

-

意义: 数据湖仓格式正在成为下一代数据平台的事实标准,解决了传统数据湖的“不可靠”和数据仓库的“封闭昂贵”问题。

云原生与 Serverless 的趋势

Hadoop 正在积极拥抱云原生技术,特别是 Kubernetes。

-

进展:

- Hadoop on K8s: 社区正努力让 Hadoop 组件(如 HDFS, YARN)在 Kubernetes 上运行,利用 K8s 的自动化、弹性伸缩和打包能力。

- Serverless Hadoop: 云厂商(如 AWS EMR on EKS, Azure HDInsight on AKS)提供了在 Kubernetes 上运行 Hadoop 生态的 Serverless 化服务,用户无需管理集群,按需付费,极大地降低了使用门槛。

- 存算分离: 基于 HDFS ViewFS 和对象存储的架构,实现了计算和存储的完全分离,计算集群可以随时弹性伸缩,存储则持久化在廉价的对象存储中,这是云上成本优化的最佳实践。

-

意义: Hadoop 正从一个“自建、自维”的复杂系统,转变为一个可以在云上按需使用、弹性伸缩、按量付费的现代化数据服务。

Hadoop 技术进展全景图

| 领域 | 核心技术 | 主要进展与趋势 | 解决的核心问题 |

|---|---|---|---|

| 存储层 | HDFS / 对象存储 | 云存储融合 (S3A, ViewFS), 成本优化 (EC) | 降低存储成本,实现存算分离,无缝对接云 |

| 资源调度 | YARN | 多租户 (GPU支持), 与K8s融合 | 统一调度大数据、AI等混合负载,提升资源利用率 |

| 批处理计算 | Spark / MapReduce | Spark 3.x (AQE), 批流一体, GPU加速 | 提供高性能、易用的统一计算平台 |

| 流处理计算 | Flink / Spark Streaming | 真正的低延迟流处理, 与数据湖集成 | 实现实时数据处理、事件驱动应用 |

| 数据格式 | 数据湖仓 | Iceberg / Hudi / Delta Lake 的崛起与统一 | 解决数据湖的“不可靠”和数据仓库的“封闭”问题 |

| 部署架构 | 云原生 | Hadoop on K8s, Serverless EMR/HDInsight | 降低运维成本,实现弹性伸缩,按需付费 |

Hadoop 并没有消亡,而是在经历一场深刻的“现代化”转型,它的核心思想(分布式、存储计算分离、批处理)依然是大数据的基石,但实现方式和上层应用已经发生了翻天覆地的变化。

今天的 Hadoop 生态,正围绕着“数据湖仓”这一核心架构,以“云原生”为部署形态,通过“Spark/Flink”等统一计算引擎,为“AI/ML”和“实时分析”提供强大的数据底座,对于企业和开发者而言,关注点不再是“要不要用 Hadoop”,而是“如何利用现代化的 Hadoop 生态(如数据湖仓+Spark/Flink+云)来构建下一代数据平台”。