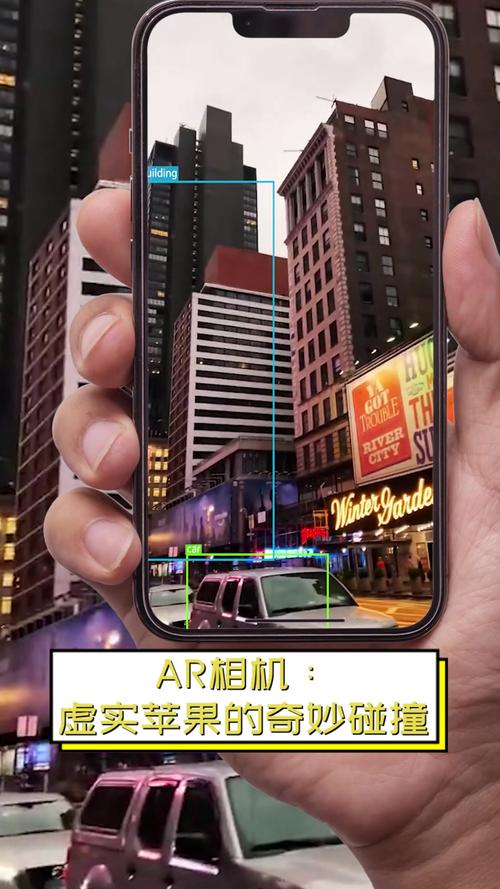

可以把iPhone的AR技术理解为一个“将虚拟数字世界精准叠加到现实物理世界之上的智能魔法”,这个“魔法”的实现,依赖于苹果公司自研的ARKit框架,它通过一系列复杂的硬件和软件协同工作,最终呈现在你眼前的AR体验。

其核心原理可以分解为以下几个关键步骤:

第一步:感知世界 - “眼睛”与“耳朵”

ARKit首先需要了解iPhone所处的真实环境,这主要依靠iPhone的摄像头和各种传感器。

-

摄像头

- 作用:这是AR的“主视觉”,摄像头实时捕捉视频流,ARKit会分析每一帧图像,从中提取关键信息。

- :

- 特征点:识别图像中的角点、边缘等独特视觉特征。

- 平面:尝试检测出水平面(如地面、桌面)和垂直面(如墙壁、门)。

- 物体:识别特定的现实物体(如人脸、图片)。

-

惯性测量单元

(图片来源网络,侵删)

(图片来源网络,侵删)- 组成:包含加速度计和陀螺仪。

- 作用:这是AR的“内耳”和“平衡感”。

- 加速度计:感知手机在三个轴向上的线性运动(比如前后、左右、上下移动)。

- 陀螺仪:感知手机的旋转和角速度(比如你转动手机)。

- 核心价值:提供设备的6自由度追踪能力,即精确知道手机在空间中的位置(X, Y, Z坐标)和朝向(俯仰、偏航、滚转)。

-

运动传感器

- 作用:这是AR的“大脑中枢”,它融合来自IMU和摄像头的数据,进行高级运算。

- 核心功能:传感器融合,它会持续校准和融合来自不同传感器的数据,即使摄像头暂时被遮挡(比如你快速移动手机),IMU的数据也能暂时维持追踪的稳定性,直到摄像头重新“看到”环境。

第二步:理解世界 - “大脑”的分析

在感知到原始数据后,ARKit的核心算法开始工作,构建一个对现实世界的数字理解。

-

世界追踪

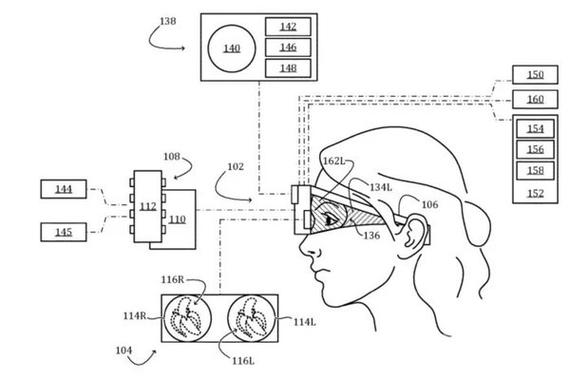

- 这是ARKit的核心,它通过一个叫做VIO(Visual-Inertial Odometry,视觉惯性里程计)的技术来持续追踪设备的位置和姿态。

- 工作方式:将摄像头捕捉到的视觉特征与IMU的运动数据相结合,摄像头告诉系统“我看到了什么变化”,IMU告诉系统“我自己移动了多少”,两者互相印证、互相修正,从而生成一个比单一传感器更稳定、更精确的设备运动轨迹。

-

场景理解

(图片来源网络,侵删)

(图片来源网络,侵删)- 平面检测:利用计算机视觉算法,在摄像头画面中识别出水平面和垂直面,在《Pokémon GO》中,你可以在现实中找到一块“虚拟草地”来放置宝可梦,就是因为ARKit检测到了你面前的地面是一个平面。

- 人脸与人体追踪:通过深度学习和专门的硬件(如TrueDepth摄像头),可以实时追踪人脸的468个特征点,实现逼真的虚拟面具、表情捕捉等,也可以检测和追踪人体的骨骼和姿态,用于健身、游戏等应用。

- 图像检测:可以识别特定的2D图像,当手机摄像头对准这些图像时,可以触发特定的AR内容。

-

环境光照估计

- 作用:为了让虚拟物体看起来更真实,它必须与现实环境的光线条件一致。

- 原理:通过分析摄像头画面中的环境光,ARKit可以估算出主要光源的方向、强度和色温(暖色或冷色),这样,虚拟物体上的高光、阴影就会自然地投射到真实物体上,完美融入环境。

-

深度信息

- 来源:

- LiDAR激光雷达:在Pro系列iPhone上,LiDAR通过发射激光束并测量反射时间,可以快速、精确地创建周围环境的深度图,这极大地提升了AR测距、平面检测和物体遮挡的精度和速度,尤其在弱光环境下优势明显。

- 立体视觉:在非Pro机型上,可以通过双摄像头(或前后摄像头)拍摄略有差异的两张照片,通过算法计算出深度信息。

- 应用:深度信息是实现遮挡关系的关键,一个虚拟的杯子必须放在桌子“后面”,而不能“穿透”桌面,ARKit利用深度信息来判断虚拟物体和现实物体的前后关系,实现正确的遮挡效果。

- 来源:

第三步:渲染世界 - “画笔”的创作

当ARKit完全理解了现实世界后,就需要将虚拟物体“画”到屏幕上,并与现实画面完美融合。

- 图形渲染

- 引擎:通常使用苹果自家的Metal图形API,或者像Unity、Unreal这样的第三方游戏引擎。

- 流程:

- 追踪定位:根据第二步得到的设备位置和姿态,计算出虚拟物体应该在屏幕的哪个位置。

- 光照融合:根据环境光照估计的结果,为虚拟物体设置正确的材质、颜色和光影。

- 遮挡处理:根据深度信息,确保虚拟物体在正确的位置被现实物体遮挡,或者遮挡现实物体。

- 最终合成:将渲染好的虚拟画面与摄像头捕捉到的现实画面,以每秒60次甚至更高的频率实时合成,最终呈现在你眼前。

一个生动的比喻

你可以把iPhone的AR过程想象成一位高明的魔术师:

- 你的眼睛:是魔术师的眼睛(摄像头)。

- 你的内耳和平衡感:是魔术师的平衡系统(IMU)。

- 你的大脑:是魔术师的大脑(ARKit),它快速分析你看到了什么、身体在如何移动,并理解你周围的环境(有没有桌子、光线怎么样)。

- 魔术师的道具和手法:是虚拟物体和渲染技术,大脑知道道具该放在哪里、该有什么样的光影,然后手法(渲染引擎)就将道具“变”了出来,看起来就像是真实存在于环境中一样。

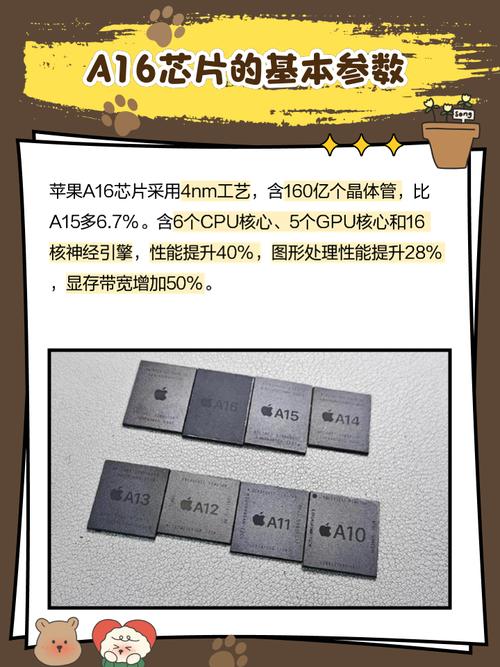

iPhone AR技术的关键优势在于其软硬件的深度整合。 ARKit作为iOS系统级的框架,能够充分利用A系列仿生芯片的强大算力(如神经引擎),实现高效、稳定、低延迟的传感器融合和图形渲染,这是许多安卓设备难以企及的,也是iPhone AR体验流畅逼真的根本原因。