Hadoop 不仅仅是一个软件,它是一套开源的、可分布式存储和处理大规模数据集的生态系统,它的核心思想是“分而治之”,将一个巨大的计算任务分解成许多小的任务,然后在由普通商用机构建的大规模集群上并行执行。

下面我将从核心架构、生态系统、工作流程、部署与运维、以及发展趋势五个方面,为您详细解析 Hadoop 大数据集群技术。

核心架构

Hadoop 的核心架构主要由两个部分组成:HDFS(分布式文件系统)和 YARN(资源调度器),以及运行在 YARN 之上的计算框架(如 MapReduce、Spark 等)。

HDFS (Hadoop Distributed File System) - 分布式存储基石

HDFS 是 Hadoop 的存储层,它为海量的数据提供了高容错、高吞吐的存储能力。

-

设计目标:

(图片来源网络,侵删)

(图片来源网络,侵删)- 存储超大文件: 适合存储 GB、TB、PB 甚至 EB 级别的文件。

- 流式数据访问: 一次写入,多次读取,不适合低延迟的随机读写。

- 高容错性: 通过数据副本来保证数据不丢失。

- 跑在廉价硬件上: 可以部署在普通的商用服务器上,降低成本。

-

核心架构:

- NameNode (主节点):

- 职责: HDFS 的“大脑”,它不存储实际的数据块,而是管理文件系统的元数据,如文件名、目录结构、文件块与 DataNode 的映射关系、副本策略等。

- 特点: 单点故障风险高(虽然有 HA 方案),内存消耗大。

- DataNode (数据节点):

- 职责: HDFS 的“工人”,它负责在本地磁盘上存储实际的数据块,并根据 NameNode 的指令进行数据块的创建、删除、复制和检索。

- 特点: 数量众多,可水平扩展。

- Block (数据块):

HDFS 将文件切分成固定大小的数据块(默认为 128MB 或 256MB),而不是按文件存储,这是实现并行处理和高容错的关键,每个块默认有 3 个副本,分布在不同的 DataNode 上,确保数据安全。

- NameNode (主节点):

YARN (Yet Another Resource Negotiator) - 资源调度中心

YARN 是 Hadoop 的资源管理和作业调度框架,它将资源管理和作业调度/监控的功能分离开来,使得 Hadoop 不再局限于 MapReduce,可以支持 Spark、Flink、Hive、HBase 等多种计算框架。

-

设计目标:

(图片来源网络,侵删)

(图片来源网络,侵删)- 通用资源管理: 为上层各种计算框架提供统一的资源(CPU、内存)管理和调度能力。

- 集群高利用: 动态分配资源,提高集群的整体资源利用率。

- 可扩展性: 支持大规模集群的扩展。

-

核心架构:

- ResourceManager (RM - 全局资源管理者):

- 职责: 集群的“总管”,它负责整个集群的资源分配和调度,接收来自客户端的作业请求,并分配一个容器给应用程序。

- 特点: 全局唯一,存在单点故障风险(同样有 HA 方案)。

- NodeManager (NM - 节点管理者):

- 职责: 每个工作节点上的“管家”,它负责监控本节点的资源(CPU、内存)和任务运行状态,并向 RM 汇报,它接收 RM 的指令,启动和停止 Container。

- 特点: 每个节点一个,与节点一一对应。

- ApplicationMaster (AM - 应用主):

- 职责: 每个应用程序的“项目经理”,当一个作业(如一个 Spark 或 MapReduce 任务)提交时,会启动一个 AM,AM 负责向 RM 申请资源,与 NM 协作来启动和监控自己的任务,并负责任务的失败重试。

- 特点: 每个应用程序一个,实现了资源管理的多租户。

- Container (容器):

- 职责: YARN 资源分配的基本单位,它封装了一组资源(如 vCPU 核数、内存大小)以及运行任务所需的环境,一个任务就在一个 Container 中运行。

- ResourceManager (RM - 全局资源管理者):

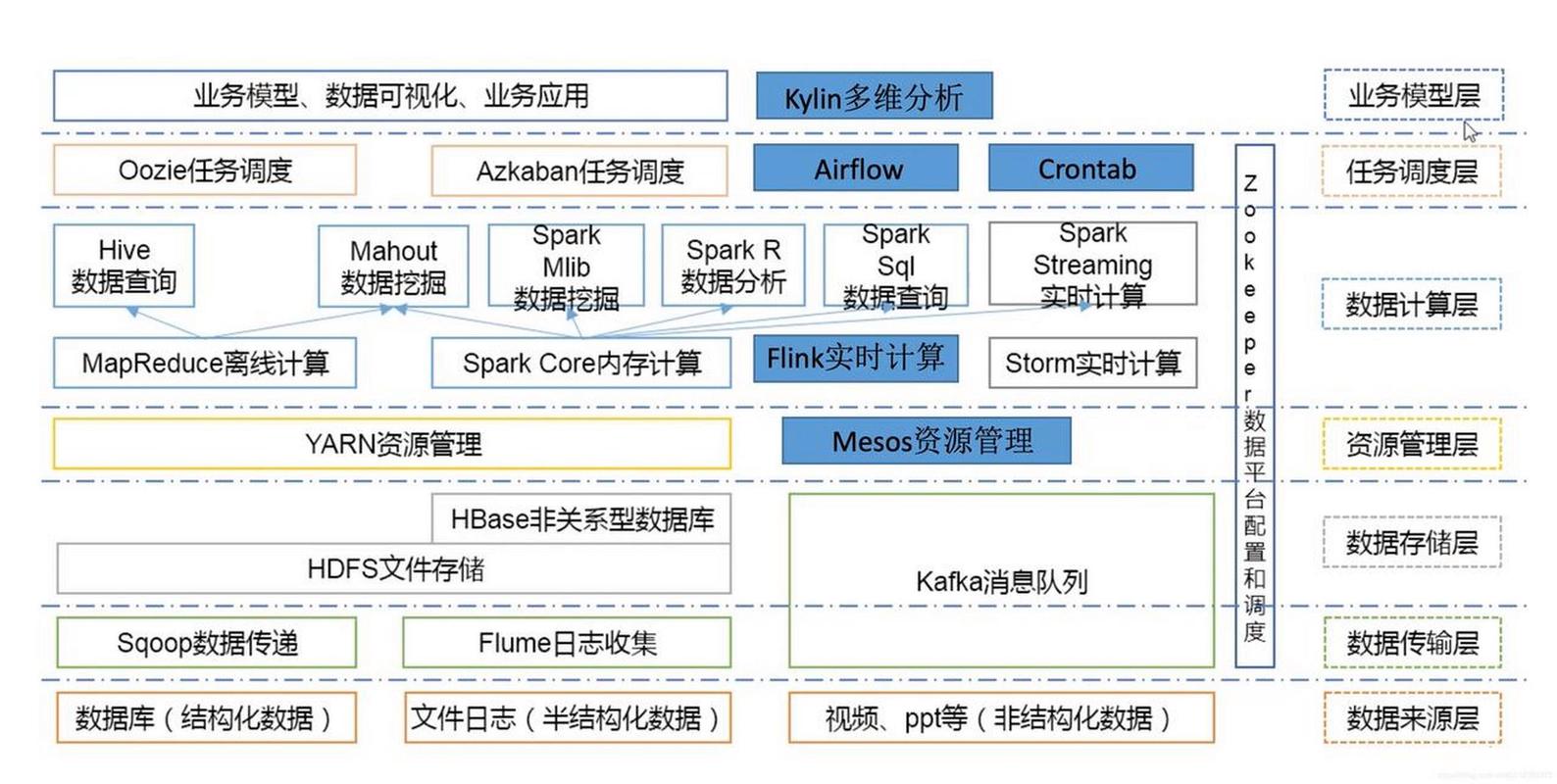

生态系统

Hadoop 生态非常庞大,除了核心的 HDFS 和 YARN,还包括了许多用于数据采集、处理、分析、存储和可视化的组件,共同构成了一个完整的大数据处理平台。

| 组件类别 | 核心组件 | 功能描述 |

|---|---|---|

| 数据采集 | Flume, Sqoop, Kafka | Flume: 日志采集工具,Sqoop: 在 Hadoop 和关系型数据库(如 MySQL)之间传输数据,Kafka: 高吞吐的分布式消息队列,用于实时数据流。 |

| 数据存储 | HBase, Hive | HBase: 分布式、面向列的 NoSQL 数据库,支持实时随机读写,适合海量结构化/半结构化数据,Hive: 构建在 HDFS 之上的数据仓库工具,提供类 SQL 的查询语言(HiveQL),将 SQL 查询转换为 MapReduce 或 Spark 任务执行。 |

| 数据处理 | MapReduce, Spark, Flink, Tez | MapReduce: Hadoop 的原始计算模型,简单但延迟高,Spark: 内存计算框架,比 MapReduce 快几个数量级,是目前的主流,Flink: 流批一体的计算引擎,专注于实时流处理,Tez: DAG(有向无环图)计算引擎,比 MapReduce 更高效,是 Hive 的默认执行引擎。 |

| 资源调度 | YARN | 如上所述,是整个集群的资源管家。 |

| 数据仓库/OLAP | Hive, Impala, Presto, Kylin | Impala/Presto: 提供低延迟的 SQL 查询能力,绕过了 MapReduce,直接访问 HDFS/HBase,Kylin: 分布式分析型数据仓库,为 Hadoop 上的海量数据提供亚秒级查询。 |

| 工作流调度 | Oozie, Azkaban, Airflow | 用于管理和调度多个有依赖关系的 Hadoop 作业,形成一个完整的数据处理工作流。 |

| 协调服务 | ZooKeeper | 分布式协调服务,用于管理集群配置、命名、提供分布式锁和 Leader 选举等,是 Hadoop HA 方案的核心依赖。 |

典型工作流程(以 Hive on Spark 为例)

假设我们需要将 MySQL 中的用户行为数据导入 Hadoop,进行清洗和分析,最后将结果存入 HBase。

- 数据导入: 使用 Sqoop 将 MySQL 中的用户行为表数据导入到 HDFS 的一个指定目录中。

- 任务提交: 用户编写 HiveQL 查询语句,定义数据处理逻辑(如过滤无效数据、按用户分组统计等)。

- 任务解析: Hive 引擎将 HiveQL 解析成一个执行计划(一个有向无环图 DAG)。

- 资源申请: Hive 引擎(作为客户端)向 YARN 的 ResourceManager 提交这个任务,RM 会为这个 Hive 应用分配一个 ApplicationMaster。

- 资源分配: AM 根据任务的需求,向 RM 申请 Container,RM 根据集群各节点的资源状况,由各个 NodeManager 在相应的节点上启动 Container。

- 任务执行: AM 将任务(由 Spark 执行)分发到这些 Container 中,Spark 任务从 HDFS 读取数据,在内存中进行清洗、聚合等计算,然后将结果写入 HBase。

- 任务监控: AM 和 NM 协作,实时监控任务的运行状态,如果某个任务失败,AM 会负责在合适的节点上重新启动它。

- 任务完成: 所有任务执行完毕后,AM 向 RM 注销,释放所有资源,用户可以通过 Hive 查询 HBase 中的分析结果。

部署与运维

搭建和管理一个 Hadoop 集群是一项复杂的工程。

部署模式

- 伪分布式模式: 所有组件(NameNode, DataNode, ResourceManager, NodeManager)都安装在同一台机器上,主要用于开发和测试。

- 完全分布式模式: 组件分布在多台独立的物理或虚拟机上,构成一个真正的生产集群,这是生产环境的标准模式。

- 高可用模式: 为了解决 NameNode 和 ResourceManager 的单点故障问题,通常会部署 Active/Standby 双节点,并使用 ZooKeeper 进行故障自动切换。

集群管理工具

手动部署和配置 Hadoop 集群非常繁琐,现在普遍使用自动化工具:

- Cloudera Manager (CM): 商业软件,功能强大,提供集群的全生命周期管理(安装、配置、监控、告警、诊断),是业界最主流的管理工具。

- Ambari: Apache 开源项目,也提供可视化的集群管理功能,是 Cloudera Manager 的主要开源替代品。

运维监控

- 日志分析: 通过查看 NameNode、DataNode、YARN 等组件的日志来排查问题。

- Web UI:

- HDFS UI: 查看 HDFS 集群状态、文件系统信息、DataNode 状态。

- YARN UI: 查看正在运行和已完成的作业、资源使用情况、各 NodeManager 状态。

- 监控指标: 使用 Prometheus + Grafana 等开源工具,对集群的 CPU、内存、磁盘 I/O、网络流量以及 Hadoop 内部指标进行实时监控和可视化。

发展趋势与挑战

Hadoop 并非一成不变,它也在不断演进以适应新的技术浪潮。

挑战

- 架构复杂: 组件众多,学习曲线陡峭,运维成本高。

- 延迟问题: HDFS 和 MapReduce 的设计初衷是高吞吐、高延迟,不适用于实时交互式查询和低延迟的在线业务。

- 生态割裂: 虽然 YARN 试图统一资源管理,但不同计算框架之间仍有隔阂,数据在不同系统间移动会增加成本和复杂性。

- 云原生挑战: 传统 Hadoop 架构与 Kubernetes 等云原生容器编排系统的融合仍在探索中。

发展趋势

- 云原生与 Serverless: 将 Hadoop 组件容器化,部署在 Kubernetes 上,实现弹性伸缩和按需付费,AWS EMR on EKS, Google Dataproc on GKE 都是这方面的实践。

- 数据湖架构: HDFS 作为数据湖的底层存储,结合对象存储(如 S3, OSS),使用 Spark、Presto、Trino 等引擎进行统一的数据分析,实现了存算分离,架构更灵活。

- AI/ML 融合: Hadoop 集群成为训练和运行大型机器学习模型的重要平台,Spark MLlib、TensorFlow on Spark 等项目让大数据和 AI 更好地结合。

- 湖仓一体: 这是当前最热门的趋势,它试图打破数据湖和数据仓库的界限,在同一个数据存储层上同时支持低成本的原始数据存储和高性能的结构化数据查询,Delta Lake, Apache Hudi, Apache Iceberg 是其代表性技术。

Hadoop 大数据集群技术是现代大数据技术的基石,它通过HDFS解决了海量数据的可靠存储问题,通过YARN实现了计算资源的统一管理和调度,并构建了一个庞大而繁荣的生态系统。

尽管面临着来自云原生、实时计算等新技术的挑战,但 Hadoop 的核心思想和设计哲学(如分而治之、廉价硬件、高容错)依然深刻影响着整个大数据领域,它正以云原生、湖仓一体等新形态,继续在大数据、人工智能和云计算的融合中扮演着至关重要的角色。