这个提示的中文意思是 "Not registered on network",英文界面常见,它的核心意思是:你的手机SIM卡无法被当前的网络运营商(如中国移动、中国联通、中国电信)识别和接受。

这通常不是手机硬件坏了,而是由软件设置、网络或SIM卡问题引起的,我们可以按照从易到难的顺序一步步排查。

第一步:基础排查(最常见,先试试这些)

这些方法简单快捷,能解决大部分问题。

重启手机

这是最简单也最有效的方法之一,有时候只是系统或网络模块出现了一个小故障。

- 操作:长按电源键,选择“重启”或“重新启动”。

检查SIM卡

SIM卡接触不良或位置错误是导致此问题的常见原因。

- 操作:

- 关闭手机。

- 取出SIM卡托盘(通常在手机侧面,用卡针顶一下)。

- 取出SIM卡,检查金属触点是否有污垢、划痕或氧化变黑。

- 用干燥的软布或橡皮擦轻轻擦拭金属触点。

- 将SIM卡重新装回托盘,确保方向正确,然后推回手机。

- 开机后等待几分钟,看问题是否解决。

检查网络信号

确认你当前所在的位置是否有网络覆盖。

- 操作:

- 走到室外或窗边试试,因为室内(尤其是地下室、电梯里)信号可能很弱。

- 确认你的手机欠费停机了,可以给手机充点值,或者用其他手机拨打你的号码试试是否能打通。

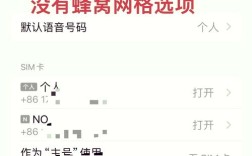

手动选择网络

有时候手机会卡在错误的网络列表上,手动选择一下运营商可以解决问题。

- 操作:

- 进入 “设置”。

- 找到 “连接” (Connections) 或 “移动网络” (Mobile networks)。

- 点击 “网络运营商” (Network operators) 或 “选择手动” (Select manually)。

- 系统会搜索可用的网络,等待搜索完成。

- 在列表中找到你的运营商,

- 中国移动 -> "China Mobile"

- 中国联通 -> "China Unicom"

- 中国电信 -> "China Telecom"

- 点击选择它,手机会尝试重新注册,如果成功,会显示信号。

第二步:进阶排查(如果基础方法无效)

如果以上方法都试过了还是不行,可以尝试以下步骤。

检查APN(接入点名称)设置

错误的APN设置会导致手机能连上网络,但无法上网或被识别,虽然这个错误通常表现为“无法上网”,但有时也会伴随注册问题。

- 操作:

- 进入 “设置” -> “连接” -> “移动网络” -> “接入点名称 (APN)”。

- 检查你的运营商对应的APN设置是否正确,以下是标准设置,你可以核对或重新创建一个:

- 中国移动 (CMCC):

- 名称:

CMCC - APN:

cmnet - 代理: (空)

- 端口: (空)

- 用户名: (空)

- 密码: (空)

- 服务器: (空)

- MMSC:

http://mmsc.monternet.com - MMS代理:

0.0.172 - MMS端口:

80 - MCC:

460 - MNC:

00 - 认证类型:

PAP - APN类型:

default,supl,mms

- 名称:

- 中国联通 (CUCC):

- 名称:

UNINET - APN:

3gnet - (其他字段通常为空)

- 名称:

- 中国电信 (CTCC):

- 名称:

CTNET - APN:

ctnet - (其他字段通常为空)

- 名称:

- 中国移动 (CMCC):

- 检查无误后,保存设置,然后重启手机。

恢复网络设置

这个操作会重置所有网络相关的设置,包括Wi-Fi密码、蓝牙配对和APN设置,但不会删除你的个人数据。

- 操作:

- 进入 “设置”。

- 找到 “一般” (General) -> “重置” (Reset)。

- 点击 “重置网络设置” (Reset network settings)。

- 系统会要求你输入锁屏密码,输入后确认。

- 重启手机后,你需要重新连接Wi-Fi并检查APN设置。

第三步:终极排查(可能性较小)

如果以上所有方法都失败了,才需要考虑以下情况。

检查手机是否被锁网(网络锁定)

这是一个非常关键的可能性。三星S4作为一款老手机,很可能是从国外或通过非官方渠道购买的,并且被锁定了网络。

- 什么是锁网? 手机被绑定在某个特定的运营商(如美国的AT&T、T-Mobile),只能使用该运营商的SIM卡,如果你插入其他运营商的卡(比如插联通卡到一台被AT&T锁定的手机上),就会显示“未在网络上注册”。

- 如何判断?

- 如果你是在国外买的,或者在二手平台买的,这个可能性非常大。

- 你可以尝试插入一张你确定是好的、且和你当前运营商不同的SIM卡(比如你用的是移动,就插一张联通的卡),如果依然报错,那基本可以确定是锁网。

- 如何解决?

- 联系原运营商解锁:如果手机是在国外买的,可以尝试联系原运营商(如AT&T)提供付费解锁服务,但这通常需要满足一些条件(如手机已付清全款、使用满一段时间等),并且对于老手机,他们可能已经不提供解锁服务了。

- 付费找第三方解锁:网上有很多提供解锁服务的商家,你提供手机的IMEI号(在“设置”->“关于手机”里可以找到),他们通常会通过远程方式解锁。请注意选择信誉好的商家,谨防被骗。

- 刷机(风险较高):刷入一个对应你运营商的官方或第三方ROM,有时可以解决锁网问题,但刷机有风险,可能导致手机变砖,且需要一定的技术知识。

硬件故障

才考虑是硬件问题。

-

SIM卡槽损坏:长期插拔或进水可能导致SIM卡槽接触不良或损坏。

-

手机基带芯片问题:负责网络通信的芯片出现故障。

-

如何判断:如果确认手机没有被锁网,并且你的SIM卡在别的手机上工作正常,换了好几张SIM卡在这台S4上都报同样的错,那很可能是硬件问题。

-

解决方法:对于一款老手机,维修成本可能过高,建议考虑更换新手机。

总结与建议

对于你的三星S4,我建议你按以下顺序操作:

- 先重启手机,然后检查SIM卡是否干净、装好。

- 如果不行,去室外,手动选择一次网络运营商。

- 如果还是不行,检查或重置APN设置。

- 如果以上都无效,重点考虑“网络锁定”的可能性,回想一下手机的来源,并尝试用不同运营商的SIM卡测试。

- 如果确定不是锁网,才考虑是硬件故障。

希望这些步骤能帮你解决问题!