AR导航的核心概念

AR导航的核心思想是将虚拟的导航信息(如箭头、路线、POI标签)实时地叠加到用户通过摄像头看到的真实世界画面上,它试图摆脱传统2D地图或语音导航的局限,提供一种更直观、更沉浸、更符合人类空间感知习惯的导航体验。

与传统导航的对比:

- 传统2D地图导航: 用户需要在抽象的地图和现实世界之间反复切换视线,认知负荷高,尤其在复杂路口或立交桥时容易出错。

- 语音导航: 提供指令但缺乏空间上下文,用户需要在大脑中构建路线,容易分心。

- AR导航: “所见即所得”,导航信息直接叠加在真实道路上,用户只需看着前方,就能清晰地知道何时转弯、走哪条路,大大降低了认知负担。

AR导航的关键技术栈

实现一个流畅、准确的AR导航系统,需要依赖一系列复杂技术的协同工作。

传感器融合 - 系统的“感官”

这是AR导航的基石,负责获取设备自身的状态和周围环境的信息,通常融合以下传感器数据:

-

GNSS (全球导航卫星系统,如GPS, GLONASS):

(图片来源网络,侵删)

(图片来源网络,侵删)- 作用: 提供设备的绝对位置(经纬度)和速度,这是确定用户在地图上宏观位置的基础。

- 局限性: 在城市峡谷、隧道、室内等环境下,GPS信号会变弱或丢失,导致定位精度下降或不准确。

-

IMU (惯性测量单元):

- 组成: 包含加速度计和陀螺仪。

- 作用:

- 加速度计:测量设备在三个轴上的线性加速度,可以推算出速度和方向变化。

- 陀螺仪:测量设备的姿态角(俯仰、偏航、滚转),即设备如何朝向。

- 优势: 高频率更新(100Hz+),不受环境影响。

- 局限性: 误差会随时间累积(积分漂移),无法单独提供长期准确的定位。

-

磁力计 (电子罗盘):

- 作用: 测量地球磁场,确定设备的绝对朝向(即磁北方向)。

- 局限性: 易受周围金属物体(如汽车、建筑物钢筋)的磁场干扰。

-

摄像头:

- 作用: 提供视觉信息,是AR显示的窗口,也是计算机视觉算法的输入源,用于场景识别、SLAM等。

传感器融合的核心任务: 将这些不同频率、不同精度、不同特性的传感器数据通过卡尔曼滤波或粒子滤波等算法进行融合,取长补短,生成一个比任何单一传感器都更稳定、精确、连续的位姿(位置+姿态)估计结果。

SLAM (即时定位与地图构建) - 系统的“大脑与眼睛”

当GPS信号不可用时,SLAM技术就变得至关重要。

- 作用:

- 定位: 在未知环境中,设备如何确定自己当前的位置?

- 建图: 在移动的同时,如何构建周围环境的3D或2D地图?

- 实现原理:

- 视觉SLAM (V-SLAM): 通过连续分析摄像头捕捉到的图像,识别特征点(如角点、边缘),并追踪这些特征点在不同帧之间的运动,从而推算出设备的移动轨迹和周围环境的结构。

- 激光雷达SLAM (Lidar-SLAM): 使用激光雷达发射激光束,通过测量反射时间来精确构建高精度的3D点云地图,精度高,但成本也高,多用于自动驾驶领域。

- 在导航中的应用: 在GPS信号弱的区域(如地下车库、室内),SLAM可以接管定位任务,确保AR导航的连续性。

计算机视觉 - 系统的“识别能力”

这是将虚拟信息与真实世界对齐的关键。

-

场景识别与匹配:

- 目标: 识别摄像头画面中的特定物体或场景,如道路、人行横道、交通标志、建筑物等。

- 技术:

- 传统方法: 使用SIFT、SURF等特征点检测与匹配算法,将实时画面与预先加载的地图特征进行比对。

- 深度学习方法: 使用卷积神经网络进行图像分割,将画面中的像素分类为“道路”、“天空”、“建筑”等;或进行目标检测,识别出“红绿灯”、“停止标志”等,这种方法鲁棒性更强。

-

车道级/车道线检测:

- 目标: 精确识别用户当前所在的车道,实现“车道级导航”。

- 技术: 同样依赖CV算法,通过颜色、梯度、纹理等特征来检测和追踪车道线,并结合车辆定位数据,将用户精确地“放置”在正确的车道上。

3D渲染与图形学 - 系统的“画笔”

负责将虚拟的导航元素(箭头、路线、距离标签)绘制到屏幕上。

- 3D引擎: 通常使用OpenGL ES或Vulkan等图形API。

- 核心任务:

- 坐标转换: 这是AR导航的“灵魂”,需要将地图上的虚拟世界坐标,通过设备当前的位姿,转换成摄像头画面上的屏幕像素坐标,这个过程通常通过相机投影矩阵来实现。

- 虚拟对象绘制: 在计算出的屏幕坐标上,绘制2D或3D的导航箭头、路线线条、POI图标等。

- 遮挡处理: 确保虚拟信息能够正确地显示在真实物体的前面或后面,增强真实感,一个转弯箭头应该显示在道路的上方,而不是被一辆虚拟的汽车挡住。

人机交互 - 系统的“沟通方式”

如何让用户轻松地获取信息并操作。

- UI设计:

- 简洁性: 导航信息必须清晰、突出,避免干扰用户对真实世界的观察。

- 信息层级: 最重要的信息(如立即转弯)最大、最醒目;次要信息(如距离)次之。

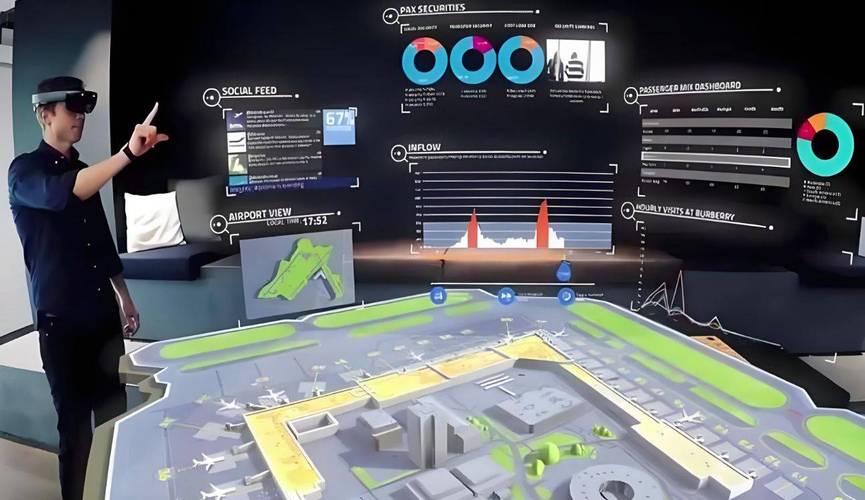

- 3D空间布局: 将信息放置在它所代表的真实物体旁边,形成“空间标注”,将“星巴克”的标签直接放在街角的星巴克门店上方。

- 交互方式:

- 手势: 比如捏合缩放、滑动切换视角等。

- 语音: 结合语音指令,如“返回起点”。

- 物理按钮: 屏幕上的虚拟按钮。

AR导航的实现流程(一个简化示例)

假设用户正在开车,需要从A点到B点:

-

初始化:

- 用户打开AR导航App,输入目的地B。

- App通过GPS获取用户初始位置A,并从服务器下载或本地存储A到B的路径数据(一系列经纬度坐标点)。

-

定位与姿态获取:

- 设备上的传感器融合模块开始工作,持续接收GPS、IMU、磁力计的数据,并融合计算出设备的实时位姿(当前位置和朝向)。

-

视觉感知与环境理解:

- 摄像头持续捕捉前方视频流。

- 计算机视觉模块分析视频流,进行场景识别(识别这是条路)和车道线检测(确定在哪个车道)。

-

虚拟信息生成与对齐:

- 路径规划模块根据当前位姿和预存路径,计算出用户接下来的几个导航指令(“前方200米后右转”)。

- 3D渲染引擎开始工作:

- 它知道“前方200米右转”这个指令对应的真实世界位置。

- 它也知道设备当前的位姿(摄像头指向哪里)。

- 通过坐标转换,计算出这个虚拟指令应该在屏幕的哪个位置显示。

- 在屏幕上绘制一个巨大的、动态的右转箭头,并可能附带“200m”的文字标签。

-

用户交互与反馈:

- 用户看着屏幕,直观地看到箭头指向右前方的路口。

- 当车辆接近转弯点时,系统可能通过SLAM或更精确的视觉定位来修正位置,确保箭头始终精确地叠加在正确的路口上方。

- 用户完成转弯后,系统会自动更新下一个导航指令,并重复上述过程。

挑战与未来趋势

挑战:

- 定位精度与鲁棒性: 如何在所有环境下(城市、乡村、室内、隧道)都提供厘米级的高精度定位,是最大的技术瓶颈。

- 计算性能与功耗: SLAM、CV和3D渲染都是非常耗计算资源和电量的,如何在移动设备上实现流畅运行且不快速耗尽电池是一个难题。 5G/6G网络和更强大的移动芯片是解决方案之一。

- 安全性与驾驶分心: AR导航的沉浸性可能导致用户“盲开”,忽略真实路况,如何设计既直观又不干扰安全驾驶的UI,是产品设计的核心。

- 内容生态与数据更新: 需要高精度的地图数据来支持车道级导航,而地图的实时更新成本高昂。

未来趋势:

- 与自动驾驶深度融合: 在L4/L5级自动驾驶汽车中,AR-HUD(抬头显示)将成为主要的人车交互界面,将导航、车速、路况、ADAS信息直接投射到挡风玻璃上。

- 多模态融合定位: 结合5G/6G网络定位、Wi-Fi定位、蓝牙信标等多种技术,构建一个“永不掉线”的定位系统。

- AI驱动的个性化与预测: AI可以根据用户的驾驶习惯、实时路况,动态调整导航路线和信息的呈现方式,甚至预测用户下一步可能的需求。

- 元宇宙与社交导航: 在AR眼镜普及后,朋友的位置可以以虚拟形象的形式显示在你的视野中,实现社交化的AR导航和探索。

AR导航技术是一项高度复杂的系统工程,它通过传感器融合获取自身状态,利用SLAM和计算机视觉理解环境,再借助3D渲染将虚拟信息精准地叠加到现实世界,最后通过优秀的人机交互呈现给用户,尽管目前仍面临诸多挑战,但随着硬件性能的提升和算法的进步,AR导航正从“酷炫概念”走向“实用工具”,最终将重塑我们的出行和探索方式。