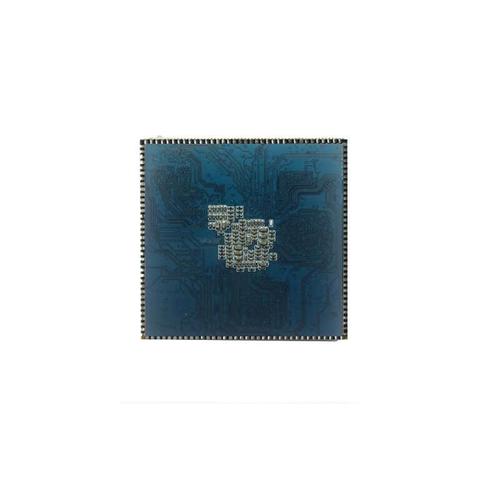

我们通常所说的 “3399pro” 实际上是瑞芯微 RK3399Pro 芯片的简称,而它最重要的升级和亮点之一,就是集成了 NPU(神经网络处理单元)。

RK3399Pro 是一款面向人工智能应用的高性能 SoC,其 NPU 是其核心竞争力,下面我们从几个方面来深入解析它的 NPU 技术。

核心定位与设计目标

RK3399Pro 的 NPU 并不是一个独立的协处理器,而是被深度集成到 SoC 内部,它的核心设计目标非常明确:

- 边缘AI计算:为终端设备(如智能摄像头、机器人、车载终端、工业控制器等)提供强大的本地 AI 推理能力,无需将数据上传到云端,保证低延迟、高隐私性。

- 高效能低功耗:相比于 CPU 或 GPU 处理 AI 任务,NPU 专用架构能以更低的功耗提供更高的 AI 算力,非常适合对功耗敏感的嵌入式设备。

- 多模态AI处理:支持处理来自不同传感器的数据,如图像(来自 ISP)、语音(来自 DSP)、雷达等,实现更复杂的 AI 应用场景。

关键技术规格

这是 RK3399Pro NPU 技术的核心参数,也是衡量其性能的直接指标。

| 项目 | 规格描述 | 解释与意义 |

|---|---|---|

| 架构 | 自主设计的 TPU (Tensor Processing Unit) 架构 | 瑞芯微自研的专用 AI 加速架构,针对神经网络中的张量运算(矩阵乘法、卷积等)进行了高度优化。 |

| 算力 | 最高 3 TOPS (Tera Operations Per Second) | 在 INT8(8位整型)精度下,每秒可进行 3 万亿次运算,这是衡量 NPU 处理速度的关键指标。 |

| 精度 | 主要支持 INT8 | INT8 是当前 AI 边缘计算的主流精度,在模型精度损失可控的情况下,能带来 2-4 倍的算力提升和更低的功耗,也支持 FP16(半精度浮点)和 FP32(单精度浮点)。 |

| 内存 | 集成 32KB SRAM 高速缓存 | NPU 拥有自己独立的高速缓存,可以直接从内存中读取数据,处理完后再写回,减少了与主内存的数据交互瓶颈,提高了运算效率。 |

| 接口 | 与 Rockchip eMMC/SD 控制器紧密耦合 | NPU 可以直接、高效地从 eMMC 或 SD 卡中读取模型和数据进行计算,这对于需要从存储设备加载大型模型的 AI 应用至关重要,避免了复杂的内存拷贝操作。 |

工作原理与技术亮点

TPU 架构的核心:脉动阵列

瑞芯微 NPU 的核心是一个或多个 “脉动阵列”(Systolic Array),这是一种专门为矩阵乘法设计的硬件结构。

- 类比:你可以把它想象成一个由大量简单计算单元构成的网格,数据像血液一样沿着固定的路径(“脉动”)流入这些单元,所有单元并行工作,完成大规模的矩阵乘法运算。

- 优势:神经网络的核心运算(如卷积、全连接层)本质上就是矩阵乘法,脉动阵列架构能将这种运算的效率发挥到极致,远超通用 CPU 的标量计算和 GPU 的流式计算。

高效的内存访问与数据流

NPU 的性能不仅取决于计算单元,还取决于数据能否“喂饱”它,RK3399Pro NPU 在这方面做了优化:

- Direct Memory Access (DMA):NPU 拥有专用的 DMA 控制器,可以独立于 CPU 从主内存中搬运数据,解放了 CPU 的负担。

- eMMC/SD 直连:如前所述,NPU 可以直接与存储控制器交互,这对于需要从 SD 卡或 eMMC 启动并加载 AI 模型的设备(如智能门锁、带 AI 功能的工控机)是一个巨大的性能优势,避免了复杂的内存映射和数据拷贝流程。

灵活的软件支持与生态

硬件的强大需要软件生态来支撑,瑞芯微为 RK3399Pro 提供了完善的 NPU 软件栈:

- SDK (Software Development Kit):瑞芯微官方提供了完整的 SDK,包含了 NPU 的驱动程序、底层算子库和工具链。

- 框架支持:开发者可以非常方便地将主流的 AI 框架(如 TensorFlow, Caffe, PyTorch, MXNet)模型转换并部署到 NPU 上,这通常通过 ONNX (Open Neural Network Exchange) 格式作为中间桥梁来实现。

- 工具链:提供了模型量化工具(将 FP32 模型转为 INT8 模型)、性能分析工具等,帮助开发者优化模型,最大化利用 NPU 的算力。

性能表现与实际应用

性能对比

| 模型 | RK3399Pro NPU (INT8) | RK3399 CPU (FP32) | 性能提升 |

|---|---|---|---|

| MobileNet-v1 | ~30 FPS | ~1 FPS | 30x |

| ResNet-50 | ~10 FPS | ~0.3 FPS | ~33x |

| YOLOv3-tiny | >30 FPS | ~5 FPS | >6x |

注:以上为估算值,实际帧率与模型实现、输入分辨率和硬件配置有关。

从上表可以看出,在处理主流 AI 模型时,RK3399Pro 的 NPU 相比其 CPU 部分,性能提升是数量级的,这意味着过去无法在终端设备上运行的复杂 AI 算法,现在可以流畅运行。

典型应用场景

凭借其强大的 NPU,RK3399Pro 被广泛应用于以下领域:

- 智能安防:

- 人脸识别门禁/考勤:实时进行人脸检测、特征提取和比对。

- 智能摄像头:实现行为分析(如跌倒检测、区域入侵)、车辆识别、烟火检测等。

- 智能车载:

- DMS (驾驶员监控系统):检测驾驶员的疲劳状态(如闭眼、打哈欠)、分心行为(如看手机)。

- ADAS (高级驾驶辅助系统):前向碰撞预警、车道线偏离预警等。

- 机器人与AGV:

- 视觉导航:通过 SLAM(同步定位与地图构建)技术,让机器人自主规划路径。

- 物体抓取:识别和定位特定物体,引导机械臂进行抓取。

- 工业自动化:

- 产品缺陷检测:在生产线上高速、精准地识别产品表面的瑕疵。

- 读码与识别:快速读取和识别产品上的条码、二维码。

- 智慧零售:

- 客流统计与分析:统计进出店铺的人数,并分析顾客的动线和热点区域。

- 智能货架:识别商品是否被拿取或放回。

瑞芯微 RK3399Pro 的 NPU 技术是一款非常成功的边缘 AI 计算解决方案。

核心优势在于:

- 专用架构:自研的 TPU 架构,针对 AI 运算进行深度优化,能效比极高。

- 高集成度:NPU 与 SoC 的其他部分(CPU、GPU、ISP、eMMC 控制器)紧密集成,数据交互高效,减少了延迟和功耗。

- 完善的生态:提供强大的 SDK 和主流框架支持,降低了开发门槛,加速了产品落地。

它的出现,极大地推动了 AI 技术从云端走向终端设备,使得许多曾经只存在于概念中的智能应用,得以在成本和功耗可控的硬件平台上实现商业化,是国产 AIoT(人工智能物联网)领域一颗重要的“芯”。

如果您对 RK3588(RK3399Pro 的继任者)的 NPU 感兴趣,它的 AI 算力更高(可达 6 TOPS),但 RK3399Pro 的 NPU 技术理念和架构是其基础,理解了前者,后者也就触类旁通了。