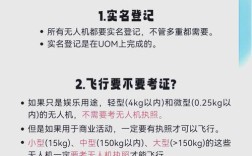

核心原理

理解连接的原理有助于你更好地操作: 无人机和遥控器之间通过4GHz频段进行通信,连接过程本质上是让遥控器与无人机上的飞控系统进行“配对”或“握手”,建立一个专属的、加密的通信链路,一旦连接成功,遥控器才能发送指令(如上升、下降、偏航、拍照),同时也能接收无人机传回的图传信号和状态信息。

通用连接步骤(适用于大多数智能无人机)

这个过程可以总结为:开机顺序 -> 模式切换 -> 等待自动连接 -> 状态确认。

第一步:准备工作

- 电量充足:确保无人机遥控器和飞行电池都已充满电,这是最基本也是最重要的一步。

- 环境检查:

- 找一个开阔、无遮挡的地方进行连接和首次起飞。

- 远离人群、建筑物、高压电线、机场等禁飞区和敏感区域。

- 远离Wi-Fi路由器、蓝牙音箱等强信号干扰源。

- 固件更新:首次使用或长时间未使用时,请务必将无人机和遥控器连接到手机App(如DJI Fly, DJI GO 4),检查并更新到最新的固件,新固件通常包含性能优化和重要修复。

第二步:正确的开机顺序

这是最关键的一步,顺序错了可能导致连接失败!

标准顺序:先开遥控器,再开无人机。

-

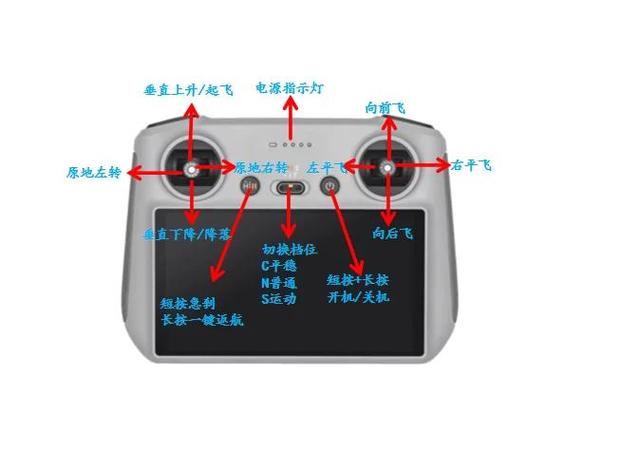

开启遥控器:

(图片来源网络,侵删)

(图片来源网络,侵删)- 按下遥控器上的电源键。

- 等待遥控器完全启动,你会听到开机提示音,看到遥控器屏幕亮起并显示初始界面。

- 重要:给遥控器至少1-2分钟的启动和搜索时间,这让它有时间稳定并准备好连接。

-

开启无人机:

- 按下无人机机身上的电源键。

- 等待无人机启动,你会听到“滴”的一声,并且机臂会展开(如果是折叠机型)。

- 同样,给无人机至少1-2分钟的启动时间。

第三步:等待自动连接

对于绝大多数现代智能无人机(尤其是大疆系列),这个过程是全自动的。

-

遥控器与无人机配对:

- 当遥控器和无人机都启动后,遥控器屏幕上会显示“正在连接”、“搜索信号”或类似的提示。

- 无人机的指示灯会快速闪烁(通常是红色或黄色),表示它正在等待与遥控器配对。

- 无需进行任何额外操作,只需耐心等待,它们会自动在2.4GHz频段上找到对方并完成配对。

-

连接成功:

(图片来源网络,侵删)

(图片来源网络,侵删)- 当连接成功时,你会听到遥控器发出“滴”的一声短促提示音。

- 无人机上的指示灯会变为**常亮(通常是绿色或蓝色)。

- 遥控器屏幕上会显示“已连接”或无人机的图标/名称,并且图传画面应该会显示出来。

第四步:状态确认

连接成功后,请在遥控器屏幕上或手机App上确认以下信息:

- 信号强度:确保信号格是满格或接近满格。

- 图传画面:画面是否清晰、无卡顿、无雪花。

- 状态指示:无人机是否解锁(电机可以响应油门杆),GPS信号是否已获得(屏幕上应有GPS图标或“GPS已定位”的提示)。

主流品牌特定指南:大疆 DJI

大疆无人机是目前市场的主流,其连接流程非常成熟,可以作为优秀范例。

DJI Fly App 连接流程

- 安装与登录:在手机上安装“DJI Fly”App,并登录你的DJI账户。

- 开机顺序:遵循“先遥控器,后飞机”的原则。

- App 自动识别:

- 打开App,它会自动搜索附近的无人机。

- 当App找到你的无人机后,屏幕上会显示无人机的名称和序列号。

- 点击“连接”或“下一步”。

- 遥控器与飞机配对:

- App会引导你将遥控器右侧的拨杆从“P”档(模式三)拨到“F”档(模式一/模式二,根据你的习惯选择),这是为了解锁遥控器。

- 拨动拨杆后,App会提示“正在连接”。

- 等待几秒钟,当连接成功后,App会显示“已连接”,并进入飞行准备界面。

- 激活与校准:

- 首次飞行或更换新部件后,App可能会提示你进行指南针校准,按照屏幕提示,缓慢旋转无人机即可。

- 激活飞行器(如果需要)。

常见问题与解决方法

如果连接失败,可以尝试以下排查步骤:

- 检查电量:确保遥控器和无人机电量都充足。

- 重启:将遥控器和无人机都关机,等待1分钟,然后严格按照“先遥控器,后飞机”的顺序重新开机。

- 距离问题:确保无人机和遥控器之间的距离不要太远(通常建议在1-2米内进行首次连接)。

- 干扰问题:远离Wi-Fi信号塔、大量人群使用手机的区域、无线充电器等强干扰源。

- 固件问题:将两者连接至App,检查并更新固件到最新版本。

- 忘记网络/恢复出厂设置:

- 遥控器:进入遥控器的设置菜单,找到“网络设置”或“Wi-Fi设置”,选择“忘记网络”或“恢复出厂设置”。

- 无人机:有些无人机支持在App中恢复遥控器与无人机的绑定关系。

- 警告:恢复出厂设置后,你需要重新进行所有配对设置。

- 硬件故障:如果以上所有方法都无效,可能是遥控器或无人机的天线、Wi-Fi模块等硬件出现故障,需要联系官方售后。

记住这几个核心要点,连接智能无人机就会变得非常简单:

- 顺序:先遥控器,后飞机。

- 耐心:给设备足够的启动和搜索时间(1-2分钟)。

- 环境:开阔、无干扰。

- 软件:保持固件最新。

希望这份详细的指南能帮助你顺利连接你的智能无人机,享受飞行的乐趣!