- 官方渠道的硬件扩容:苹果官方提供的、在购买时或购买后进行的存储空间升级。

- 第三方渠道的硬件扩容:非官方的、通过更换零件来增加存储空间的方式。

- 软件层面的“扩容”:通过优化和管理来节省存储空间,间接实现“扩容”效果。

下面我将详细解析这三种技术。

官方渠道的硬件扩容

这是最主流、最安全、最推荐的方式,苹果通过在制造阶段集成不同容量的闪存芯片来实现。

a) 制造阶段集成(购买时选择)

这是最根本的扩容方式,苹果在生产iPhone时,就会根据型号配置好不同容量的闪存芯片。

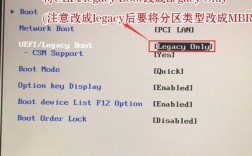

- 技术原理:在iPhone的主板上,有一块专门用于存储数据的NAND闪存芯片,苹果会采购不同容量规格的NAND芯片(如128GB, 256GB, 512GB, 1TB等),在生产线上将其焊接到主板上。

- 特点:

- 性能最佳:官方原厂的NAND芯片与A系列处理器、存储控制器经过了深度优化和匹配,能提供最快的读写速度和最佳的性能稳定性。

- 完美兼容:与iOS系统、硬件完全兼容,不会有任何稳定性问题。

- 保修无忧:在官方渠道购买的任何容量,都享受完整的AppleCare+保修服务。

- 当前主流选择:目前iPhone的存储配置通常从 128GB 起步,中间有 256GB,高端型号则有 512GB 和 1TB 的选项。

b) 官方付费升级(购买后升级)

这是苹果近年来推出的一项非常人性化的服务,允许用户在购买iPhone后的14天内,通过Apple Store App或零售店进行付费升级。

- 技术原理:本质上,苹果会为你更换一块更大容量的主板,因为存储芯片是焊死在主板上的,所以升级存储等同于更换整个主板单元。

- 特点:

- 价格昂贵:这个升级的价格通常比在购买时直接选择大容量要贵不少,从128GB升级到256GB的差价,可能接近于直接购买一个256GB版本与128GB版本的价格差,甚至更高。

- 时间窗口短:仅有14天。

- 优点:对于在购买时犹豫不决的用户来说,这是一个“后悔药”,可以确保你拿到心仪的容量,且全程官方保修。

- 注意:升级后,你的iPhone序列号会与新主板匹配,但你的Apple ID、iCloud数据和Face ID等设置会保留。

第三方渠道的硬件扩容

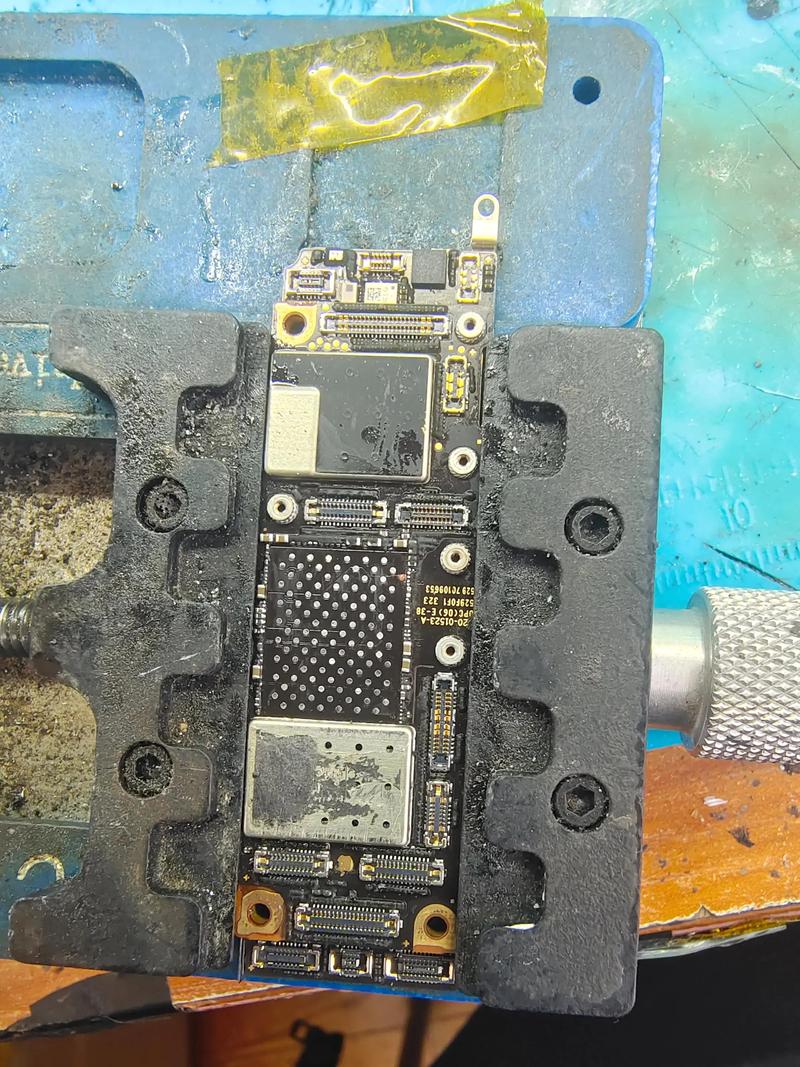

这是指一些第三方维修商通过技术手段,将iPhone的存储芯片更换为更大容量的芯片,这是一种“手术”级别的操作。

a) 芯片级更换/扩容

- 技术原理:

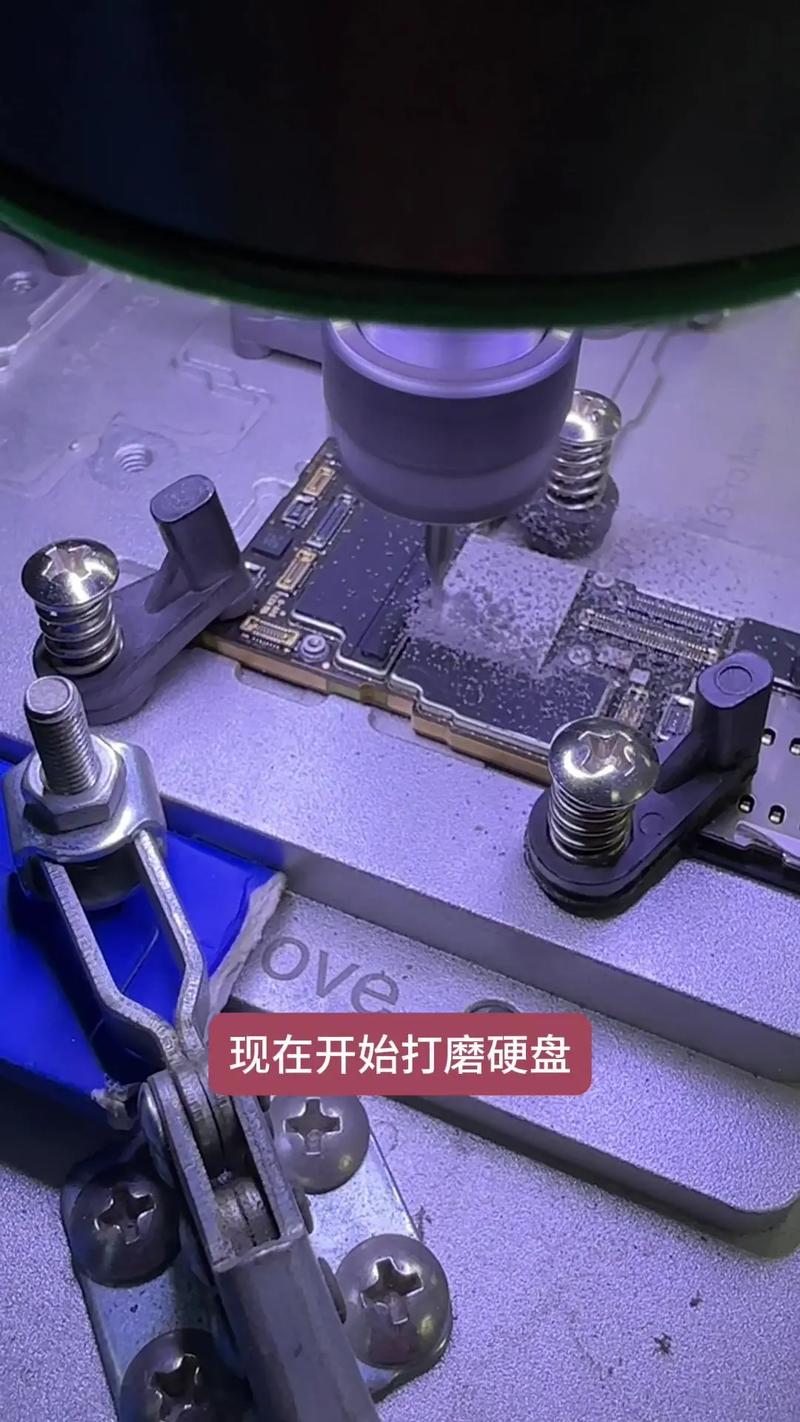

- 专业拆解:需要使用专业的热风枪和精密工具,将iPhone主板上的原厂NAND闪存芯片小心翼翼地拆除,这个过程风险极高,因为主板非常脆弱,过热或操作不当会直接烧毁主板。

- 芯片匹配:寻找一个与原厂芯片型号、主控、闪存颗粒都高度兼容的第三方NAND芯片,兼容性是最大的挑战,不兼容的芯片会导致iPhone无法开机、频繁重启或数据丢失。

- 重新焊接:将新的NAND芯片精确地焊接到主板上原芯片的位置,并确保焊接质量完美。

- 数据迁移与重写:通过专业的设备(如专用的编程器/烧录器)将原手机的基带信息、CPU信息、设备密钥等底层数据从原芯片中读出,然后写入到新芯片中,这一步至关重要,否则iPhone会变成“白苹果”(无法激活)。

- 特点:

- 价格便宜:相比于官方升级,第三方扩容的成本要低得多,通常是官方升级费用的几分之一。

- 风险极高:

- 数据丢失:操作过程中任何失误都可能导致数据永久丢失。

- 硬件损坏:主板烧毁是常见风险,维修成本可能超过手机本身价值。

- 不稳定:即使成功,也可能出现耗电异常、发热、App闪退、系统不稳定等问题。

- 失去官方保修:只要拆机,无论是否成功,都会立即失去苹果官方的保修资格。

- 技术门槛高:只有少数技术精湛的专业维修店才能尝试,且成功率并非100%。

b) 外接存储设备(非扩容,但可增加存储)

这不算“扩容”,而是通过外部设备来扩展存储。

- 技术原理:利用iPhone的接口(如Lightning或USB-C)连接外接存储设备。

- 实现方式:

- 闪存U盘:像iXpand、SanDisk Ultra等,可以直接插在iPhone上,通过App进行文件传输和管理。

- 移动硬盘:通过USB-C转接器连接iPhone,进行大容量文件的备份和传输。

- Wi-Fi硬盘:通过无线网络连接,可以自动备份照片和视频,无需插拔。

- 特点:

- 即插即用:不改变手机本身,安全可靠。

- 携带不便:需要额外携带设备。

- 体验割裂:系统应用(如相机、照片)无法直接调用外部存储,需要手动导入导出,体验不如内置存储。

软件层面的“扩容”

这是一种“软”扩容,通过优化和管理,让现有的存储空间容纳更多内容。

a) iCloud云存储

- 技术原理:将不常用的文件、照片、视频、App数据等自动上传到iCloud服务器,在本地只保留一个轻量级的“替身”或低分辨率版本。

- 功能:

- iCloud照片:可以优化iPhone空间,将原图存在iCloud,本地只保留优化版本。

- iCloud Drive:将文件存储在云端,按需下载。

- 卸载未使用的App:iOS 13及以上系统支持“卸载App”功能,这会删除App本身,但保留其所有数据,当你需要时,可以一键重新下载,数据不会丢失。

- 特点:

- 真正的空间解放:效果最显著,尤其对照片和视频多的用户。

- 需要付费:免费的iCloud空间只有5GB,对于大多数人来说远远不够,升级到50GB、200GB、2TB等需要额外付费。

- 依赖网络:访问云端文件需要良好的网络连接。

b) 存储空间管理

iOS系统内置了强大的存储管理功能。

- 位置:

设置>通用>iPhone 储存空间 - 功能:

- 建议:系统会自动分析存储情况,并给出“卸载未使用的App”、“启用iCloud照片”等建议。

- 查看各App占用:可以清楚地看到每个App及其数据占用了多少空间。

- 清理缓存和临时文件:部分App(如微信、Safari浏览器)可以在这里一键清理缓存,释放大量空间。

- 优化储存空间:针对流媒体视频和音乐,可以选择在低电量时仅下载低质量版本。

总结与建议

| 扩容方式 | 技术原理 | 优点 | 缺点 | 适合人群 |

|---|---|---|---|---|

| 官方购买选择 | 焊接不同容量的原厂NAND芯片 | 性能最佳、最稳定、有官方保修 | 价格固定,购买后无法更改 | 预算充足,对性能和稳定性有高要求的用户 |

| 官方付费升级 | 更换整块主板 | 14天内可“后悔”,官方保修 | 价格昂贵,时间窗口短 | 购买时犹豫不决,短期内就想升级的用户 |

| 第三方芯片更换 | 拆焊主板,更换第三方NAND芯片 | 价格便宜,容量选择灵活 | 风险极高(数据丢失、变砖)、不稳定、失去保修 | 预算极其有限,且愿意承担风险的“技术极客” |

| iCloud云存储 | 将数据上传云端,本地只留副本 | 真正解放本地空间,多设备同步 | 需要付费,依赖网络 | 照片、文件多,且愿意为云服务付费的用户 |

| 软件存储管理 | 清理缓存、卸载App、优化媒体 | 免费、安全、操作简单 | 效果有限,无法突破物理存储上限 | 所有iPhone用户,作为日常维护的必备技能 |

最终建议:

- 最佳选择:在购买iPhone时,根据自己未来1-2年的需求,一步到位选择合适的官方容量,这是最省心、最可靠、体验最好的方式。

- 次优选择:如果预算有限,可以考虑 “官方小容量 + iCloud大订阅” 的组合,购买128GB的iPhone,再订阅200GB的iCloud,既能保证日常应用的流畅运行,又能通过云空间存放大量照片和文件。

- 谨慎选择:强烈不建议普通用户尝试第三方芯片级扩容,其背后隐藏的风险远大于那点价格差带来的好处。

- 必备技能:学会并善用iOS系统自带的 “iPhone 储存空间”管理功能,这是保持手机清爽、高效的日常好习惯。