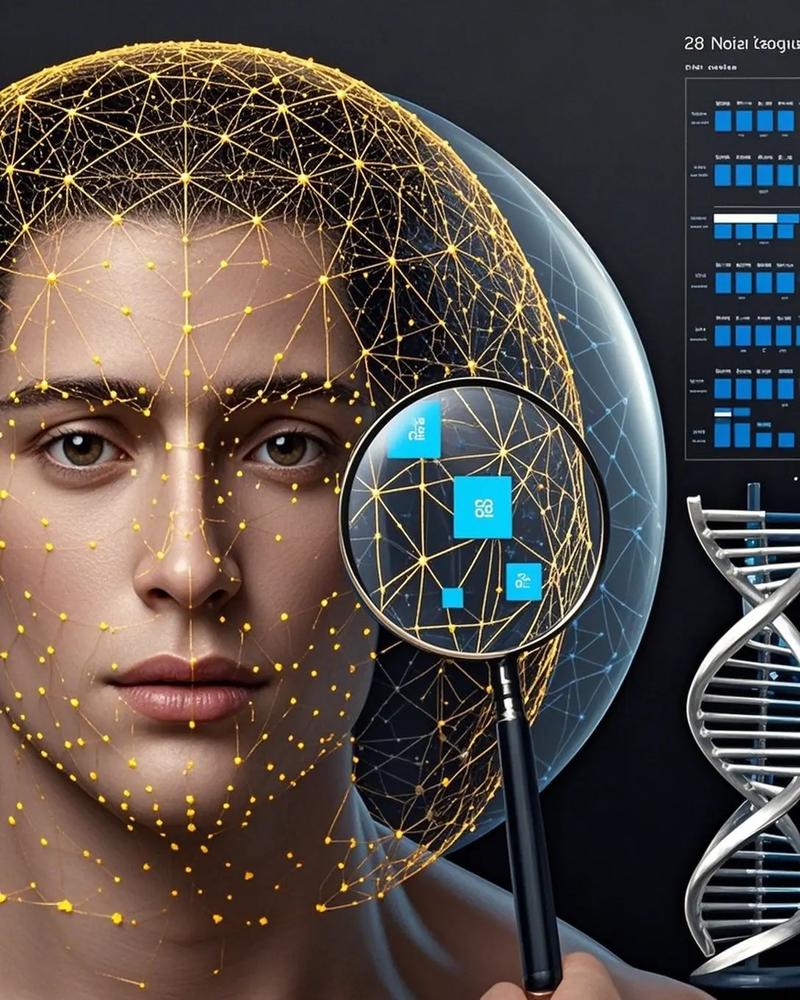

可以把人脸识别想象成一个教计算机“认人”的过程,它分为两个主要阶段:训练阶段 和 应用/识别阶段,整个过程的核心是,将一张人脸图片转换成一串独一无二的数字代码(称为“特征向量”或“人脸编码”),然后通过比较这些代码的相似度来判断是否是同一个人。

下面我们分步拆解这个过程。

核心思想:从“看脸”到“识码”

人类认人,是通过眼睛观察眼睛、鼻子、嘴巴的形状、相对位置、肤色、纹理等综合信息来完成的,计算机不擅长这种直观的、整体的理解,它擅长处理数字,人脸识别的核心任务就是:将一张人脸图像,转换成一个能代表其身份的、高度浓缩的数学向量。

这个过程就像给每个人生成一个唯一的“数字身份证号”,之后所有的识别工作都变成了比较“身份证号”的相似度。

第一步:人脸检测

在一张复杂的图片或视频中,首先要找到人脸在哪里,这个任务叫做人脸检测。

- 目标:在图像中定位出所有人脸的位置,并用一个框(bounding box)把它框出来。

- 常用技术:

- 传统算法:如 Viola-Jones 算法,它使用 Haar-like 特征和级联分类器,速度非常快,适合实时场景,但对复杂姿态和光照变化鲁棒性稍差。

- 深度学习算法:这是目前的主流,使用卷积神经网络,如 MTCNN (Multi-task Cascaded Convolutional Networks),它不仅能检测人脸,还能同时完成人脸对齐,即检测出人脸的关键点(如眼睛、鼻子、嘴巴的中心点),并将人脸进行旋转、缩放,调整到一个标准姿态,这一步为后续的特征提取提供了高质量的输入。

- 输出:一张或多张经过裁剪和标准化的人脸图像。

第二步:人脸对齐

这是人脸检测的延伸,但对于高精度识别至关重要。

- 目标:消除姿态、尺度和旋转带来的差异,将一张侧脸或仰头的脸,通过旋转、缩放,变成一张标准的正面照片。

- 方法:基于上一步检测到的人脸关键点(如5点、68点),通过仿射变换等几何变换,将所有人脸都对齐到同一个坐标系下。

- 重要性:确保了输入给特征提取模型的人脸姿态基本一致,极大降低了姿态变化对识别准确率的影响,让模型更专注于区分身份的特征,而不是姿态特征。

第三步:特征提取

这是整个流程的核心和心脏,它的目标是,将对齐后的人脸图像,转换成一个固定长度的、包含丰富身份信息的向量,这个向量也被称为 Face Embedding 或 人脸编码。

- 目标:提取出能区分不同人的特征,同时忽略掉与环境相关的特征(如光照、发型、化妆、表情等)。

- 技术演进:

- 传统方法:如 Eigenfaces (特征脸)、Fisherfaces、LBPH (Local Binary Patterns Histograms),这些方法依赖于手工设计的特征,在复杂环境下性能有限。

- 深度学习方法:这是当前绝对的主流,使用深度卷积神经网络进行端到端的训练。

深度学习特征提取原理详解

现代的人脸识别模型(如 Google 的 FaceNet、Facebook 的 DeepFace、ArcFace 等)通常是一个精心设计的深度 CNN,它的训练过程非常关键:

-

损失函数设计:模型训练的关键在于损失函数的设计,传统的分类损失(如 Softmax)只关心“这张脸属于 A、B、C... 中的哪一个”,但无法很好地处理“同一个人的不同照片”和“不同人的相似照片”之间的细微差别。

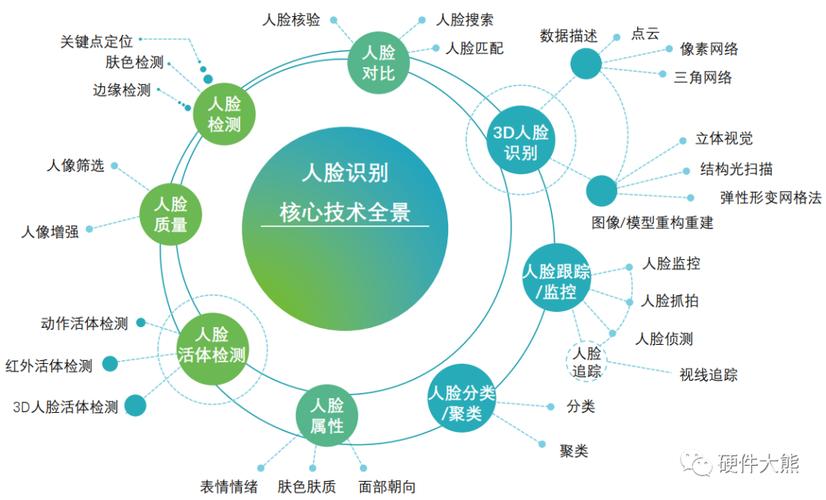

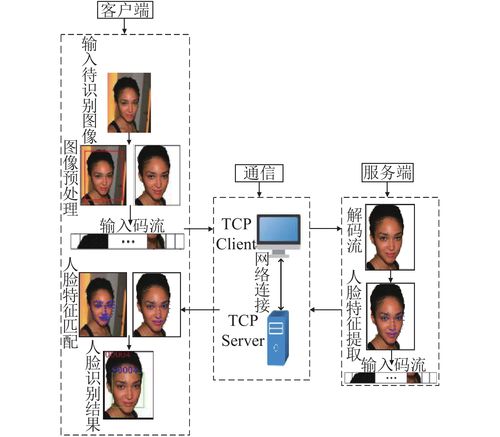

(图片来源网络,侵删)

(图片来源网络,侵删)研究者设计了专门的度量学习损失函数,其核心思想是:“拉近同一个人的距离,推远不同人的距离”。

-

Triplet Loss (三元组损失):模型在训练时,每次输入三张图片:

- 锚点:一张目标人脸图片。

- 正样本:同一个人的另一张图片。

- 负样本:另一个人的图片。

- 目标:让锚点和正样本在特征空间中的距离

d(A, P),小于锚点和负样本的距离d(A, N)一个固定的间隔 ,即d(A, P) + α < d(A, N),通过不断优化,模型学会了如何提取一个能让同一个人“聚在一起”,不同人“分离开”的特征空间。

-

ArcFace (Additive Angular Margin Loss, 弧度间隔损失):这是目前最先进、效果最好的损失函数之一,它直接在特征向量的角度上做文章,它要求:

- 同一个人的不同照片,其特征向量在超球面上对应的点,之间的夹角要尽可能小。

- 不同人的特征向量对应的点,之间的夹角要大于一个预设的“间隔角度”

m。 - 这种方法使得特征空间的区分度更大,识别精度更高。

-

-

模型结构:这些模型通常有非常深的网络结构(如 Inception-ResNet),并包含大量的卷积层、池化层和全连接层,最终通过一个全连接层输出一个固定长度的向量(512维或1024维),这个向量的每一个维度都代表了人脸的某个抽象特征。

-

输出:一个人脸编码。

[0.12, -0.45, 0.89, ..., 0.33],这个向量就是这张脸的“数字身份证”。

第四步:特征比对与匹配

我们有了两张人脸的“身份证”(特征向量),最后一步就是比较它们是否属于同一个人。

-

目标:计算两个特征向量之间的相似度或距离。

-

方法:

- 余弦相似度:最常用的方法,它计算两个向量在特征空间中夹角的余弦值,值域在

[-1, 1]之间。1表示方向完全相同(同一个人)。0表示正交(无关)。-1表示方向完全相反。- 人脸识别中,由于特征向量通常被归一化到单位球面上,余弦相似度就等于它们的点积。

- 欧氏距离:计算两个向量在多维空间中的直线距离,距离越小,相似度越高。

- 余弦相似度:最常用的方法,它计算两个向量在特征空间中夹角的余弦值,值域在

-

决策:

- 计算两个编码之间的相似度得分(如余弦相似度)。

- 设定一个阈值,这个阈值是通过大量实验数据确定的。

- 如果相似度得分 高于 阈值,则判断为“是同一个人”。

- 如果相似度得分 低于 阈值,则判断为“不是同一个人”。

-

1:1 验证 vs. 1:N 识别:

- 1:1 验证:比如手机解锁,你输入一张人脸,与手机里存储的唯一一张人脸模板进行比对,直接计算相似度并判断是否大于阈值即可。

- 1:N 识别:比如在火车站寻找嫌疑人,你输入一张人脸,需要在数据库中存储的成千上万个人脸模板中,找到最相似的一个,这时需要计算输入人脸与数据库中所有人脸的相似度,然后找出得分最高的那一个,如果这个最高分仍然大于阈值,就返回该身份;否则返回“未知”。

技术挑战与应对策略

- 光照变化:强光、背光、阴影都会影响识别。

- 对策:训练时使用各种光照条件下的数据进行数据增强;或使用图像预处理技术(如直方图均衡化)。

- 姿态变化:侧脸、仰头、低头。

- 对策:人脸对齐;使用对姿态变化不敏感的特征提取模型(如 3D 人脸模型)。

- 遮挡物:口罩、墨镜、围巾、头发。

- 对策:训练模型学习人脸未被遮挡部分的鲁棒性;开发专门针对遮挡区域的算法。

- 年龄变化:人随着年龄增长,容貌会改变。

- 对策:使用包含不同年龄段人脸的大规模数据进行训练;选择对年龄变化不敏感的特征。

- 表情变化:微笑、皱眉、惊讶。

- 对策:同样依赖于大规模和多样化的数据训练,让模型关注稳定的骨骼结构,而非暂时的肌肉变化。

- 欺骗攻击:使用照片、视频、面具等冒充真人。

- 对策:引入“活体检测”技术,通过分析微小的动作(如眨眼、转头)、纹理(皮肤的反光、纹理)或使用红外/深度传感器,来判断对象是否为真人。

人脸识别的技术原理可以概括为以下四个关键步骤:

- 检测:在海量图像中找到人脸。

- 对齐:将人脸调整到标准姿态,消除姿态影响。

- 编码:使用深度神经网络将人脸图像转换成一个独特的、高维度的特征向量,这是最核心的一步,通过度量学习损失函数(如 ArcFace)训练,确保“同一个人相似,不同人相异”。

- 匹配:通过计算特征向量间的余弦相似度或欧氏距离,并与预设阈值比较,最终完成 1:1 验证或 1:N 识别。

整个技术体系是一个结合了计算机视觉、机器学习和深度学习的复杂系统工程,其背后是海量的数据、精巧的算法设计和强大的算力支撑。