核心基础

在学习具体的大数据技术之前,这些Java基础是必不可少的,它们是理解大数据框架底层原理的关键。

-

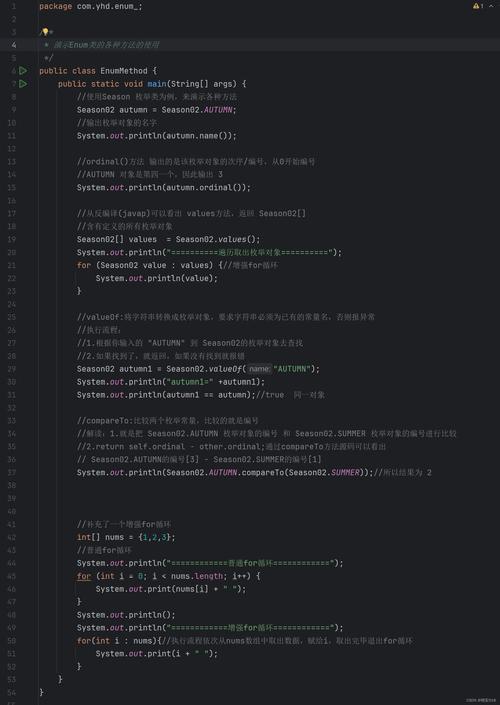

Java SE (Java 标准版)

- 基础语法: 面向对象、集合框架、I/O流、多线程。

- JVM (Java虚拟机): 重中之重,必须理解内存模型(堆、栈、方法区)、垃圾回收机制、类加载机制,大数据框架动辄处理TB/PB级数据,JVM的性能调优是解决线上问题的关键。

- NIO (New I/O): Java 1.4引入的非阻塞I/O模型,是构建高性能网络服务的基础,Netty框架就是基于NIO的,而很多大数据框架的RPC通信都依赖于它。

-

Java Web 开发基础

- Servlet/JSP: 理解HTTP请求/响应、Web应用的生命周期。

- Spring Framework: 现代Java开发的基石,必须熟练使用 Spring Boot,因为它极大地简化了大数据应用的创建和部署,Spring的IoC(控制反转)和AOP(面向切面编程)思想无处不在。

-

网络编程

- TCP/IP协议: 理解三次握手、四次挥手。

- RPC (Remote Procedure Call - 远程过程调用): 大数据集群中,不同节点之间需要频繁通信,RPC是核心技术,需要了解其原理,并能使用成熟的RPC框架。

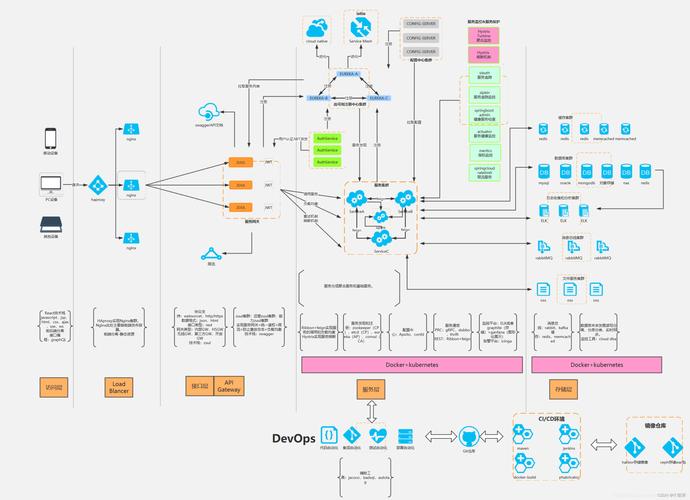

技术生态(核心内容)

这是Java大数据技术的主体,通常被称为“Hadoop生态圈”或“大数据全家桶”,下面我将按技术层次进行划分。

数据存储层

这是大数据的基石,解决了海量数据的低成本、高可靠存储问题。

-

HDFS (Hadoop Distributed File System - Hadoop分布式文件系统)

- 核心思想: 将大文件切分成块(Block,默认128MB)存储在集群的多个DataNode上,通过NameNode管理文件系统的元数据。

- Java技术点: HDFS的Java API是所有上层Hadoop应用与数据交互的入口,学习如何通过Java代码上传、下载、遍历HDFS上的文件。

-

NoSQL 数据库

- HBase: 分布式、面向列的NoSQL数据库,构建在HDFS之上,适用于海量数据的实时随机读写,如存储订单、用户画像等。

- Elasticsearch: 分布式、RESTful风格的搜索和分析引擎,基于Lucene,主要用于日志分析、全文检索、数据可视化。

- Redis: 虽然主要是C语言写的,但Java有非常成熟的客户端(如Jedis, Lettuce),是大数据处理中不可或缺的缓存、消息队列和计数器工具。

资源调度与计算框架

这是大数据处理的核心引擎,负责对存储的数据进行计算和分析。

-

YARN (Yet Another Resource Negotiator - 资源调度器)

- 核心思想: Hadoop的资源管理器,负责集群资源的统一管理和调度,它将计算资源(CPU、内存)从MapReduce计算框架中解耦出来,使得多种计算框架(如Spark、Flink)可以共享同一个集群。

- Java技术点: YARN的Java API用于提交和管理应用程序。

-

批处理计算框架

- MapReduce: Hadoop的原生计算模型,思想简单(分而治之),但性能较慢,现在很多场景已被Spark取代,但其思想仍是理解分布式计算的基础。

- Spark: 当前最主流的分布式计算引擎,以其内存计算、DAG(有向无环图)调度和丰富的库生态著称。

- 核心组件: Spark Core (基础), Spark SQL (结构化数据处理), Spark Streaming (微批处理), MLlib (机器学习), GraphX (图计算)。

- Java技术点: 学习使用 Spark Core 编写Java/Scala程序,重点掌握 RDD (弹性分布式数据集) 的概念和操作。Spark SQL 是目前最常用的组件,需要熟练掌握其DataFrame/Dataset API。

-

流处理计算框架

- Flink: 顶级的流处理引擎,以其真正的流处理、事件时间和精确一次状态一致性保证而闻名。

- Java技术点: 学习使用 DataStream API 编写流处理程序,理解其 Window (窗口)、State (状态)、Time (时间) 等核心概念。

- Spark Streaming: 虽然是微批处理,但在很多实时性要求不高的场景下依然被广泛使用。

数据采集与处理

负责将数据从各种来源采集到大数据平台,并进行初步的清洗和转换。

- Sqoop: 用于在Hadoop和关系型数据库(如MySQL, Oracle)之间进行数据迁移的工具。

- Flume: 分布式、高可用、高可靠的日志采集系统,用于实时采集、聚合和传输大量日志数据。

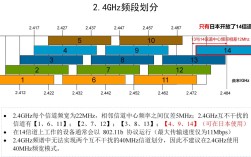

- Kafka: 分布式的消息队列系统,作为大数据的“数据总线”,用于解耦数据生产者和消费者,实现数据的削峰填谷和实时流式管道。

- Java技术点: 学习使用Kafka的Java Producer API生产消息,Consumer API消费消息。

数据仓库与查询

为海量数据提供快速的交互式查询能力。

- Hive: 构建在Hadoop之上的数据仓库工具,它提供了类SQL的查询语言(HiveQL),让熟悉SQL的分析师可以查询存储在HDFS上的大规模数据。

- Java技术点: Hive的底层是将HiveQL语句转换成MapReduce、Tez或Spark任务来执行,了解其原理有助于优化查询性能。

- Impala / Presto / ClickHouse: 这些是MPP(大规模并行处理)架构的SQL引擎,提供了比Hive快几个数量级的交互式查询速度。

- Java技术点: 主要通过JDBC/ODBC driver连接,使用Java程序执行SQL查询并获取结果。

统一协调与工作流

当大数据任务变得复杂,需要多个步骤(如数据采集、清洗、计算、存储)协同工作时,就需要调度工具。

- Azkaban / Oozie: 大数据工作流调度工具,用于定义、调度和监控一个由多个Hadoop作业(如MapReduce, Spark, Hive脚本)组成的工作流。

- Java技术点: 通常通过API或命令行与这些调度器交互,以编程方式触发作业。

典型应用场景与对应技术栈

| 场景 | 描述 | 典型技术栈 |

|---|---|---|

| 用户行为分析 | 网站/App点击流、用户画像分析 | Kafka (采集) -> Flink/Spark Streaming (实时计算) -> HBase (存储用户画像) -> Elasticsearch (检索) |

| 推荐系统 | 基于用户历史行为进行商品/内容推荐 | Spark MLlib (离线特征工程和模型训练) -> Flink (实时特征计算) -> TensorFlow/PyTorch on Spark (深度学习) |

| 日志分析 | 服务器、应用日志的实时监控与分析 | Flume (采集) -> Kafka (缓冲) -> Spark Streaming/Flink (实时分析) -> Elasticsearch + Kibana (存储与可视化) |

| 数据仓库 | 企业级报表、BI分析 | Sqoop (数据导入) -> Hive (数据仓库) -> Impala/Presto (即席查询) |

| 风控反欺诈 | 金融领域的实时交易监控、欺诈检测 | Kafka (交易数据流) -> Flink (实时规则计算和模型预测) -> 实时决策 |

总结与学习路径建议

Java大数据技术 = 坚实的Java基础 + 熟练掌握Hadoop/Spark/Flink等核心框架 + 了解整个数据处理的流程。

建议的学习路径:

- 第一步:夯实Java基础,重点攻克JVM和Spring Boot。

- 第二步:搭建Hadoop环境,动手安装伪分布式集群,理解HDFS和MapReduce的基本原理,并用Java API操作HDFS。

- 第三步:掌握Spark,从Spark Core开始,学习RDD编程,然后重点攻克Spark SQL,这是当前最实用的技能。

- 第四步:学习数据采集工具,掌握Kafka、Flume、Sqoop的基本使用。

- 第五步:深入流处理,学习Flink,理解其与Spark Streaming的本质区别。

- 第六步:学习数据仓库与调度,了解Hive和Azkaban/Oozie的使用。

- 第七步:综合实战,选择一个应用场景(如日志分析),将所学技术串联起来,做一个完整的项目。 你就可以胜任绝大多数Java大数据开发岗位了,这个领域技术更新快,需要保持持续学习的热情。