核心感知与追踪技术

这是AR应用的“眼睛”和“耳朵”,负责让设备理解“我在哪里”、“我朝向哪里”以及“我周围是什么”,这是虚实融合的基础。

-

空间追踪

- SLAM (Simultaneous Localization and Mapping,即时定位与地图构建):这是AR的基石技术,设备在未知环境中,一边实时定位自身位置和姿态(6DoF:3个位置 + 3个旋转角度),一边构建周围环境的3D地图,这使得虚拟物体可以稳定地“放置”在真实世界的固定位置上,不会随着设备移动而漂移或消失。

- VIO (Visual-Inertial Odometry,视觉-惯性里程计):结合摄像头(视觉)和IMU(惯性测量单元,如陀螺仪、加速度计)的数据来估算设备的运动轨迹,VIO是SLAM中非常重要的一部分,能提供更鲁棒、更精准的定位。

-

环境理解

- 平面检测:识别环境中的水平面(如地面、桌面)和垂直面(如墙壁、门),以便将虚拟物体“放置”在真实平面上。

- 物体识别与追踪:识别特定的3D物体(如一本书、一个杯子),并对其进行持续追踪,这使得虚拟信息可以附着在特定物体上。

- 场景理解:更高级的技术,能理解整个场景的语义信息,例如识别出这是一个“客厅”,里面有“沙发”、“茶几”和“电视灯”,从而提供更智能的交互。

-

定位与建图

- GPS/北斗:在户外AR应用中,提供大范围的粗略定位。

- LiDAR (激光雷达):通过发射激光束来精确测量距离,生成高精度的3D点云地图,它不受光照影响,在SLAM和深度感知方面表现优异,是高端AR设备(如Apple Vision Pro, HoloLens 2)的核心传感器。

- 深度传感器:通过结构光或飞行时间(ToF)等技术,直接获取场景的深度信息,帮助设备快速理解周围物体的距离和体积。

核心渲染与显示技术

这是AR应用的“画布”,负责将虚拟信息绘制出来并呈现给用户,这是虚实融合的关键。

-

显示技术

- 光学透视:用户直接透过透明的屏幕(如AR眼镜的镜片)看到真实世界,同时虚拟图像被投射到镜片上,与真实世界融合,这是目前主流的AR眼镜方案,追求“真AR”体验。

- 视频透视:设备上的摄像头先捕捉真实世界的视频流,然后将渲染好的虚拟图像与视频流进行像素级融合,最终将合成后的图像显示在屏幕上,这种方式更容易实现高质量的融合效果,但可能存在延迟和视觉不一致的问题。

-

渲染技术

- 光栅化:传统的实时渲染技术,速度快,是游戏和大多数AR应用的基础。

- 光线追踪:一种更高级的渲染技术,能模拟光线在真实世界中的物理行为,产生极其逼真的光影、反射和折射效果,它能极大提升虚拟物体的真实感,实现与真实环境的无缝融合,但计算量巨大,需要强大的硬件(如NVIDIA的RTX系列)支持。

- 渲染管线优化:为了在移动设备或轻量级眼镜上实现高帧率(如90fps或120fps),需要对渲染管线进行深度优化,包括延迟渲染、实例化渲染等。

-

融合技术

- 色彩/亮度融合:确保虚拟物体的颜色和亮度与真实环境的光照条件相匹配,看起来就像是真实存在的。

- 阴影融合:为虚拟物体生成符合真实光源方向的阴影,这是“欺骗”人眼、增强真实感的最重要手段之一。

- 遮挡关系处理:确保虚拟物体能够正确地被真实物体遮挡,反之亦然,一个虚拟杯子应该放在真实桌子后面,而不是漂浮在桌子上方,这需要深度信息和精确的渲染排序。

核心交互技术

这是AR应用的“手”和“口”,负责让用户能够与虚拟信息进行自然、直观的互动。

-

手势识别

通过计算机视觉算法,识别和追踪用户的手部动作、姿态甚至手指关节的运动,用户可以用“捏”、“抓”、“滑动”等手势来操作虚拟物体。

-

眼动追踪

通过内置的红外摄像头追踪用户的注视点,这不仅能实现“注视点渲染”(只渲染用户注视的区域,大幅降低算力消耗),还能实现“凝视交互”(用眼睛作为鼠标)。

-

语音交互

结合自然语言处理技术,让用户通过语音指令来控制AR应用,把那个桌子移到左边”。

-

空间音频

声音的来源位置与虚拟物体的空间位置绑定,当虚拟物体在用户左侧时,声音也从左侧传来,极大地增强了沉浸感和方位感。

-

控制器/输入设备

类似于VR手柄的物理控制器,提供精确的3D空间定位和按钮/摇杆输入。

支撑与使能技术

这些技术为AR应用提供了平台、内容和工具。

-

硬件平台

- AR眼镜/头显:如Microsoft HoloLens, Magic Leap, Apple Vision Pro, Rokid, Nreal等。

- 智能手机/平板:如iPhone的ARKit, 安卓的ARCore。

- 车载HUD (抬头显示):将导航、车速等信息投射到挡风玻璃上。

-

操作系统与开发框架

- 移动端:Apple ARKit, Google ARCore,它们为开发者提供了SLAM、平面检测、光照估算等底层能力。

- PC/头显端:Windows Mixed Reality SDK, OpenXR (开放标准,旨在统一不同平台的AR/VR开发接口)。

-

创作工具

- 建模软件:Blender, Maya, 3ds Max, Cinema 4D等,用于创建虚拟3D模型。

- 引擎:Unity, Unreal Engine,它们集成了渲染、物理、动画等强大功能,是构建复杂AR应用的核心平台。

- 创作平台:一些低代码/无代码平台,允许非专业开发者快速创建AR应用。

-

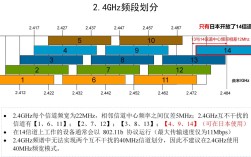

网络与云计算

- 5G/6G:提供高带宽、低延迟的网络连接,使得云端渲染、实时数据同步、多人协同AR成为可能。

- 云渲染:将复杂的渲染任务放在云端服务器完成,再将视频流传输到轻量级的AR终端,降低了终端硬件的压力。

AR虚实融合技术是一个多技术交叉融合的领域,它以SLAM为根基,通过光学/视频显示和光影渲染技术将虚拟世界“画”到真实世界之上,再借助手势、眼动、语音等自然交互方式让用户与融合后的世界互动,并由强大的硬件平台、开发框架和网络提供支撑。

随着AI、5G、新型显示和芯片技术的不断进步,AR虚实融合的真实感、沉浸感和交互自由度正在飞速提升,正逐步从科幻走向现实应用。