公司概况

- 公司名称: 天涯社区网络科技股份有限公司

- 成立时间: 1999年3月

- 创始人: 邢明

- 总部地点: 中国海南海口

- 公司定位: 中国早期的互联网论坛(BBS)巨头,一个综合性的网络社区。

- 上市情况: 曾计划在深交所创业板上市,但于2025年主动撤回申请,至今未上市。

发展历程:辉煌与衰落

天涯社区的历史可以大致分为三个阶段:黄金时代、缓慢转型和危机求生。

黄金时代(1999年 - 2010年左右)

这是天涯社区最辉煌的时期,堪称中国互联网的“舆论广场”和“文化策源地”。

- 开创性地位: 在微博、微信等社交媒体出现之前,天涯社区是网民表达观点、交流思想、分享情感最主要的平台,它以其“开放、包容、自由”的社区氛围吸引了大量早期网民。

- 标志性板块:

- 天涯杂谈: 包罗万象的社会热点讨论区,是草根发声的重要阵地。

- 娱乐八卦: 中国最早的“狗仔”和爆料大本营,许多娱乐圈的猛料在此首发。

- 情感天地: “我欲与君相知,长命无绝衰”的“金婚贴”等经典情感帖在此诞生,是无数人情感宣泄和求助的港湾。

- 关天茶舍、煮酒论史: 高质量的深度讨论区,聚集了大量知识分子和历史爱好者。

- 文化影响力: 天涯社区催生了大量网络流行语和“天涯神贴”,如“贾君鹏,你妈喊你回家吃饭”、“芙蓉姐姐”、“犀利哥”等,它不仅是信息的集散地,更是网络亚文化的孵化器。

- 商业模式: 早期主要依靠网络广告和增值服务(如天涯虚拟社区、VIP会员)盈利,收入一度非常可观。

缓慢转型与挑战(2010年 - 2025年左右)

随着微博、微信等移动社交平台的崛起,用户的时间和注意力被大量分流,天涯社区开始面临严峻挑战。

- 用户流失: 用户逐渐从PC端论坛转向移动端的即时通讯和短内容平台,天涯的活跃度开始大幅下滑。

- 转型困境: 公司尝试向移动互联网转型,推出了移动App,但未能成功复制PC端的优势,产品创新不足,用户体验相对陈旧,未能有效留住年轻用户。

- 管理问题: 随着用户和收入的减少,公司内部管理、内容审核等方面的压力增大,社区氛围也因商业化过重和内容管理问题而逐渐变差。

危机求生(2025年至今)

近年来,天涯社区陷入了前所未有的生存危机。

- 资金链断裂: 由于盈利能力持续下降,公司面临严重的资金问题。

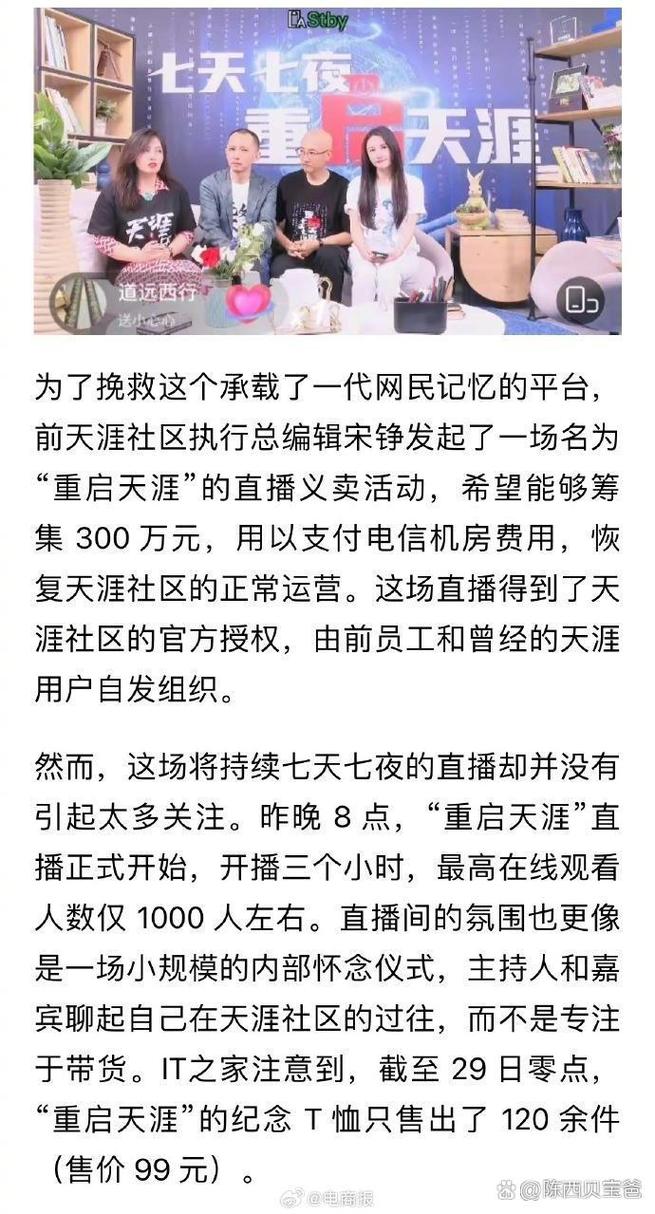

- 服务器欠费风波: 2025年4月,天涯社区因拖欠服务器费用导致官网无法访问,引发了全网对其“关停”的担忧和集体怀念,虽然后来恢复,但此事暴露了其脆弱的生存状态。

- 寻求出售: 创始人邢明多次尝试出售天涯社区,但最终都因各种原因未能成功,2025年底,有消息称天涯社区已进入破产清算程序,但公司方面予以否认,称是“重整”而非“破产”。

- 现状: 尽管面临重重困难,天涯社区的服务器仍在勉强运行,老用户们仍在坚守,形成了一个独特的“怀旧社群”,它从一个主流的互联网平台,变成了一个承载着集体记忆的“数字遗迹”。

商业模式与盈利困境

天涯社区的商业模式始终较为单一,这也是其后期陷入困境的重要原因。

- 网络广告: 这是其主要收入来源,但随着用户流失和广告价值下降,广告收入锐减。

- 增值服务: 如VIP会员、虚拟道具等,但收入有限。

- 内容电商/知识付费: 曾尝试过,但未能形成规模。

- IP孵化与变现: 拥有海量用户生成内容(UGC),但在IP的商业化运作上一直未能成功。

盈利困境的核心原因:

- 用户流失: 没有了流量,一切商业模式都无从谈起。

- 转型失败: 未能适应移动互联网时代的内容消费习惯。

- 管理僵化: 在产品迭代和运营策略上反应迟缓。

文化影响与历史地位

尽管天涯社区已经衰落,但它在历史上的地位是不可磨灭的。

- 一代人的“精神家园”: 对于70后、80后乃至部分90后来说,天涯社区是他们青春记忆的一部分,是他们认识世界、表达自我的第一个窗口。

- 网络舆论的“发源地”: 许多重大的社会事件和网络热点都曾在天涯社区引发热烈讨论,推动了公共议题的形成。

- 网络文化的“孵化器”: 无数网络红人、流行语和故事从这里走向大众,深刻影响了中国互联网的早期文化生态。

- “活着的互联网历史”: 如今的天涯社区,更像是一个互联网时代的博物馆,记录着一个中国网民从萌芽到成熟的完整历程。

天涯社区网络科技股份有限公司的兴衰,是中国互联网行业发展的一个缩影,它抓住了Web 1.0时代的机遇,成为了中文互联网的旗帜;但它也未能跟上Web 2.0和移动互联网的浪潮,最终被时代所抛弃。

它曾经的辉煌,源于其开放、自由的社区精神和高质量的UGC内容;它如今的困境,则警示着所有互联网公司:唯有不断创新,紧跟用户需求,才能在瞬息万变的市场中长久生存。

天涯社区的故事尚未完全结束,它的未来是彻底消失,还是能在怀旧和重整中找到一丝生机,仍是未知数,但无论如何,它在中国互联网历史上的地位,已经载入史册。