Facebook 的大数据技术体系是一个庞大、复杂且不断演进的系统,其核心可以概括为:为海量数据(用户行为、内容、关系链等)提供高效的存储、实时处理、快速查询和智能分析能力。

核心设计哲学与挑战

在深入技术细节前,理解 Facebook 面临的核心挑战和设计哲学至关重要:

- 海量数据:每天有数十亿用户产生 TB 级的新数据(点赞、评论、分享、上传视频、发送消息等)。

- 实时性要求:新闻流、消息推送、广告竞价等场景需要毫秒级到秒级的实时响应。

- 高可用性与容错性:作为核心服务,任何停机都会造成巨大影响,系统必须能自动从故障中恢复。

- 高可扩展性:用户和数据量持续增长,系统必须能水平扩展。

- 数据一致性:在分布式环境下,保证数据在不同副本间的一致性是一个巨大挑战。

- 数据隐私与安全:处理海量用户数据,必须确保数据安全和用户隐私。

基于这些挑战,Facebook 的技术哲学是:自研为主,开源为辅,他们开发了大量内部系统来解决通用问题,并将其中成熟的部分开源(如 Hadoop, Cassandra, Presto, PyTorch 等),这不仅贡献了社区,也吸引了大量顶尖人才。

核心技术栈分层解析

我们可以将 Facebook 的大数据技术栈分为几个关键层次:

数据存储层

这是所有大数据处理的基础,Facebook 需要存储不同类型的数据,因此采用了多种存储系统。

-

HDFS (Hadoop Distributed File System) - 早期基石

- 角色:Facebook 是 HDFS 早期最大的用户之一,它用于存储海量的原始日志文件、用户上传的图片、视频等非结构化或半结构化数据。

- 特点:高吞吐量、高容错性、适合“一次写入,多次读取”的场景。

- 演进:随着业务发展,HDFS 在某些场景下(如高随机读、低延迟)显得笨重,Facebook 在其基础上做了大量优化,并逐渐将部分负载迁移到更高效的存储系统。

-

Haystack - 海量对象存储

- 角色:专门为存储海量小文件(如用户头像、照片缩略图)而设计,直接使用 HDFS 存储数亿个小文件效率极低。

- 原理:将多个小文件合并成一个大的逻辑文件(称为“堆栈”),并构建一个索引来定位每个小文件在堆栈中的偏移量,读取时,通过索引快速定位,然后只读取所需的小文件部分。

- 优势:极大地减少了文件系统的元数据开销,提高了存储和读取效率。

-

Cassandra - 分布式 NoSQL 数据库

- 角色:Facebook 内部最早开发并开源的 NoSQL 数据库,用于需要高可用、高可扩展性和低延迟写入的场景,收件箱、用户关系图谱、社交图谱等。

- 特点:

- 去中心化:没有单点故障。

- 高可用性:数据通过多副本复制,即使部分节点宕机,服务依然可用。

- 最终一致性:在性能和一致性之间做了权衡,非常适合社交网络场景。

- 线性可扩展性:可以轻松添加新节点来扩展集群。

-

Gorilla / MyRocks - 高性能时序数据库与 RocksDB 衍生

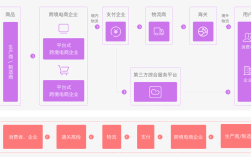

(图片来源网络,侵删)

(图片来源网络,侵删)- Gorilla:为监控指标等时间序列数据设计,提供了极高的压缩率和写入/读取性能。

- MyRocks:基于 Facebook 对 RocksDB(一个基于 LSM-Tree 的嵌入式键值存储)的深度改造和优化,用于需要高写入性能和高效存储的场景,替代了部分 InnoDB 的使用。

-

MySQL / MyRocks - 关系型数据库

- 角色:虽然 NoSQL 很流行,但对于需要事务和复杂查询的场景,关系型数据库依然是必需品,Facebook 对 MySQL 进行了大量定制和优化(如 MySQL 5.6/5.7 的很多特性都源于 Facebook 的贡献)。

- 演进:使用 MyRocks 替代 InnoDB 作为存储引擎,以获得更好的空间效率和写入性能。

数据处理与计算层

这是数据产生价值的核心,分为批处理和流处理。

-

MapReduce - 批处理的开端

- 角色:早期进行大规模离线批处理的核心框架,计算用户的好友推荐、广告点击率统计等。

- 演进:MapReduce 编程模型较为繁琐,且延迟高,Facebook 逐渐将其功能更强大的后继者所取代。

-

Presto / Apache Spark - 现代批处理与交互式查询

- Presto (Facebook 开源):

- 角色:一个分布式的 SQL 查询引擎,专为在 Hadoop 等数据源上进行高速、实时的交互式数据分析而设计。

- 特点:内存计算,速度极快,可以连接多种数据源(HDFS, Cassandra, MySQL 等),分析师和数据科学家用它来跑 ad-hoc 查询,取代了传统的 Hive。

- Apache Spark (Facebook 是重要贡献者):

- 角色:一个统一的 analytics 引擎,用于大规模数据处理,它集批处理、流处理、机器学习和图计算于一体。

- 特点:基于内存的分布式计算,比 MapReduce 快几个数量级,Facebook 广泛使用 Spark 进行 ETL、机器学习模型训练等。

- Presto (Facebook 开源):

-

Apache Flink - 流处理引擎

- 角色:一个真正的流处理引擎,专注于低延迟和高吞吐的实时数据处理。

- 应用:Facebook 使用 Flink 处理实时数据流,例如实时计算广告指标、实时风控、实时更新推荐模型特征等。

-

Apache Kafka - 分布式消息队列

- 角色:Facebook 内部(以及整个业界)事实上的标准数据总线。

- 作用:作为所有实时数据流的入口,负责收集、缓冲和分发来自各个应用的海量实时事件数据(如用户点击、浏览行为),它是连接数据源和流处理/批处理系统的桥梁,实现了系统间的解耦。

数据服务与查询层

处理好的数据需要被快速地提供给上层应用。

-

Scuba / Apollo - 实时数据分析工具

- Scuba:一个面向分析师的内存数据分析工具,可以在数秒内对 PB 级的采样数据进行交互式查询。

- Apollo:Scuba 的后继者,支持更大的数据集和更复杂的查询,是 Facebook 内部最重要的数据分析工具之一。

-

Graph Engine (Graph Search 的基础) - 图计算服务

- 角色:为了支持“图谱搜索”功能,Facebook 需要一个能够对庞大的社交图谱进行实时、复杂查询的系统。

- 特点:专门为图数据结构优化,能够快速执行多跳查询(我朋友的朋友中,喜欢打篮球且住在纽约的人有哪些?”)。

-

内部 API 服务

数据经过处理后,会通过一系列内部 API 暴露给前端应用,如新闻流 API、广告 API、推荐系统 API 等,这些服务保证了查询的低延迟。

机器学习与人工智能层

这是 Facebook 数据价值的升华,驱动着个性化推荐、内容理解、广告投放等核心业务。

-

FBLearner Flow - 机器学习平台

- 角色:Facebook 内部统一的、端到端的机器学习平台,它集成了数据准备、特征工程、模型训练、模型评估和模型部署的全流程。

- 特点:支持多种机器学习框架(如 PyTorch, TensorFlow),自动化了许多繁琐的步骤,让数据科学家和工程师可以更专注于算法和业务逻辑。

-

PyTorch - 开源深度学习框架

- 角色:由 Facebook AI Research (FAIR) 主导开发并开源,已成为学术界和工业界最受欢迎的深度学习框架之一。

- 应用:用于图像识别(自动给照片打标签)、自然语言处理(翻译、内容理解)、推荐系统、语音识别等几乎所有 AI 领域,Facebook 内部大量使用 PyTorch 进行研究和模型训练。

-

ONNX (Open Neural Network Exchange) - 模型交换格式

- 角色:由 Facebook 和微软等公司共同发起,旨在解决不同深度学习框架模型之间的互操作性问题。

典型应用场景的技术实现

-

个性化新闻流:

- 数据收集:用户的各种行为(点赞、评论、停留时间)通过 Kafka 实时流式收集。

- 特征计算:Flink/Spark Streaming 实时计算用户兴趣、内容热度等特征。

- 模型推理:一个基于 PyTorch 训好的深度学习模型(如 DeepRank)接收这些特征,预测用户对每条内容的兴趣得分。

- 排序与聚合:根据得分对候选内容进行排序,结合社交关系等因素,生成最终的新闻流。

- 实时更新:整个过程在几秒内完成,保证内容的“新鲜感”。

-

精准广告系统:

- 用户画像:通过分析用户的社交关系、兴趣、行为等海量数据,在 HDFS/Cassandra 中构建详细的用户画像。

- 实时竞价:当用户访问一个页面时,广告请求会发出,系统需要在毫秒级内:

- 获取用户画像。

- 匹配广告库。

- 通过 FBLearner Flow 训好的点击率/转化率模型预估每个广告的价值。

- 进行竞价,并返回最高胜出的广告。

- 效果归因:后续通过 Presto/Spark 对广告的点击、转化等数据进行离线分析,优化模型和投放策略。

总结与未来趋势

Facebook 的大数据技术栈是一个典型的“技术驱动业务”的范例,其技术演进有几个明显的趋势:

- 统一化:从多种独立的批处理、流处理工具,向以 Spark/Flink 为核心的统一计算引擎演进,简化技术栈和运维。

- 实时化:越来越强调流批一体,追求“批处理实时化,流处理准实时化”,让数据价值更快地体现。

- AI/ML 原生化:机器学习不再是事后分析,而是深度嵌入到数据处理的各个环节,成为数据管道的默认组件。

- 云原生与 Serverless:正在将更多工作负载迁移到 Kubernetes 等云原生平台上,并探索 Serverless 架构,以进一步提升资源利用率和开发效率。

- 图计算的重要性:随着社交图谱的日益重要,图数据库和图计算引擎(如 Apache Spark GraphX, Galois)的应用会更加广泛。

Facebook 的大数据技术是一个庞大而精密的生态系统,它通过不断的技术创新,不仅支撑了自身的业务增长,也为整个大数据领域贡献了众多宝贵的开源资产。