核心要点

- 前提条件:你的台式机必须有一个无线网卡,这通常是一个USB接口的无线网卡,或者是主板内置的(比较少见),如果没有,你需要先购买一个并插入USB口。

- 驱动程序:这是最关键的一步,XP系统自带很多驱动,但对于较新的无线网卡,可能需要手动安装驱动程序。

- 安全警告:Windows XP已经停止支持,存在严重的安全漏洞。强烈建议你仅将其用于连接到安全的、可信任的家庭网络,并避免进行网上银行等敏感操作,为了安全,请考虑升级操作系统或使用更现代的电脑。

第一步:安装无线网卡驱动程序

在连接网络之前,电脑必须先能“认识”你的无线硬件。

Windows XP 自动识别并安装驱动

- 将USB无线网卡插入台式机的USB接口。

- 系统会弹出“找到新硬件向导”窗口。

- 选择 “是,仅这一次(Y)”,然后点击“下一步”。

- 选择 “自动安装软件(推荐)”,然后点击“下一步”。

- 系统会尝试从Windows Update或自身驱动库中寻找并安装合适的驱动,如果成功,它会提示你“完成找到新硬件向导”,点击“完成”即可。

自动安装失败,需要手动安装驱动(最常见)

如果自动安装失败,或者你的无线网卡比较新,你需要手动安装驱动。

-

找到驱动程序:

- 最佳来源:在你购买无线网卡时,通常会附带一张驱动光盘,这是最可靠的方式。

- 替代来源:去你无线网卡品牌的官方网站,根据网卡型号下载适用于Windows XP的驱动程序,将下载好的驱动文件(通常是

.zip或.exe格式)存放在U盘里。

-

打开设备管理器:

- 在桌面右键点击“我的电脑” -> “属性”。

- 在弹出的窗口中,切换到“硬件”选项卡。

- 点击“设备管理器”按钮。

-

找到未知设备:

(图片来源网络,侵删)

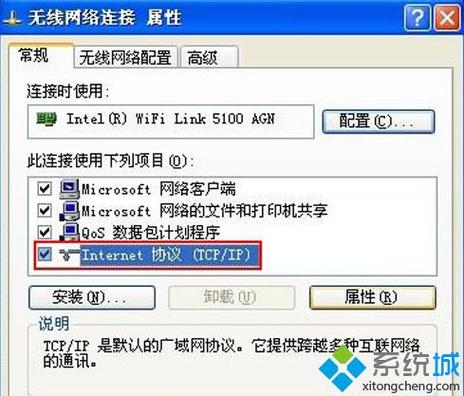

(图片来源网络,侵删)- 在设备管理器列表中,找到并展开“网络适配器”。

- 你可能会看到一个带黄色问号或感叹号的设备,名称可能像 “USB 2.0 WLAN Card”、“PCIe GBE Family Controller” 或直接显示为 “未知设备”,这就是你的无线网卡。

-

手动安装驱动:

- 右键点击这个未知设备,选择“更新驱动程序(D)...”。

- 在弹出的向导中,选择 “从列表或指定位置安装(高级)(S)”,然后点击“下一步”。

- 选择 “不要搜索,我要自己选择要安装的驱动程序(D)”,然后点击“下一步”。

- 点击“从磁盘...”按钮。

- 点击“浏览...”,然后导航到你存放驱动程序的U盘或文件夹,找到并选择那个

.inf文件(这是一个信息文件,告诉系统如何安装驱动),然后点击“打开”。 - 点击“确定”返回,然后你会看到网卡型号出现在列表中,选中它,点击“下一步”。

- 系统开始复制文件,完成后点击“完成”。

-

验证安装:

回到“网络适配器”列表,如果那个带问号的设备已经变成了你网卡的具体型号("TP-Link TL-WN823N Wireless USB Adapter"),并且设备状态正常,说明驱动安装成功了。

第二步:连接到无线网络

驱动安装成功后,就可以连接网络了。

使用Windows XP自带的无线路由器客户端(推荐)

-

打开无线网络连接界面:

- 在桌面右下角任务栏的通知区域,找到并右键点击无线网络图标(它看起来像两台显示器通过信号波连接)。

- 在弹出的菜单中选择“查看可用的无线网络”。

-

搜索并选择网络:

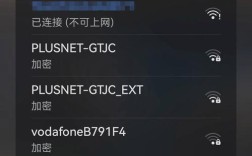

- 会弹出一个名为“无线网络连接”的窗口,系统会自动搜索周围的无线网络。

- 在“首选网络”列表中,找到你要连接的Wi-Fi名称(SSID),然后点击它选中。

-

输入密码(安全密钥):

- 点击窗口右下角的“连接”按钮。

- 如果你的Wi-Fi设置了密码,系统会弹出“网络密钥”对话框。

- 在“网络密钥”和“确认网络密钥”栏中,输入你的Wi-Fi密码。

- 确保 “用这个键启动IEEE 802.1x认证” 这个选项是未勾选状态。

- 点击“连接”。

-

等待连接成功:

系统会尝试连接,连接成功后,状态会变为“已连接”,你就可以上网了。

使用无线网卡厂商的管理工具

很多USB无线网卡会自带自己的管理软件,图标通常是一个品牌Logo,出现在任务栏右下角。

- 右键点击这个图标,选择“扫描”或类似选项。

- 扫描完成后,在列表中找到你的Wi-Fi名称。

- 选中它,然后点击“连接”。

- 在弹出的窗口中输入密码,然后确认。

- 这种方式通常功能更强大,比如能显示信号强度、连接速度等。

常见问题与解决方法

问题1:任务栏没有无线网络图标怎么办?

- 右键点击任务栏空白处,选择“属性”。

- 在弹出的窗口中,切换到“任务栏”选项卡。

- 点击“自定义...”按钮。

- 在列表中找到“无线网络连接”或“Wireless Network Connection”这一项。

- 将其“图标行为”设置为“显示图标和通知”。

- 点击“确定”保存。

问题2:搜索不到任何无线网络,或者列表是空的?

- 原因1:无线网卡开关未打开,有些USB网卡上有一个物理开关,确保它已打开。

- 原因2:驱动安装失败,返回第一步,重新检查设备管理器中无线网卡的状态,确保没有黄色感叹号。

- 原因3:距离路由器太远,或者有信号屏蔽物(如墙壁、金属),尝试将台式机靠近路由器再试。

问题3:能搜索到网络,但连接时提示“无法连接”或需要输入不存在的网络密钥?

- 原因1:Wi-Fi密码输入错误,请仔细核对大小写和特殊字符。

- 原因2:网络类型不匹配,XP对某些新的安全协议(如WPA2-Enterprise)支持不好,尝试在路由器端暂时将安全类型设置为 WPA-Personal (TKIP) 或 WPA2-Personal (AES),而不是混合模式。

- 原因3:MAC地址过滤,检查你的路由器设置,是否开启了MAC地址过滤,并添加了你电脑无线网卡的MAC地址,你可以在“无线网络连接状态” -> “支持” -> “详细信息”中找到你的MAC地址。

希望这份详细的指南能帮助你成功设置无线网络!