TensorFlow 技术分享:从概念到实践的全面解析

大家好!

今天非常荣幸能在这里和大家一起深入探讨当今最流行、最强大的开源机器学习框架之一——TensorFlow。

本次分享将分为以下几个部分:

- TensorFlow 是什么? - 核心概念与定位

- 核心架构:计算图 与 Eager Execution - TensorFlow 的两大范式

- 核心组件:TensorFlow 2.x 的基石 - Keras,

tf.data,tf.function - 实战演练:构建你的第一个模型 - 一个完整的端到端示例

- TensorFlow 生态系统 - 不仅仅是核心库

- 最佳实践与性能优化 - 如何写出高效的 TF 代码

- 未来展望 - TensorFlow 的发展方向

- 总结与 Q&A

TensorFlow 是什么?

一句话概括:TensorFlow 是一个端到端的开源机器学习平台。

- “Tensor”(张量):是多维数组,是 TensorFlow 中数据的基本单位,你可以把它理解为 NumPy 的

ndarray,但它可以在 GPU 或 TPU 上运行,并且支持自动求导。 - “Flow”(流):指数据流图,在早期版本中,你首先要定义一个计算图,然后数据(张量)在这个图上流动,经过一系列计算,最终得到结果。

TensorFlow 的核心优势:

- 灵活性:既可以用于快速原型验证,也可以部署到生产环境。

- 跨平台:支持 CPU、GPU、TPU,并且可以轻松部署到服务器、移动设备、浏览器和云端。

- 生态系统:拥有 Keras、TensorBoard、TensorFlow Lite、TensorFlow Serving 等丰富的工具链,覆盖了从开发到部署的全流程。

- 社区强大:拥有全球最大的开发者社区之一,遇到问题很容易找到解决方案。

核心架构:计算图 与 Eager Execution

理解 TensorFlow 的关键在于理解它的两种执行模式。

A. 计算图 模式

这是 TensorFlow 1.x 的核心思想。

- 定义阶段:你像画流程图一样,定义所有的计算操作(加法、矩阵乘法等)和数据(张量),这个图描述了计算的结构,但此时不进行任何实际计算。

- 执行阶段:你创建一个会话,将数据(输入)喂入图中,启动计算,得到最终结果。

优点:

- 性能优化:框架可以在执行前对整个计算图进行优化,比如常量折叠、算子融合等。

- 部署友好:计算图可以被序列化,方便在不同平台(如移动端、服务器)上部署和执行。

缺点:

- 调试困难:定义和执行是分离的,导致调试体验不佳,你无法在定义阶段直接看到张量的值。

B. Eager Execution (即时执行)

这是 TensorFlow 2.x 的默认模式,也是现代深度学习框架(如 PyTorch)的主流模式。

- 即时定义,即时执行:代码的执行顺序和 Python 的运行顺序完全一致,操作会立即被执行,就像写普通的 Python 代码一样。

- Pythonic:代码更直观、更易于调试,你可以使用

print()直接打印张量的值,可以使用 Python 的if/else、for循环等控制流。

优点:

- 易于学习和调试:对初学者非常友好,调试体验极佳。

- 与 Python 生态系统无缝集成:可以方便地使用 NumPy、Pandas 等库。

缺点:

- 性能开销:单个操作的性能可能不如计算图模式,因为缺少了全局的优化。

如何结合两者?

TensorFlow 2.x 提供了完美的解决方案:@tf.function 装饰器。

你可以用 Eager Execution 的方式编写代码,然后使用 @tf.function 将其“编译”成一个高性能的计算图,这样既保留了 Eager Execution 的易用性,又获得了计算图模式的性能优势。

import tensorflow as tf

# 使用 Eager Execution 编写直观的代码

def simple_layer(x, y):

return tf.matmul(x, y) + tf.constant(1.0)

# 使用 @tf.function 将其转换为计算图

@tf.function

def decorated_simple_layer(x, y):

return tf.matmul(x, y) + tf.constant(1.0)

# 使用方式完全相同

x = tf.random.uniform((2, 2))

y = tf.random.uniform((2, 2))

print(decorated_simple_layer(x, y))

核心组件:TensorFlow 2.x 的基石

A. Keras - 高级 API

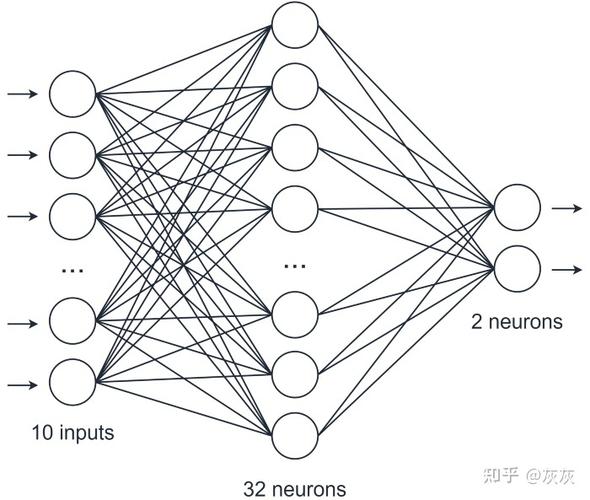

Keras 是 TensorFlow 的官方高级 API,旨在让构建和训练模型变得尽可能简单。

- 模型构建:使用

tf.keras.Sequential或tf.keras.Model类可以轻松地构建复杂的神经网络。 - 内置层:提供了 Dense、Conv2D、LSTM 等各种预定义的层。

- 训练与评估:

model.compile()配置优化器、损失函数和评估指标,model.fit()开始训练。

model = tf.keras.Sequential([

tf.keras.layers.Dense(128, activation='relu', input_shape=(784,)),

tf.keras.layers.Dropout(0.2),

tf.keras.layers.Dense(10, activation='softmax')

])

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

B. tf.data - 数据输入管道

处理数据是机器学习中最耗时、最关键的一环。tf.data 提供了一套强大的工具来构建高性能的数据输入管道。

- 高效:支持从内存、文件(TFRecord)、生成器等多种来源读取数据。

- 可扩展:支持数据预加载、缓存、并行处理和批处理,可以轻松处理海量数据。

- 转换灵活:提供

map()(数据增强)、filter()(过滤)、shuffle()(打乱)等丰富的数据转换操作。

# 创建一个数据集 dataset = tf.data.Dataset.from_tensor_slices((images, labels)) # 构建数据管道 dataset = dataset.shuffle(1000).batch(32).prefetch(tf.data.AUTOTUNE) # 在训练时直接使用 model.fit(dataset, epochs=10)

C. tf.GradientTape - 自动微分

这是 TensorFlow 的“魔法”所在,它记录了所有在 with tf.GradientTape() 上下文内的操作,然后可以自动计算任何可训练变量相对于某个损失函数的梯度。

- 底层原理:在训练神经网络时,我们需要计算损失函数对模型权重的梯度,然后用优化器(如 Adam)来更新权重。

GradientTape让这个过程变得自动化。

# 定义模型和优化器

model = MyModel()

optimizer = tf.keras.optimizers.Adam()

# 训练步骤

def train_step(images, labels):

with tf.GradientTape() as tape:

predictions = model(images)

loss = loss_object(labels, predictions)

gradients = tape.gradient(loss, model.trainable_variables)

optimizer.apply_gradients(zip(gradients, model.trainable_variables))

实战演练:构建你的第一个模型

让我们用 TensorFlow 2.x 的标准流程,构建一个简单的 MNIST 手写数字分类模型。

步骤 1:加载数据

import tensorflow as tf mnist = tf.keras.datasets.mnist (x_train, y_train), (x_test, y_test) = mnist.load_data() x_train, x_test = x_train / 255.0, x_test / 255.0 # 归一化

步骤 2:构建模型

使用 Keras Sequential API。

model = tf.keras.models.Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28)),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dropout(0.2),

tf.keras.layers.Dense(10, activation='softmax')

])

步骤 3:编译模型

选择优化器、损失函数和评估指标。

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

步骤 4:训练模型

使用 tf.data 也可以,但 MNIST 数据集较小,直接 fit 即可。

model.fit(x_train, y_train, epochs=5)

步骤 5:评估模型

test_loss, test_acc = model.evaluate(x_test, y_test, verbose=2)

print(f'\nTest accuracy: {test_acc}')

这个例子展示了 TensorFlow 2.x 的简洁和强大,短短十几行代码就完成了一个完整的机器学习流程。

TensorFlow 生态系统

TensorFlow 的强大之处在于其完整的生态系统。

- TensorBoard:可视化工具,可以监控训练过程中的损失、准确率、模型结构、权重分布等,是调试和优化的必备工具。

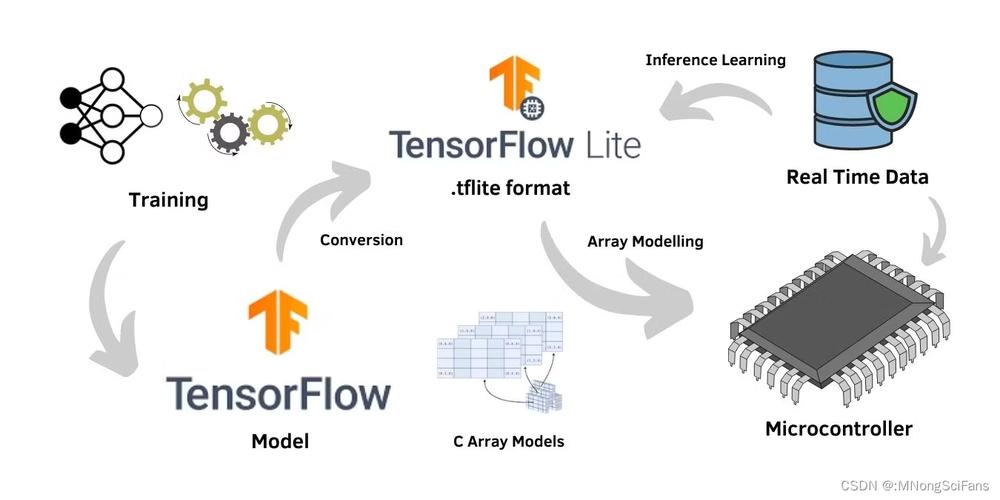

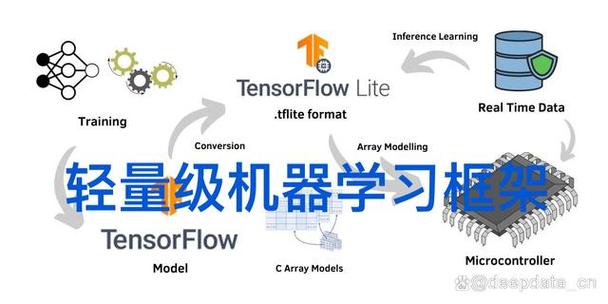

- TensorFlow Lite:用于在移动设备、嵌入式系统和物联网设备上部署模型,支持模型量化,可以显著减小模型体积并提升推理速度。

- TensorFlow Serving:用于在生产环境中部署和提供 TensorFlow 模型服务,支持模型热更新和高性能的 gRPC/HTTP API。

- TensorFlow.js:用于在浏览器中运行 TensorFlow 模型,可以进行客户端的机器学习推理,也可以在浏览器中进行模型训练。

- TensorFlow Extended (TFX):用于构建和管理大规模、生产级的机器学习流水线,涵盖了数据验证、模型分析、模型部署等整个 MLOps 流程。

最佳实践与性能优化

- 使用

tf.data:始终使用tf.data来构建你的数据输入管道,并使用.prefetch(tf.data.AUTOTUNE)和.cache()来最大化 I/O 性能。 - 使用

@tf.function:将你的训练循环和计算密集型函数用@tf.function装饰起来,以获得接近静态图的性能。 - 混合精度训练:使用

tf.keras.mixed_precision模块,在支持 GPU 的模型中启用混合精度(float16/float32),这可以减少内存占用并加速计算,通常对模型精度没有影响。 - 利用 GPU/TPU:确保你的代码能充分利用硬件加速,TensorFlow 会自动将操作放到 GPU 上,但了解

tf.device上下文管理器可以帮助你更精细地控制。 - 模型量化:在部署前,考虑使用 TensorFlow Model Optimization Toolkit 对模型进行量化,以减小模型大小并提高推理速度。

未来展望

- Keras 3.0:未来的 Keras 将成为一个多后端框架,不仅支持 TensorFlow,还支持 JAX 和 PyTorch,实现 API 的统一。

- JAX 集成:JAX 是 Google 的另一个高性能计算库,深受研究者喜爱,TensorFlow 正在加大对 JAX 的支持,将 JAX 的一些高级特性(如

jax.jit,jax.pmap)引入到 TensorFlow 中。 - 更强大的 TFX:随着 MLOps 的重要性日益增加,TFX 将继续演进,提供更自动化、更智能的机器学习运维工具。

- AutoML 集成:Google 的 AutoML 技术(如 Vertex AI)与 TensorFlow 深度集成,让没有深厚机器学习背景的用户也能构建高质量的模型。

- TensorFlow 2.x 的核心是 Eager Execution + Keras,这使得它变得极其易用和直观。

tf.data是处理大数据的利器,@tf.function是连接易用性和高性能的桥梁。- TensorFlow 提供了一个从研究、开发到部署的完整、强大且灵活的生态系统。

- 无论是初学者还是资深工程师,都能在 TensorFlow 中找到适合自己的工具和方式。

希望这次分享能帮助大家更好地理解和使用 TensorFlow,谢谢大家!

Q&A 环节

Q1: TensorFlow 和 PyTorch 我该选哪个? A1: 这是一个经典问题。

- 如果你是初学者,或者更注重快速原型开发和直观的调试体验,PyTorch 可能感觉更“Pythonic”。

- 如果你需要部署到生产环境、移动端或浏览器,或者需要利用 Google 的 TPU,或者看重其完整的 MLOps 生态,TensorFlow 是更成熟、更全面的选择。

- 两者的差距正在缩小,很多核心思想(如计算图、自动微分)是共通的,了解两者会让你对深度学习框架有更深的理解。

Q2: @tf.function 的使用有什么注意事项?

A2: 是的,有一些陷阱需要注意:

- Python 控制流:

@tf.function对 Python 的原生if/else、for循环支持有限,它会在第一次运行时将控制流图固化下来,如果循环次数或if的条件在每次运行时都变化,可能会导致错误,对于动态控制流,建议使用tf.cond和tf.while_loop。 - 副作用:在

@tf.function内部使用像print这样的 Python 函数,它只会在“图构建”时执行一次,而不是每次调用时都执行,如果需要在每次调用时打印,可以将print放在函数外面,或者使用tf.print。

Q3: 如何有效利用 TensorBoard? A3:

- 记录标量:使用

tf.summary.scalar记录损失、准确率等。 - 记录模型图:使用

tf.summary.trace_on和tf.summary.trace_export来记录和可视化计算图的执行过程,这对于性能分析非常有用。 - 记录直方图:使用

tf.summary.histogram可视化权重、激活值的分布,有助于理解模型内部状态。 - 嵌入向量:对于 NLP 或推荐系统,可以使用

tf.summary.embedding可视化高维嵌入向量。 - 养成习惯:在项目开始时就规划好 TensorBoard 的记录点,这会让后续的调试和分析事半功倍。