Flickr作为全球知名的图片分享和托管平台,其技术架构历经二十余年的演进,已形成一套兼顾高可用、高扩展性与成本效益的复杂系统,早期Flickr诞生于Web 2.0浪潮初期,采用典型的LAMP(Linux、Apache、MySQL、PHP)架构,但随着用户量和数据量呈指数级增长,架构逐步向分布式、微服务化方向迭代,当前Flickr的技术架构可划分为存储层、计算层、应用层、缓存层、CDN层及运维监控层六大核心模块,各层通过标准化接口协同工作,支撑日均数亿次的图片访问请求。

存储层:多模态分布式存储体系

存储层是Flickr架构的基石,需应对图片、元数据、用户行为等多类型数据的存储需求,其设计遵循“冷热数据分离、读写负载分流”原则,采用多种存储介质和技术组合。

图片对象存储:Flickr将原始图片、缩略图、视频等二进制数据存储自研的分布式对象存储系统(代称“ObjectStore”),该系统基于HDFS(Hadoop Distributed File System)改造,通过分片(Sharding)技术将文件拆分为固定大小的块(默认128MB),分布到数百台存储节点,每个数据块保存3副本,确保节点故障时数据不丢失,元数据(如文件名、路径、创建时间)则通过独立的元数据节点(NameNode)管理,采用ZooKeeper实现高可用,避免单点故障。

关系型数据库:用户信息、图片标签、权限控制等结构化数据采用MySQL集群,通过主从复制(Master-Slave Replication)实现读写分离,主库处理写请求,从库承担读负载,分库分表策略按用户ID哈希拆分,单表数据量控制在千万级以内,保障查询性能。

NoSQL数据库:对于图片点赞、收藏等高并发读写场景,Flickr使用Cassandra存储时序数据,Cassandra的分布式架构和线性扩展能力,使其能够轻松应对每秒数十万次的读写请求,同时通过多数据中心复制(Multi-DC Replication)实现跨地域容灾。

归档存储:为降低存储成本,Flickr将超过1年的冷图片迁移至AWS Glacier或自研的低成本归档系统,归档数据采用压缩+去重技术,存储成本仅为热数据的1/10,访问时通过异步拉取机制,延迟控制在秒级。

计算层:弹性调度与任务编排

计算层负责处理图片处理、数据分析、后台任务等计算密集型工作,核心目标是资源利用最大化和任务处理低延迟。

图片处理服务:用户上传图片后,Flickr需自动生成多种规格(如缩略图、中等尺寸、高清图)并添加水印,这一过程由分布式的图片处理集群(代称“ImagePipeline”)完成,集群基于Kubernetes容器化部署,每个节点安装ImageMagick和自研的图像处理库,支持动态扩缩容:当任务量激增时,Kubernetes自动拉起新容器;任务量下降时则释放资源,节省30%以上的计算成本。

批处理与数据分析:用户行为分析、热门图片推荐等离线任务采用Spark计算框架,Spark集群与HDFS深度集成,通过RDD(弹性分布式数据集)实现数据并行处理,每日处理PB级日志数据,生成用户画像和推荐模型,实时分析则通过Flink流处理引擎完成,如实时统计图片点赞数,延迟低于100毫秒。

任务调度系统:Flickr自研了任务调度平台(代称“TaskOrchestrator”),支持定时任务、依赖任务和故障重试,该平台通过DAG(有向无环图)管理任务依赖,图片上传→生成缩略图→更新索引”这一流程,可配置任务失败时的重试策略和告警机制,确保任务执行可靠性。

应用层:微服务化与API网关

应用层直接面向用户和开发者,采用微服务架构,将不同功能拆分为独立服务,通过RESTful API和消息队列通信。

核心服务拆分:Flickr的应用层包含用户服务、图片服务、社交服务、通知服务等十余个微服务,用户服务负责注册、登录、个人信息管理;图片服务处理图片上传、删除、元数据查询;社交服务管理关注、评论、收藏关系,每个服务独立部署,使用Go语言开发,以提升并发处理能力。

API网关:所有外部请求通过API网关(基于Kong自研)统一接入,实现身份认证、流量控制、限流熔断等功能,网关根据请求类型路由到对应服务,例如图片下载请求路由至图片服务,API请求路由至开发者服务平台,网关记录访问日志,供运维团队分析流量模式。

消息队列:服务间通信采用RabbitMQ和Kafka组合:RabbitMQ处理低延迟、高可靠的同步消息(如图片上传完成通知);Kafka处理高吞吐的异步消息(如用户行为日志流),消息保留时间30天,支持数据回溯。

缓存层:多级缓存加速访问

缓存层是Flickr应对高并发的关键,采用“本地缓存+分布式缓存+CDN”三级架构,将热点数据访问延迟降至毫秒级。

本地缓存:每个应用节点部署Caffeine本地缓存,存储用户会话、图片元数据等高频访问数据,缓存容量占节点内存的20%,TTL(生存时间)设置为5分钟,避免缓存雪崩。

分布式缓存:Redis集群作为分布式缓存,存储图片点赞数、热门标签等全局共享数据,Redis采用Cluster模式分片,支持每秒10万次读写,同时通过持久化(RDB+AOF)保障数据安全。

CDN缓存:图片、视频等静态资源通过CloudFront CDN分发,全球部署超过500个边缘节点,用户请求优先访问最近的边缘节点,命中率保持在90%以上,源站负载降低70%,CDN支持缓存预热,在热门事件(如体育赛事)前主动推送资源至边缘节点。

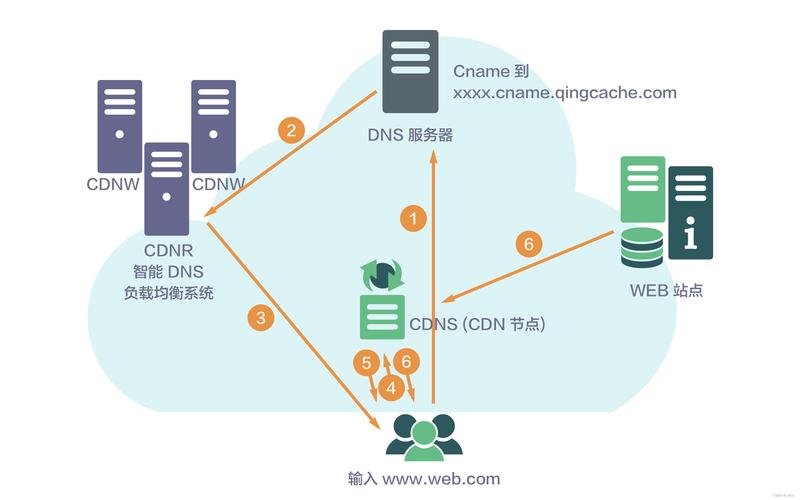

CDN与网络层:全球加速与流量调度

Flickr的用户遍布全球,CDN与网络层的设计直接影响用户体验。

智能DNS调度:通过GeoDNS技术,根据用户IP地址解析最近的CDN节点,同时结合网络延迟、节点负载等因素动态调整解析结果,例如亚洲用户优先访问新加坡节点,欧洲用户访问法兰克福节点。

传输优化:图片传输采用HTTP/2协议,支持多路复用和服务器推送,减少连接建立时间,对于大图片,启用分块传输(Chunked Transfer Encoding),用户可边下边看,视频传输则基于HLS协议,自适应码率(ABR)根据用户网络状况切换清晰度。

运维监控层:自动化与可观测性

Flickr的运维监控体系保障系统稳定运行,涵盖基础设施监控、应用性能追踪和自动化运维。

监控工具链:基础设施监控使用Prometheus+Grafana,采集服务器CPU、内存、磁盘I/O等指标,设置告警规则(如CPU使用率超过80%触发告警),应用性能监控采用OpenTelemetry,追踪请求链路,定位慢查询(如数据库查询超过1秒),日志收集通过ELK(Elasticsearch、Logstash、Kibana)集群,支持全文检索和日志分析。

自动化运维:CI/CD基于Jenkins和GitLab CI实现,代码提交后自动触发构建、测试和部署,部署过程采用蓝绿部署(Blue-Green Deployment),确保服务平滑升级,故障处理通过自研的应急响应平台(代称“OnCall”),自动触发告警通知、故障定位和恢复流程,平均故障恢复时间(MTTR)控制在15分钟以内。

相关问答FAQs

Q1:Flickr如何保证海量图片存储的可靠性和数据一致性?

A:Flickr通过多重机制保障数据可靠性:图片对象存储采用3副本策略,分布在不同机架,避免单机柜故障导致数据丢失;元数据节点使用ZooKeeper实现高可用,主节点故障时自动切换;数据库层通过主从复制+半同步复制(Semi-Synchronous Replication),确保写操作至少同步到1个从库后才返回成功,数据一致性方面,采用最终一致性模型,例如图片上传后先写入主库,异步同步到从库和缓存,短暂延迟(毫秒级)不影响用户体验。

Q2:Flickr的图片处理集群如何应对突发流量(如节日大量用户上传图片)?

A:图片处理集群基于Kubernetes实现弹性伸缩:集群配置HPA(Horizontal Pod Autoscaler),根据CPU使用率和任务队列长度自动调整Pod数量;同时设置扩缩容冷却时间(如扩容后5分钟内不再扩容),避免频繁波动,对于突发流量,还启用“请求优先级”机制,普通用户上传图片优先级较低,付费用户或热门活动图片优先级高,优先处理,通过消息队列缓冲请求,避免系统过载,确保集群稳定运行。