最常用且有效的方法(推荐首选)

这是最常见、最安全且通常能解决问题的方法,它会先关闭 Wi-Fi,然后重新打开。

- 点击屏幕右上角的 Wi-Fi 图标(一个像扇形的信号图标)。

- 在弹出的菜单中,点击 “关闭 Wi-Fi”。

- 等待几秒钟。

- 再次点击 Wi-Fi 图标,然后点击 “打开 Wi-Fi”。

- 系统会自动扫描并重新连接到您之前保存的网络,如果需要,请选择您的 Wi-Fi 网络并输入密码。

这个方法等同于重启了 Wi-Fi 适配器,解决了大部分临时性的网络连接问题。

重置网络堆栈(命令行方法)

如果方法一无效,或者您在使用有线网络(以太网)时遇到问题,可以使用这个更强大的方法,它会清除系统中的网络缓存、DNS 配置等,并重建网络连接。

操作步骤:

-

打开“终端”(Terminal):

(图片来源网络,侵删)

(图片来源网络,侵删)- 点击屏幕左上角的 苹果 图标。

- 选择 “系统设置...”(或旧系统的“系统偏好设置...”)。

- 在侧边栏最下方找到并点击 “终端”。

-

输入并执行以下命令: 复制以下所有命令,一个一个地粘贴到终端窗口中,每粘贴完一个就按一下 回车键 执行。

# 1. 重置网络配置(macOS Monterey 及更新版本) sudo dscacheutil -flushcache; sudo killall -HUP mDNSResponder # 2. 如果上面的命令无效,可以尝试这个(适用于较旧或新版系统) sudo ifconfig en0 down sudo ifconfig en0 up

- 注意:

en0通常是你的 Wi-Fi 接口名称,如果你的网络问题出在以太网上,可能需要将en0改为en1(或有线网接口),不确定的话,可以先用ifconfig命令查看接口列表,但通常en0Wi-Fi。

- 注意:

-

重启你的 MacBook Pro: 执行完命令后,最稳妥的方式是重启电脑,让所有网络设置完全生效。

- 点击屏幕左上角的 苹果 图标。

- 选择 “重新启动...”。

重置网络设置(彻底恢复出厂设置)

这是最彻底的方法,会将你所有的网络配置恢复到“出厂默认”状态。这意味着你之前保存的所有 Wi-Fi 密码、VPN 配置、网络偏好设置等都会被删除,需要重新设置。

操作步骤:

-

打开“系统设置...”(或旧系统的“系统偏好设置...”)。

-

在侧边栏中,点击 “网络”。

-

在网络设置窗口的左下角,点击 (或旧系统的“高级...”)按钮。

-

在弹出的“网络”高级设置窗口中,切换到 “TCP/IP” 选项卡。

-

在右下角,你会看到一个 “ Renew DHCP Lease”(更新 DHCP 租约)的按钮,可以先尝试点击一下,这有时能解决问题。

-

如果无效,切换到 “代理” 选项卡,确保所有代理设置都是 “不使用代理” 或未勾选任何选项。

-

关闭这个高级窗口,回到主网络设置界面。

-

点击左下角的 (或“齿轮”图标),然后选择 “设定服务顺序...”(或“服务顺序...”)。

-

在弹出的窗口中,你可以调整网络服务的优先级(让 Wi-Fi 优先于以太网),调整后,点击 “好”。

-

最后一步:重置 在主网络设置窗口的左下角,点击 (或“高级...”),然后选择 “重置...”。

- 在弹出的菜单中,选择 “重置网络设置...”。

- 系统会提示你输入 管理员密码,输入后确认。

- 重要提示:这个操作会删除所有 Wi-Fi 密码和 VPN 配置。

-

重新配置网络: 重置完成后,你的 MacBook Pro 会断开所有网络连接,你需要手动:

- 重新打开 Wi-Fi。

- 选择你的 Wi-Fi 网络,并重新输入密码。

- 如果使用 VPN,需要重新配置并登录。

硬件重启(最后的手段)

如果软件层面的重置都无效,可能是网络硬件模块或系统软件本身出现了严重问题,可以尝试 SMC 重置。

SMC (System Management Controller) 是管理硬件功能的控制器,重置它可以解决一些硬件相关的电源和网络问题。

如何操作取决于你的 MacBook Pro 型号:

-

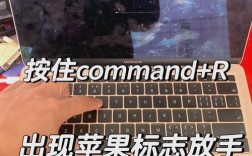

带 Apple Silicon (M1, M2, M3 等) 的 MacBook Pro:

- 将 Mac 完全关机。

- 按住 电源按钮。

- 在屏幕上看到“正在载入启动选项”或 Apple 标志时,立即按住 电源按钮,直到看到“正在载入启动选项”再次出现。

- 松开电源按钮,SMC 重置已完成。

-

带 Intel 处理器的 MacBook Pro (T2 芯片):

- 将 Mac 完全关机。

- 按住 左侧的 Shift 键、左侧的 Control 键 (Ctrl) 和电源键。

- 按住这三个键大约 7 秒钟。

- 在按住这些键的同时,将电源线拔掉(如果是笔记本)。

- 继续按住这三个键再 7 秒钟。

- 松开所有键,然后重新插上电源线。

- 按电源键启动 Mac。

-

带 Intel 处理器的旧款 MacBook Pro (无 T2 芯片):

- 将 Mac 完全关机。

- 同时按住 左侧的 Shift 键、左侧的 Control 键 (Ctrl)、左侧的 Option (Alt) 键和电源键。

- 按住这四个键大约 10 秒钟。

- 松开所有键,然后按电源键启动 Mac。

总结与建议

| 方法 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| 开关 Wi-Fi | 最简单、最快速、最安全 | 无法解决深层次问题 | 日常网络卡顿、掉线等小问题 |

| 重置网络堆栈 | 功能强大,不影响已保存的密码 | 需要终端操作,可能需要重启 | DNS污染、IP地址冲突等复杂问题 |

| 重置网络设置 | 最彻底,能解决几乎所有软件问题 | 会删除所有Wi-Fi密码和VPN | 所有软件方法都失败后的终极手段 |

| 重置SMC | 解决硬件或固层面问题 | 操作相对复杂,非必要不使用 | 怀疑是硬件故障或电源管理问题 |

建议排查顺序:

- 先试方法一:开关 Wi-Fi,90% 的日常问题都能解决。

- 如果无效,尝试方法二:重置网络堆栈。

- 如果还是不行,尝试方法三:重置网络设置(做好重新配置的准备)。

- 如果以上全部失败,并且怀疑是硬件问题(如 Wi-Fi 开关灰色无法点击等),再考虑方法四:重置 SMC。

如果所有方法都试过了问题依旧,那可能是硬件故障,建议联系 Apple 官方支持或前往 Apple Store 进行检测。