12306作为中国铁路客运的核心售票系统,其每一次技术升级都承载着亿万旅客的出行期待,近年来,12306系统经历了多次大规模改造,从最初的单机架构到如今的高可用分布式系统,背后凝聚着无数技术人员的智慧与汗水,本文将从架构演进、核心技术创新、性能优化及安全防护等多个维度,深度揭秘12306改造的技术细节。

架构演进:从“崩溃边缘”到“稳如泰山”

早期的12306系统采用单体架构,所有业务逻辑集中部署在少数几台服务器上,每逢春运等高峰期,系统访问量呈指数级增长,服务器负载骤增,崩溃成为常态,2012年,12306启动第一次大规模架构改造,引入分布式架构,将购票、查询、支付等核心模块拆分为独立服务,通过负载均衡技术将请求分散到多台服务器,这种架构仍存在数据库瓶颈,所有订单数据集中存储在单一数据库集群中,读写压力巨大。

2025年后,12306启动新一轮架构升级,全面转向微服务架构,系统被拆分为上百个微服务,每个服务独立部署和扩展,例如订单服务、用户服务、车票服务等均采用不同的技术栈,引入了服务网格技术(如Service Mesh),实现服务间通信的自动化管理,大幅提升系统的弹性和可观测性,在数据存储层面,采用“分库分表+读写分离”策略,将订单数据按用户ID或时间范围进行分片,分散到多个数据库节点,并配置多个从库处理查询请求,有效缓解了数据库压力。

核心技术创新:突破高并发与数据一致性难题

高并发处理是12306改造的核心挑战,为应对每秒数十万次的请求峰值,系统引入了多级缓存架构,在客户端,通过静态资源缓存和CDN加速页面加载;在服务端,采用Redis集群缓存热点数据,如车次余票、用户信息等,缓存命中率超过90%,大幅降低数据库访问压力,还引入了本地缓存(如Caffeine)和分布式缓存相结合的二级缓存策略,进一步减少网络开销。

数据一致性是另一个关键技术点,在分布式环境下,多个服务节点间的数据同步极易出现延迟或冲突,12306采用了最终一致性模型,通过消息队列(如RocketMQ)实现异步数据同步,当用户下单后,订单服务会发送消息到队列,支付服务、库存服务等消费者异步处理业务逻辑,避免同步调用导致的性能瓶颈,引入分布式事务解决方案(如TCC模式),确保跨服务操作的数据一致性,扣减库存-创建订单-支付”这一流程中,即使某个环节失败,系统也能通过事务回滚保证数据完整性。

性能优化:从“秒杀”到“流畅”的蜕变

早期的12306在春运期间常出现“购票等待”甚至“页面无响应”等问题,这源于系统对请求的串行处理能力不足,改造后的系统引入了异步化与流式处理技术,将非核心业务(如日志记录、短信通知)改为异步执行,核心业务(如查询余票、下单)采用流式计算框架(如Flink)实现毫秒级响应,余票查询服务通过预计算和增量更新,将响应时间从秒级优化到毫秒级。

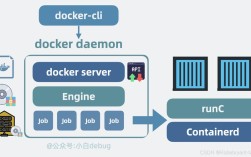

在资源调度方面,12306引入了容器化技术(如Docker和Kubernetes),实现服务的弹性伸缩,根据实时流量动态调整服务实例数量,例如在凌晨低峰期缩减实例数量节省资源,在购票高峰期自动扩容至数百个实例,还采用了自研的智能调度算法,根据服务器负载、网络延迟等指标,将请求路由到最优节点,进一步提升系统吞吐量。

安全防护:构建全方位“护城河”

随着网络攻击手段的升级,12306的安全防护体系也经历了全面升级,在用户认证层面,引入多因素认证(MFA),用户登录时需同时验证密码和短信验证码,防止账号被盗,在接口安全方面,采用OAuth 2.0协议进行权限控制,并对敏感数据(如身份证号)进行脱敏存储和传输加密。

针对黄牛党利用爬虫恶意抢票的问题,12306部署了智能风控系统,通过机器学习算法分析用户行为特征(如点击频率、下单间隔),识别异常请求并自动拦截,同一IP地址在短时间内频繁请求或大量下单,系统会触发验证码或临时封禁策略,还引入了分布式防火墙和DDoS防护系统,抵御恶意流量攻击,保障系统稳定运行。

相关问答FAQs

Q1:12306系统如何应对春运期间的超高并发?

A1:12306通过多级架构优化应对超高并发:采用分布式微服务架构将请求分散到多台服务器;通过多级缓存(Redis集群+本地缓存)减少数据库压力;利用容器化技术实现弹性伸缩,根据流量动态扩容服务实例;通过异步化处理和流式计算提升核心业务响应速度,确保系统在每秒数十万次请求下仍能稳定运行。

Q2:为什么12306有时会出现“无票”但系统仍有余票的情况?

A2:这种情况通常与12306的余票计算逻辑有关,系统采用“动态分配+预占机制”,余票并非实时固定分配,而是根据候补订单、中转联程等需求动态调整,部分车票可能被预留给中转旅客或铁路内部调度,当这些需求释放后,余票才会重新开放,缓存同步延迟也可能导致短暂的数据不一致,但系统会在短时间内自动修正。