Hadoop技术的发展经历了从概念提出到生态体系完善的漫长过程,其核心思想在于通过分布式计算和存储解决大数据处理难题,2006年,Doug Cutting和Mike Cafarella基于Google发表的GFS和MapReduce论文,开始开发Hadoop项目,最初作为Nutch搜索引擎的一部分,2008年,Hadoop成为Apache顶级项目,标志着其正式进入开源社区视野,早期Hadoop主要由HDFS(分布式文件系统)和MapReduce(计算框架)两大核心组件构成,HDFS通过数据分块和副本机制实现高容错性,MapReduce则将计算任务拆分为Map和Reduce两个阶段,适合批处理场景,这一阶段的Hadoop在互联网公司得到初步应用,如Yahoo建设了全球最大的Hadoop集群,验证了其处理海量数据的能力。

随着数据规模的爆炸式增长,Hadoop的局限性逐渐显现,MapReduce的磁盘计算模式导致延迟较高,难以满足实时性需求,2010年左右,Hadoop生态开始扩展,引入了NoSQL数据库HBase,支持实时随机读写;分布式协调服务ZooKeeper解决了集群节点间的一致性问题;数据仓库工具Hive通过SQL接口降低了数据查询门槛,这一阶段的特点是组件多样化,但各组件间协同效率较低,数据流转仍以批处理为主,2012年,Facebook开源了Orc列式存储格式,提升了Hive查询性能;Cloudera推出CDH(Cloudera Distribution Hadoop),通过标准化发行版简化了部署,推动了Hadoop在企业中的普及。

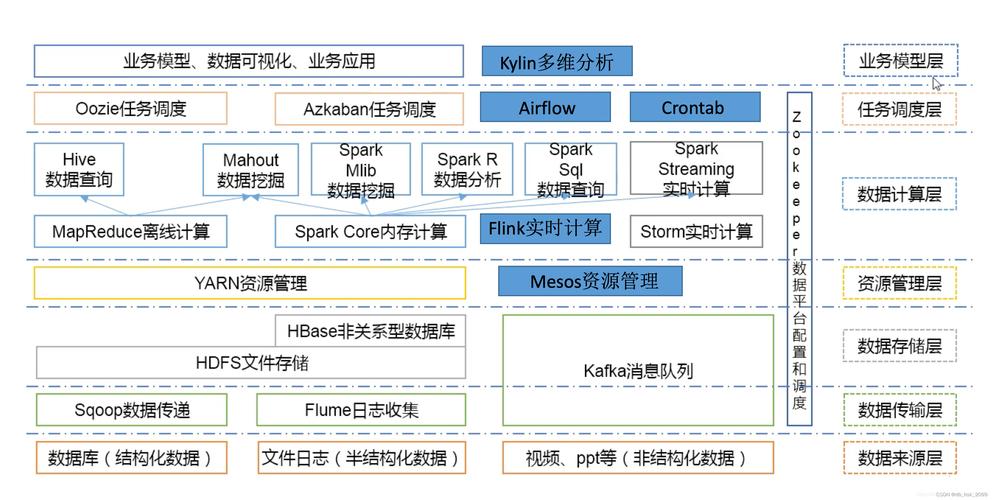

2025年,Hadoop迎来重要转折点,MapReduce逐渐被YARN(资源管理器)和Spark等内存计算框架取代,YARN作为资源调度层,支持多种计算框架并行运行,解决了MapReduce资源利用率低的问题,Spark凭借内存计算和DAG(有向无环图)执行引擎,将处理速度提升10倍以上,成为新一代计算引擎的代表,HDFS的优化也在进行,如支持纠删码减少存储开销,异构存储架构优化冷热数据管理,这一阶段Hadoop从单一批处理平台演变为支持批处理、流处理、交互式查询的综合平台,生态组件超过20个,涵盖数据采集(Flume、Sqoop)、数据处理(Spark、Flink)、数据存储(HDFS、HBase)、数据治理(Atlas、Ambari)等全链路。

近年来,Hadoop技术进一步云原生化和智能化,云厂商推出托管Hadoop服务,如AWS EMR、Azure HDInsight,实现弹性扩展和按需付费,容器化技术(Kubernetes)与Hadoop的结合,提升了资源调度灵活性,在AI时代,Hadoop生态与机器学习平台(如TensorFlow、PyTorch)集成,支持大规模数据预处理和模型训练,Hadoop在安全方面加强,集成Kerberos认证、Ranger权限管理,满足企业合规需求,截至2025年,Hadoop生态已形成以HDFS、YARN、Spark为核心,辅以Flink、Kafka、Hive等组件的完整技术栈,全球超过80%的财富500强企业采用Hadoop技术处理数据,其在大数据基础设施中的地位依然不可替代。

FAQs

-

问:Hadoop与Spark的关系是什么?

答:Hadoop和Spark并非替代关系,而是互补关系,Hadoop的HDFS提供分布式存储,YARN负责资源调度,而Spark作为计算引擎运行在YARN之上,利用内存计算加速数据处理,Hadoop生态中的Hive、HBase等组件可与Spark集成,形成“存储+调度+计算”的完整解决方案。 -

问:Hadoop在大数据时代是否过时?

答:Hadoop并未过时,而是不断演进适应新需求,虽然Spark等框架在计算性能上更优,但HDFS仍是主流分布式存储系统,YARN仍是主流资源调度器,Hadoop生态通过云原生、AI集成等创新,持续在数据湖、实时分析等领域发挥核心作用,未来将与云平台、边缘计算进一步融合。