OLE (Object Linking and Embedding,对象链接与嵌入) 是微软在早期 Windows 操作系统中推出的一项核心技术,它的目标是解决不同应用程序之间数据共享和协同工作的难题。

您可以把它想象成一个“超级剪贴板”或“乐高积木系统”。

OLE 的核心思想:解决什么问题?

在 OLE 出现之前,如果你想在 Word 文档里放一张你用画图软件画的图,通常的做法是:

- 打开画图软件,画好图。

- 把图“复制”下来。

- 切换到 Word,再“粘贴”进去。

这样做有一个很大的问题:图片和原始的画图软件是脱节的,如果你之后想修改这张图,你只能回到画图软件重新画一张,或者双击 Word 里的图片,可能会弹出一个简陋的编辑器,功能有限。

OLE 就是为了解决这个问题而生的,它允许你创建一个“对象”(Object),这个对象可以来自任何支持 OLE 的应用程序,这个对象不仅仅是数据的副本,它还包含了创建它的应用程序的“智能”。

OLE 的两大核心机制:链接与嵌入

OLE 主要通过两种方式来实现对象共享:链接和嵌入。

a) 对象嵌入

这就像把一张照片打印出来,再剪下来贴到你的笔记本上。

- 工作原理:数据(如图像、表格、文本)从源应用程序(如画图软件)复制,然后作为一个“对象”直接插入到目标应用程序(如 Word)中,这个对象包含了数据的全部内容以及创建它的应用程序的信息。

- 优点:

- 自包含:所有的数据都保存在 Word 文档这一个文件里,发送给别人时不需要附带额外的源文件。

- 独立性强:即使源应用程序(画图软件)被删除或移动了,Word 文档里的对象依然存在。

- 缺点:

- 文件体积大:因为把完整的数据都复制进来了,所以文档会变得很大。

- 更新困难:如果源数据被修改了,Word 文档里的嵌入对象不会自动更新,你需要手动重新嵌入。

- 生活中的例子:你在 Word 里点击

插入 -> 对象 -> Microsoft Excel 工作表,创建一个新的表格,这个表格就是嵌入的,它和 Excel 的原始文件无关。

b) 对象链接

这就像在你的笔记本里写下一张照片的存放地址和说明,而不是把照片本身贴上去。

- 工作原理:目标应用程序(如 Word)中只保存了指向源数据文件(如画图软件生成的

.bmp文件)的一个“链接”(Link),当你双击这个对象时,Windows 会启动源应用程序来打开原始文件进行编辑。 - 优点:

- 文件体积小:Word 文档里只存了一个链接地址,不存实际数据,所以文档很小。

- 数据同步:源数据被修改后,你可以在 Word 中选择“更新链接”,文档中的对象内容就会自动变成最新的版本。

- 缺点:

- 依赖外部文件:你必须始终保留原始的数据文件,并且不能移动或删除它,如果链接断了,Word 就找不到原始图片了。

- 便携性差:发送 Word 文档给别人时,必须连同原始数据文件一起发送,否则对方就看不到图片了。

- 生活中的例子:你在 Word 里点击

插入 -> 图片 -> 来自文件,选择一张图片并插入,默认情况下,这通常就是链接的(Word 2010 及以后版本默认改为嵌入,但你可以手动设置为链接)。

OLE 的关键技术和特性

为了让“对象”能够被“激活”和编辑,OLE 引入了一系列复杂的技术:

- OLE 服务器:提供对象的应用程序,Excel 是一个 OLE 服务器,因为它可以提供工作表对象。

- OLE 客户端:接收并嵌入/链接对象的应用程序,Word 是一个 OLE 客户端,因为它可以接收 Excel 的工作表对象。

- 就地激活:这是 OLE 的一个革命性特性,你可以在 Word 文档中直接双击 Excel 对象,Word 的菜单栏和工具栏会瞬间变成 Excel 的,你就像在 Word 界面里直接操作 Excel 一样,编辑完再点击文档其他地方,又会切回 Word 的界面,这极大地提升了用户体验。

- 拖放操作:你可以直接从文件管理器里拖一个 Excel 文件到 Word 文档里,或者从一个程序窗口拖一个对象到另一个程序窗口,这背后也是 OLE 在支持。

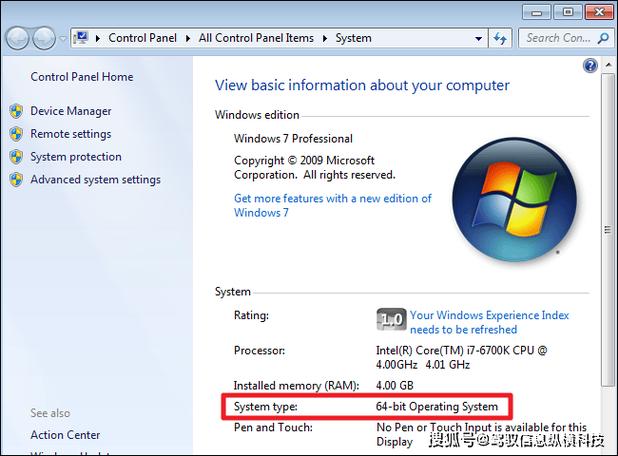

OLE 的演变与现状

随着技术的发展,OLE 也经历了几个重要的版本:

- OLE 1.0 (1990):最初的版本,主要实现了基本的嵌入和链接功能。

- OLE 2.0 (1993):这是一个巨大的飞跃,它引入了组件对象模型,这是一个更底层、更强大的规范,COM 定义了软件组件之间如何通信和交互的标准。OLE 2.0 是构建在 COM 之上的,我们今天熟知的“插入对象”、“右键菜单”、“拖放”等功能,主要归功于 OLE 2.0。

- ActiveX (1996):随着互联网的兴起,微软将 OLE 技术进行了改造,使其更轻量、更安全,可以用于网页中,这就是 ActiveX,ActiveX 控件可以像小程序一样在网页上运行(比如早期的网银控件、视频播放器),但由于其安全模型和跨平台性问题,现在已经基本被淘汰。

- OLE Automation:这是 COM 的一个子集,它允许一个应用程序(客户端)通过编程方式去控制另一个应用程序(服务器)的对象,你可以用 Python 或 VBA 脚本来自动操作 Excel,读取数据、生成图表,这就是 OLE Automation 在起作用。

| 特性 | 描述 |

|---|---|

| 全称 | Object Linking and Embedding (对象链接与嵌入) |

| 核心目标 | 实现不同 Windows 应用程序之间的无缝数据共享和协同工作。 |

| 两大机制 | 嵌入:数据副本,存入目标文件,自包含但文件大。 链接:数据指针,指向源文件,文件小但依赖外部文件。 |

| 关键技术 | COM (Component Object Model) 是其底层架构,提供了组件间通信的标准。 |

| 用户体验 | 就地激活是其标志性功能,允许用户在客户端程序中直接编辑服务器程序的对象。 |

| 现状 | OLE 这个术语本身已逐渐淡出历史舞台,但其核心技术——COM,至今仍然是 Windows 平台的基石,许多现代 Windows 技术,如 .NET、DirectX、Windows 运行时,都构建在 COM 之上或与之深度集成,你今天在 Windows 上享受的很多功能,其根源都可以追溯到 OLE/COM。 |

一句话概括:OLE 是微软早期为实现软件间“互联互通”而打造的一套技术体系,它奠定了现代 Windows 组件化编程的基础,虽然名字不再常用,但其灵魂(COM)至今仍在 Windows 体内跳动。