下面我将从几个层面详细阐述这种态度的具体体现、原因以及未来的趋势。

总体态度:国家战略性新兴产业

政府将无人机产业定位为战略性新兴产业和“新质生产力”的重要组成部分,这一定位决定了政府会从国家战略高度来推动其发展,主要基于以下几点考量:

- 经济新引擎:无人机产业产业链长,涉及材料、电池、电机、飞控、通信、传感器、人工智能、大数据、应用服务等众多领域,能带动上下游产业发展,创造大量就业岗位,成为新的经济增长点。

- 技术制高点:无人机是人工智能、物联网、5G等前沿技术的集成应用平台,发展无人机产业有助于提升国家在高端制造和核心技术领域的竞争力。

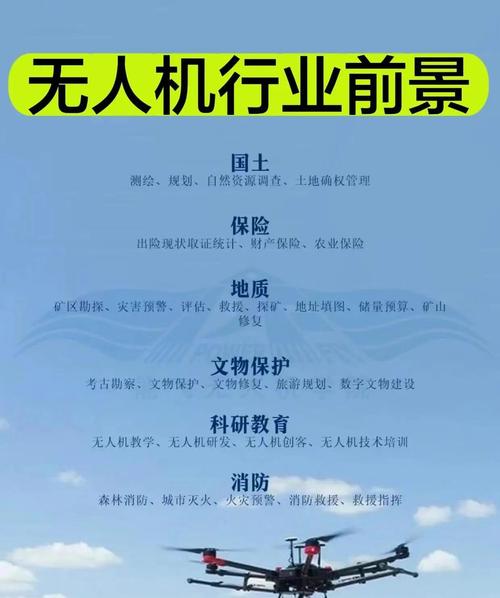

- 赋能百业,提升效率:无人机在农业、物流、测绘、安防、能源、环保等领域的应用,能够显著提升传统行业的作业效率、降低成本、保障安全,是数字化转型的关键工具。

- 国防与公共安全:军用无人机是现代战争的重要力量,而警用、消防、应急救援等公共安全领域的无人机,则是提升社会治理能力、保障人民生命财产安全的有效手段。

“扶持发展”的具体体现

政府通过多种政策工具,全方位支持无人机产业的发展:

-

顶层设计与战略规划:

- 国家层面出台《“十四五”国家战略性新兴产业发展规划》等文件,明确将无人机列为重点发展产业。

- 各地政府(如深圳、广州、杭州等)也纷纷出台地方性产业规划,设立无人机产业园区,形成产业集群效应。

-

资金与财税支持:

(图片来源网络,侵删)

(图片来源网络,侵删)- 设立专项产业基金,为无人机研发、制造和应用提供资金支持。

- 对高新技术企业、研发投入给予税收优惠和补贴,鼓励企业进行技术创新。

- 通过政府购买服务的方式,引导和扩大无人机在公共服务领域的应用。

-

建设基础设施与空域试点:

- 低空经济基础设施:大力建设eVTOL(电动垂直起降飞行器)起降场、无人机物流配送枢纽、无人机测试场等基础设施,为规模化运营铺平道路。

- 空域管理改革:这是扶持发展的核心,在特定区域(如深圳、杭州、合肥等)设立“无人机试验区”或“城市场景综合应用示范区”,探索“放管服”(简政放权、放管结合、优化服务)的空域管理模式,通过“审批改备案”、“线上申请、即时响应”等方式,简化企业运营流程,为无人机商业化运营打开便利之门。

-

鼓励应用场景拓展:

- 积极推动无人机在物流配送(美团、顺丰等)、农业植保(大疆等)、电网巡检、应急救援、城市管理等场景的示范应用。

- 举办各类无人机赛事、展会和产业论坛,促进技术交流和国际合作。

“规范管理”的具体体现

随着无人机产业的飞速发展,其带来的安全风险(如“黑飞”扰航、隐私泄露、数据安全等)也日益凸显,政府的监管态度也在不断加强和细化:

-

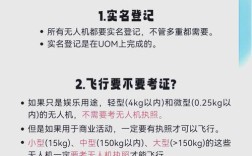

实名登记制度:要求所有民用无人机(特别是消费级)进行实名登记,从源头上掌握无人机所有者信息,为后续追责和管理提供依据。

(图片来源网络,侵删)

(图片来源网络,侵删) -

适航审定与生产许可:对无人机(尤其是载人无人机和大型工业无人机)实施严格的适航审定和生产制造许可,确保产品的安全性和可靠性。

-

飞行许可与空域管制:

- “电子围栏”技术:强制要求无人机内置地理围栏技术,在禁飞区、限飞区自动限制或禁止飞行。

- 飞行审批系统:对于在管制空域内的飞行,必须通过官方APP(如UOM,U-Cloud等)进行预先申报和审批,实现“一机一码、一飞一报”。

-

数据安全与隐私保护:

出台《数据安全法》、《个人信息保护法》等法律法规,要求无人机运营者合法合规地收集、存储和使用飞行数据及图像信息,防止数据泄露和滥用,保护公民隐私。

-

人员资质管理:要求从事无人机商业飞行的操作人员必须考取相应的“无人机驾驶员执照”,确保其具备专业的飞行技能和安全意识。

未来趋势与展望

政府对无人机产业的态度将呈现出以下几个明显的趋势:

- 从“试点”走向“常态化”:目前许多便利化的空域管理政策还处于试点阶段,随着管理经验的积累和技术手段的成熟,这些“绿色通道”有望逐步推广,实现无人机飞行的常态化、便捷化管理。

- “低空经济”成为国家战略:无人机是“低空经济”的核心载体,政府将把发展低空经济作为推动经济增长和城市现代化的重要抓手,系统性地规划空域、基础设施和产业生态。

- 监管技术化、智能化:未来的监管将更加依赖技术手段,通过5G/6G、北斗、ADS-B(广播式自动相关监视)、低空监视雷达等技术,构建一个“天-空-地”一体化的低空智慧监管网络,实现对无人机飞行的实时、精准、动态管理。

- 安全与发展并重:在大力鼓励技术创新和应用拓展的同时,对数据安全、飞行安全、公共安全的监管只会越来越严,合规将成为企业生存和发展的基本前提。

政府对无人机产业的态度是“又爱又管”。“爱”在于其巨大的经济价值、战略意义和社会效益,是倾力扶持的“宠儿”;“管”在于其潜在的风险和挑战,是必须严加看管的“孩子”。

对于企业而言,深刻理解并顺应这种“扶持与监管并重”的宏观环境至关重要,要抓住政策红利,积极创新,拓展应用场景;必须将合规和安全放在首位,建立健全内部管理制度,才能在未来的激烈竞争中行稳致远。