AlphaGo的技术原理是一个融合了深度学习、强化学习和蒙特卡洛树搜索(MCTS)的复杂系统,其核心在于通过深度神经网络模拟人类棋手的直觉与策略,并结合大规模自我对弈实现超越人类水平的棋力,具体而言,其技术架构主要由三个关键部分组成:策略网络(Policy Network)、价值网络(Value Network)和蒙特卡洛树搜索(MCTS),这三者协同工作,实现了对围棋这一复杂游戏的精准决策。

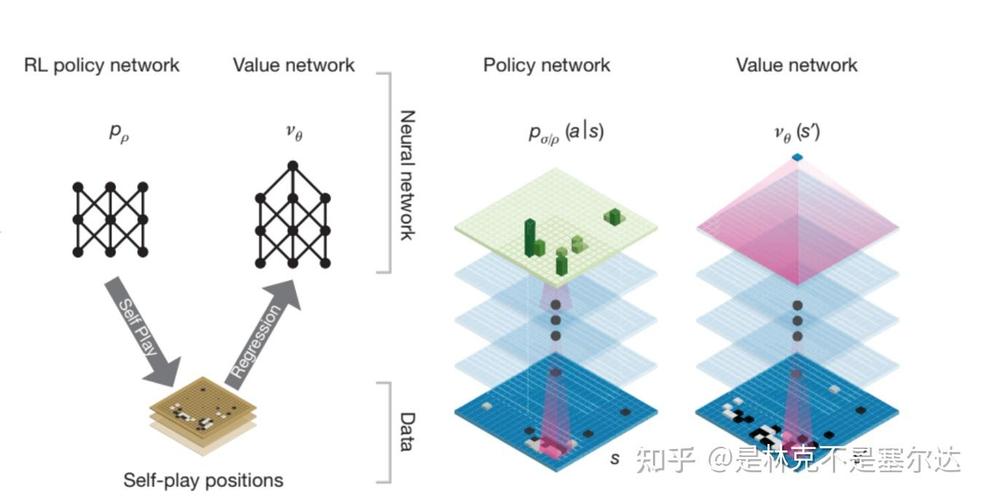

策略网络是AlphaGo的“直觉系统”,主要负责在给定棋局状态下,快速生成当前局面下最有可能是最优的几个落子位置,策略网络分为两个版本:监督学习策略网络(SL Policy Network)和 rollout策略网络,SL策略网络通过学习人类职业棋手的对局数据进行训练,其输入是当前棋盘的361个特征(包括每个位置的棋子状态、气的信息等),输出是361个可能落子位置的先验概率,这一步骤使得AlphaGo能够模仿人类棋手的下棋风格,快速缩小搜索空间,而rollout策略网络则是一个轻量级的策略网络,用于在MCTS的快速模拟阶段(rollout)中,根据当前局面快速估算剩余局面的胜率,其计算速度更快但精度较低,主要用于平衡搜索效率与准确性。

价值网络是AlphaGo的“评估系统”,其核心功能是对当前棋局状态进行整体评估,输出当前局面下最终获胜的概率,与策略网络不同,价值网络不关注具体的落子位置,而是直接判断当前棋局的优劣,价值网络的输入同样是棋盘的361个特征,输出一个0到1之间的数值,代表当前玩家在该局面下获胜的概率,价值网络通过自我对弈数据进行训练,其训练目标是使预测的胜率与实际对局结果之间的误差最小化,这一网络的出现,解决了传统围棋AI中依赖手工设计评估函数的局限性,使得AI能够从数据中自动学习到复杂的局面判断能力,例如棋形的厚薄、势力的消长等抽象概念。

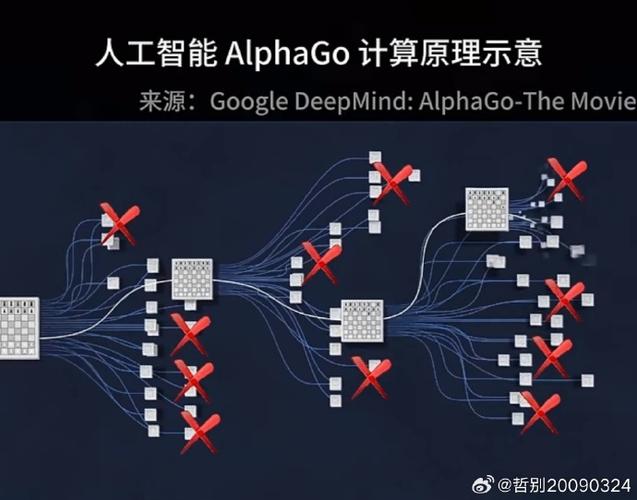

蒙特卡洛树搜索(MCTS)是AlphaGo的“决策框架”,它将策略网络和价值网络的输出有机结合起来,实现高效搜索,MCTS通过四个步骤循环迭代:选择(Selection)、扩展(Expansion)、模拟(Simulation)和反向传播(Backpropagation),在选择阶段,MCTS根据一个包含先验概率(来自策略网络)和胜率估值(来自价值网络)的公式,选择最有希望的节点进行扩展;在扩展阶段,当遇到未访问过的子节点时,使用策略网络生成先验概率并创建新节点;在模拟阶段,使用rollout策略网络快速模拟至终局,估算当前节点的胜率;最后通过反向传播将模拟结果更新到路径上的所有节点,更新节点的访问次数和胜率估值,与传统MCTS相比,AlphaGo的MCTS引入了神经网络指导,大幅减少了无效搜索,使得搜索效率提升数十倍,同时通过价值网络避免了完全依赖随机模拟的偏差。

AlphaGo的技术突破还体现在其训练数据的获取与处理上,在初始阶段,SL策略网络通过监督学习3千万步人类职业棋手的对局数据进行训练,使其具备接近人类的棋感,随后,通过自我对弈(Self-Play)生成新的训练数据,策略网络和价值网络在自我对弈中不断迭代优化,这一过程中,AlphaGo通过“课程学习”(Curriculum Learning)策略,从简单的对局开始,逐步提升难度,类似于人类棋手的成长过程,AlphaGo还引入了“强化学习”机制,通过让两个版本的策略网络相互对弈,并根据胜负结果调整网络参数,使得AI摆脱对人类数据的依赖,形成独特的“AlphaGo风格”的棋理。

为了进一步提升棋力,AlphaGo Zero和AlphaMaster版本对原始架构进行了优化,AlphaGo Zero放弃了人类对局数据,完全通过自我对弈进行训练,策略网络和价值网络合并为一个单一的“策略-价值网络”,输入仅为棋盘状态(不包含人工特征),输出同时给出落子概率和胜率估值,这种端到端的学习方式,使得AlphaGo Zero在短短几天内超越了所有 previous 版本,其学习效率远超依赖人类数据的版本,通过并行计算和更大的神经网络规模,AlphaGo能够探索更复杂的棋局变化,其决策精度和全局判断能力达到前所未有的水平。

AlphaGo的技术原理本质上是深度学习与强化学习在博弈领域的创新性应用,策略网络提供局部落子的直觉指导,价值网络进行全局局面的优劣评估,而蒙特卡洛树搜索则作为桥梁,将神经网络的概率输出转化为具体的决策路径,通过自我对弈和强化学习,AlphaGo不断优化网络参数,最终实现了超越人类顶尖棋手的棋力,这一技术不仅推动了围棋AI的发展,也为其他复杂决策问题(如蛋白质折叠、物流优化等)提供了新的解决思路。

相关问答FAQs:

-

问:AlphaGo的策略网络和价值网络有什么区别?

答:策略网络和价值网络是AlphaGo中的两个核心神经网络,功能不同,策略网络输入当前棋局状态,输出每个落子位置的先验概率,主要用于指导MCTS的搜索方向,快速筛选有潜力的落子点;而价值网络同样输入棋局状态,但输出的是当前局面下获胜的概率,用于评估全局局面的优劣,不涉及具体落子位置,策略网络关注“怎么下”,价值网络关注“局势好不好”。 (图片来源网络,侵删)

(图片来源网络,侵删) -

问:为什么AlphaGo Zero比早期版本更强大?

答:AlphaGo Zero的强大主要体现在三个方面:一是完全放弃人类对局数据,通过自我对弈从零开始学习,避免了人类棋手思维的局限性;二是将策略网络和价值网络合并为单一的“策略-价值网络”,实现了端到端的学习,提升了信息整合效率;三是采用更高效的训练算法和更大的计算规模,使得网络能够探索更复杂的棋局模式,从而在短时间内达到超越人类顶尖水平的棋力,这种“无监督学习”模式代表了AI发展的重要方向。