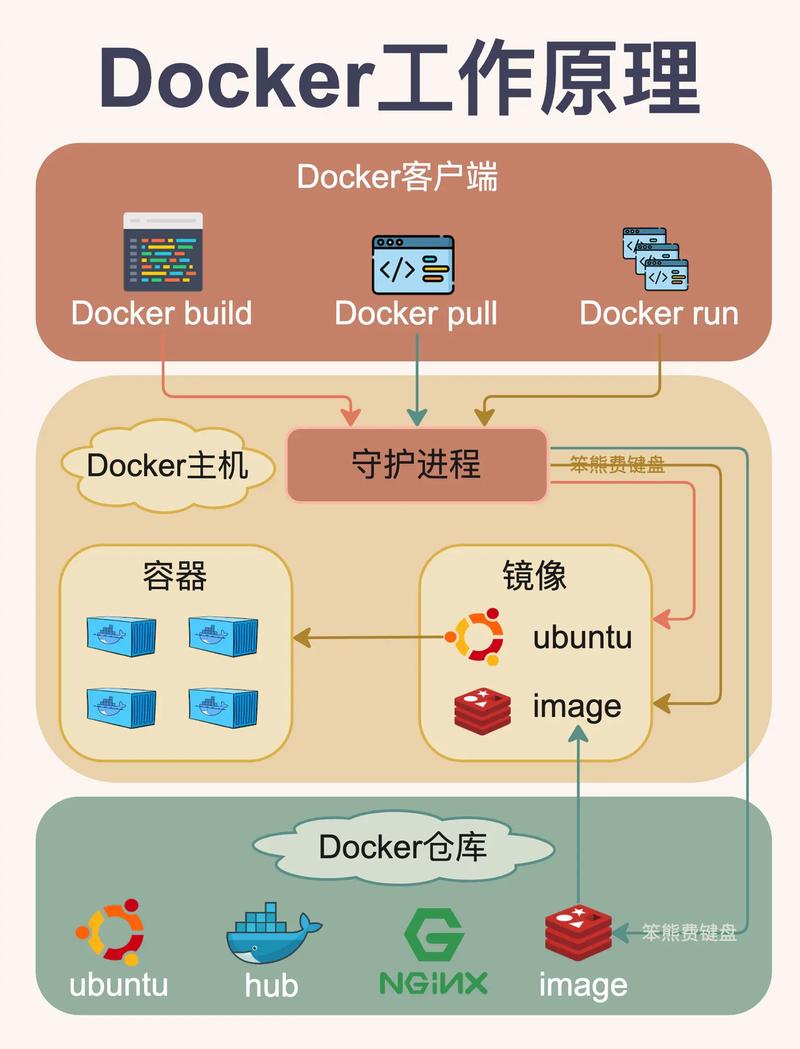

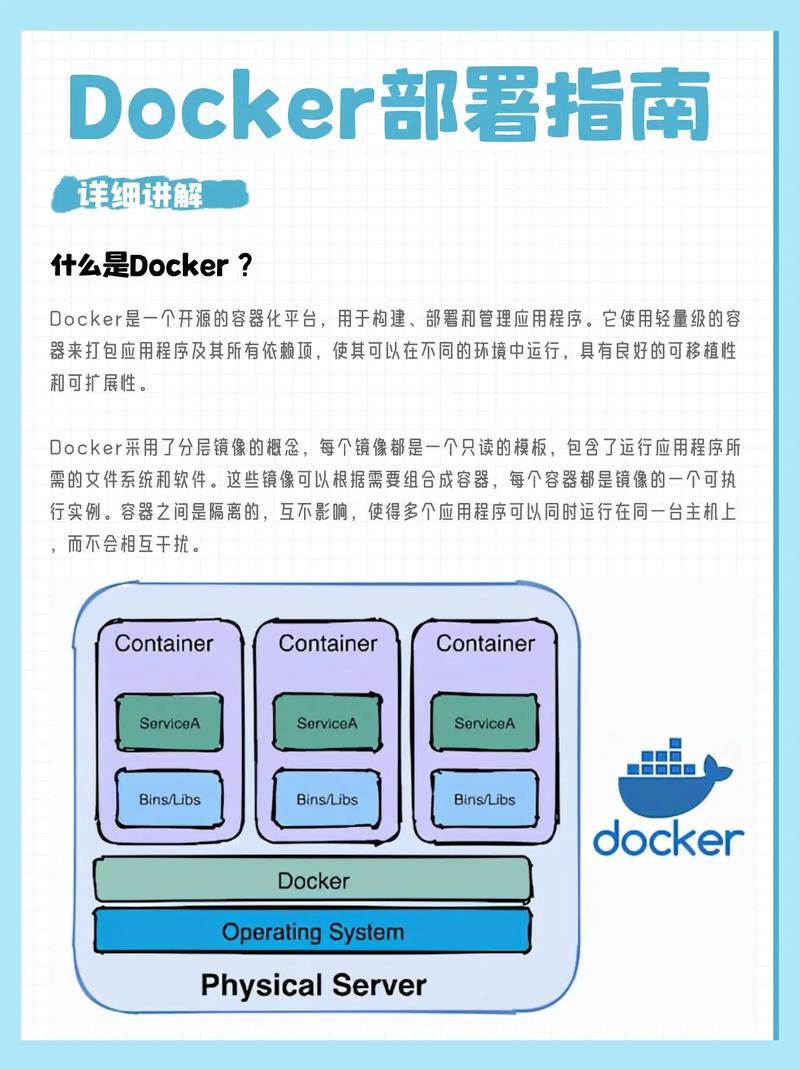

Docker技术作为容器化领域的代表性工具,通过轻量级虚拟化和资源隔离特性,极大地简化了应用部署和环境一致性问题,但在实际应用中仍存在多方面的缺陷,这些缺陷涉及安全性、性能、存储管理、网络复杂性及生态兼容性等多个维度,需结合具体场景权衡使用。

安全性缺陷

容器安全是Docker技术最受关注的缺陷之一,主要表现为隔离机制不完善和攻击面扩大,虽然Docker利用Linux内核的namespace和cgroups实现资源隔离,但namespace隔离并非绝对,尤其在宿主机内核存在漏洞时,攻击者可通过“容器逃逸”获取宿主机权限,CVE-2025-5736漏洞允许恶意容器覆盖宿主机runc二进制文件,从而实现权限提升,默认配置下容器root用户与宿主机root用户映射,直接使用root运行容器会放大安全风险,需通过非root用户或安全加固(如AppArmor、SELinux)缓解,但增加了运维复杂度。

镜像安全同样存在隐患,官方镜像仓库虽提供基础镜像,但第三方镜像可能包含恶意代码或未修复的漏洞,Docker镜像的层叠存储结构导致历史层可能残留敏感信息(如密钥、配置文件),且镜像扫描工具(如Trivy、Clair)仅能检测已知漏洞,对零日漏洞或供应链攻击(如依赖库篡改)覆盖有限,容器间网络默认采用bridge模式,缺乏原生加密机制,需结合第三方工具(如Calico、Consul)实现通信安全,但配置成本较高。

性能瓶颈

Docker的性能缺陷主要体现在资源开销和运行效率两方面,容器启动虽比虚拟机快,但相比原生进程仍存在额外开销:namespace创建需内核调用,cgroups资源限制涉及监控进程,且容器内进程需通过Docker Daemon与宿主机交互,增加了上下文切换延迟,在高并发场景下,大量容器同时启动可能导致宿主机CPU和内存资源瞬间耗尽,影响整体性能。

存储性能是另一瓶颈,容器默认使用联合文件系统(如OverlayFS),其写时复制(CoW)机制在频繁写操作场景下(如数据库应用)会导致I/O性能下降,且垃圾回收(GC)可能引发短暂的I/O风暴,对于需要持久化存储的场景,Docker需依赖外部存储驱动(如NFS、Ceph),但网络存储的延迟远低于本地存储,且驱动兼容性问题可能导致数据损坏,容器镜像的分层存储使得镜像体积膨胀,拉取和推送大镜像时消耗大量网络带宽和时间,尤其在弱网络环境下更为明显。

存储管理复杂性

Docker的存储模型存在设计缺陷,导致数据持久化和迁移困难,容器生命周期短暂,其内部数据默认随容器删除而丢失,需通过数据卷(Volume)或绑定挂载(Bind Mount)实现持久化,但两者的管理逻辑不统一:数据卷由Docker管理,支持备份和迁移,但与宿主机文件系统耦合;绑定挂载直接映射宿主机路径,灵活性高但易导致路径冲突和权限问题,在Windows宿主机上绑定挂载Linux路径时,可能因路径格式不兼容而失败。

存储驱动的多样性也增加了运维复杂度,Docker支持多种存储驱动(如overlay2、devicemapper、btrfs),不同驱动在性能、兼容性和功能上差异显著,devicemapper驱动在CentOS 7下默认使用loopback模式,存在I/O性能瓶颈,需配置LVM块设备才能优化,但操作步骤繁琐,跨存储驱动的镜像迁移可能导致数据丢失,且存储驱动升级需谨慎,否则可能破坏现有容器数据。

网络配置与兼容性问题

Docker的网络模型设计虽灵活,但实际配置中存在诸多缺陷,默认的bridge模式通过docker0网桥为容器分配IP,但跨主机通信需额外端口映射或端口转发,导致端口管理混乱,当容器数量增多时,docker0网桥的IP地址可能耗尽,且网络规则(如iptables)复杂,排查故障需同时检查容器、网桥和宿主机路由,效率低下。

第三方网络插件(如Flannel、Weave)虽解决了跨主机通信问题,但引入了新的兼容性风险,Flannel的Overlay网络模式会增加封装头部,导致MTU问题,影响大数据包传输;而Weave的加密功能可能影响网络性能,云平台(如AWS、Azure)的网络环境与Docker默认配置存在差异,需调整VPC、安全组等参数,否则可能导致容器无法访问外部服务,对于Windows容器,Docker的网络支持远不如Linux成熟,部分高级功能(如自定义网络驱动)存在限制。

生态兼容性与版本管理

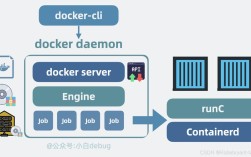

Docker的快速发展导致生态兼容性问题突出,Docker Engine、Docker Compose、Docker Swarm等组件版本迭代频繁,不同版本间API和命令行接口可能不兼容,例如Docker Compose 2.x与1.x的配置文件格式差异较大,导致旧项目迁移困难,Docker官方对部分功能(如Docker Swarm)的更新放缓,而Kubernetes作为容器编排工具逐渐成为主流,但Docker与Kubernetes的集成存在兼容性坑点,如容器运行时需从dockerd迁移到containerd,增加了迁移成本。

镜像仓库的碎片化也是一大缺陷,除官方Docker Hub外,企业需搭建私有镜像仓库(如Harbor、Nexus),但不同仓库的API和认证机制不统一,导致镜像管理复杂,Harbor支持镜像复制和漏洞扫描,但与Jenkins等CI/CD工具集成时需额外配置插件,而Docker Hub的速率限制(匿名用户每小时100次拉取)也影响了大规模部署效率。

资源管理与监控不足

Docker对容器资源的监控和管理能力有限,虽然docker stats命令可实时查看容器CPU、内存使用情况,但数据粒度较粗,无法满足精细化监控需求(如容器内进程级别的资源分配),结合Prometheus+Grafana等工具可实现监控,但需额外部署和配置,且对非技术人员不友好,Docker自身缺乏资源调度能力,需依赖Kubernetes或Swarm实现,但增加了系统复杂度。

在资源隔离方面,cgroups虽能限制容器资源使用,但无法防止“邻居干扰”,当多个容器竞争CPU时,CFS(Completely Fair Scheduler)调度可能导致延迟增加,而Docker无法动态调整调度优先级,对于内存密集型应用,容器内存溢出可能导致OOM Killer杀死进程,但Docker无法区分容器和宿主机内存压力,可能误杀关键容器。

相关问答FAQs

Q1:如何缓解Docker容器逃逸的安全风险?

A:缓解Docker容器逃逸风险需从多方面入手:① 避免以root用户运行容器,通过USER指令切换非特权用户;② 启用安全模块,如AppArmor、SELinux限制容器对宿主机资源的访问;③ 定期更新Docker版本及内核补丁,修复已知漏洞(如CVE-2025-5736);④ 使用最小权限原则,限制容器能力(capabilities),如禁用NET_ADMIN、SYS_ADMIN等高危能力;⑤ 部署镜像扫描工具(如Trivy),定期检查镜像漏洞;⑥ 网络层面采用加密通信(如TLS)和微分段策略,隔离容器间通信。

Q2:Docker存储性能差如何优化?

A:优化Docker存储性能可采取以下措施:① 选择高性能存储驱动,如OverlayFS(推荐overlay2)或btrfs,避免使用devicemapper的loopback模式;② 对于频繁写操作场景,将数据存储在独立数据卷而非容器层,减少CoW机制的影响;③ 使用本地存储而非网络存储(如NFS)作为数据卷,降低I/O延迟;④ 调整系统参数,如增加vm.max_map_count优化内存映射,或调整文件系统挂载选项(如noatime);⑤ 对于大规模部署,采用分布式存储(如Ceph)并结合Docker卷插件实现动态挂载;⑥ 定期清理无用的镜像、容器和数据卷,释放存储空间并减少垃圾回收开销。