面部捕捉技术是一种通过计算机视觉和人工智能算法,实时或离线获取人类面部特征、表情、姿态等信息的技术,其核心原理是通过光学设备采集面部图像数据,结合算法模型进行数据解析和三维重建,最终实现对人脸的精准数字化表达,该技术广泛应用于虚拟现实、影视动画、人机交互、安防监控等领域,其技术流程可分解为数据采集、预处理、特征提取、三维建模和动作映射等关键环节。

数据采集:光学信号的获取与转化

面部捕捉的第一步是通过传感器捕捉面部图像或视频流,主流设备包括普通摄像头、深度传感器(如Kinect)、红外摄像头以及高速摄像机等,普通摄像头依赖可见光成像,通过RGB色彩空间记录面部纹理信息;深度传感器则通过结构光、ToF(飞行时间法)或立体视觉技术,获取面部各点与镜头之间的距离数据,生成深度图,形成包含三维空间信息的点云数据,高速摄像机则用于捕捉高动态表情,如眨眼、微笑等细微动作,确保时间维度上的精度,数据采集的质量直接影响后续处理的准确性,因此需考虑光照条件、面部遮挡(如头发、眼镜)以及设备分辨率等因素。

数据预处理:噪声消除与标准化

原始采集数据常包含噪声、干扰或缺失,需通过预处理算法优化,常见的预处理步骤包括:

- 人脸检测与对齐:采用Haar特征级联分类器、HOG(方向梯度直方图)或基于深度学习的MTCNN算法,定位图像中的人脸区域,并检测关键特征点(如眼角、鼻尖、嘴角),通过仿射变换将人脸对齐到标准坐标系,消除姿态差异。

- 光照补偿与归一化:使用直方图均衡化或Retinex算法校正光照不均,增强面部细节;通过高斯滤波或中值滤波消除图像噪声。

- 深度数据修复:对于深度传感器采集的点云数据,通过泊松重建或RBF(径向基函数)插值填补空洞,确保三维模型的连续性。

特征提取:从像素到语义的映射

预处理后的数据需通过算法提取面部特征,包括几何特征(如五官位置、面部轮廓)和外观特征(如皮肤纹理、颜色),传统方法依赖手工设计的特征算子,如LBP(局部二值模式)或SIFT(尺度不变特征变换),而现代技术则采用卷积神经网络(CNN)进行端到端学习,通过3DMM(三维 Morphable Model)可参数化表达面部形状和纹理,将面部解构为平均形状模型与表情基向量的线性组合,实现对眉毛、嘴巴等部位运动的量化描述,表情识别算法(如FER-2025数据集训练的模型)可分类出高兴、悲伤、愤怒等基本情绪,为情感交互提供数据支持。

三维建模与姿态估计

面部捕捉的核心目标是构建三维数字模型,并通过姿态估计实现实时跟踪,三维建模方法包括:

- 基于模板的重建:利用预先构建的人脸模板库,通过特征匹配变形生成个性化模型,适用于静态场景。

- 基于深度学习的重建:采用PixielNet、3D FaceNet等网络,直接从单目图像或深度图预测三维顶点坐标,实现高精度动态重建。

姿态估计则通过6DoF(六自由度)模型跟踪头部旋转(俯仰、偏航、滚转)和位移,结合卡尔曼滤波或粒子滤波算法预测运动轨迹,减少延迟和抖动。

动作映射与数据输出

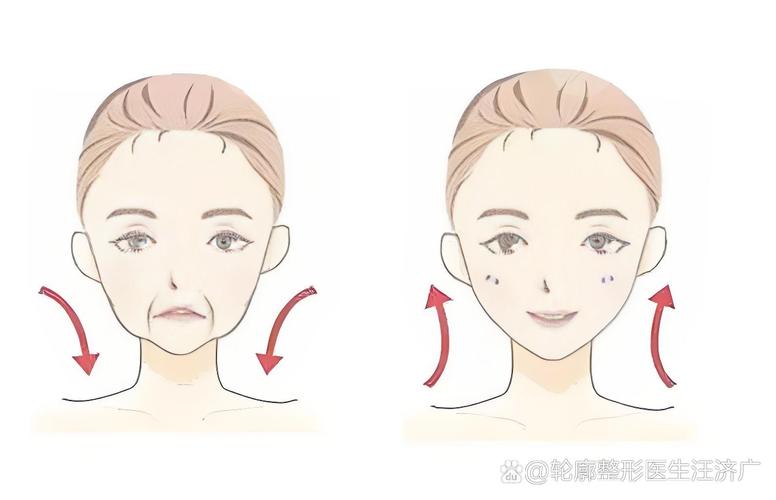

捕捉到的面部数据需映射到数字角色或交互系统中,在虚拟现实中,通过骨骼绑定将面部表情参数驱动虚拟模型的 blendshape(混合变形)目标,实现表情同步;在人机交互领域,语音识别系统可结合唇部运动数据提升识别准确率,输出数据格式包括FBX、OBJ等三维模型文件,或包含时序参数的BVH(Biovision Hierarchy)动画文件。

面部捕捉技术的挑战与发展

尽管技术日趋成熟,面部捕捉仍面临复杂光照、极端表情、遮挡等场景的鲁棒性问题,多模态融合(如结合肌电传感器)、轻量化模型(适用于移动端)以及无标记点捕捉(无需用户佩戴标记物)将成为重要发展方向,随着元宇宙概念的兴起,高精度实时面部捕捉将推动虚拟身份与真实体验的深度融合。

FAQs

Q1:面部捕捉技术与人脸识别有何区别?

A:面部捕捉技术侧重于对面部表情、姿态和三维结构的动态记录与重建,目的是实现数字化的表情复现或交互,常用于动画制作、虚拟形象等场景;而人脸识别则聚焦于身份验证,通过提取面部特征点比对身份信息,应用于安防、解锁等领域,两者的核心目标不同:前者追求“表情的动态表达”,后者追求“身份的静态确认”。

Q2:为什么深度传感器能提升面部捕捉的准确性?

A:深度传感器可直接获取面部各点的空间坐标信息,生成包含深度数据的点云,解决了传统RGB摄像头在三维重建中依赖多视角图像或立体视觉的局限性,尤其在复杂表情和侧脸姿态下,深度数据能更精准描述面部几何结构,减少因光照变化或纹理模糊导致的特征提取误差,从而提升捕捉的鲁棒性和精度。