核心技术特点

这些是构成4G技术体系的基础,是其高性能和高效率的根本原因。

-

基于全IP网络架构

- 核心思想:4G网络将语音、数据、视频等所有业务都通过IP协议进行传输,实现了网络层的统一,这与3G网络将电路交换(用于语音)和分组交换(用于数据)分开的架构有本质区别。

- 带来的好处:

- 简化网络:网络架构更简单,易于管理和维护。

- 高效融合:语音、数据和视频可以无缝融合在同一网络中,便于提供融合业务。

- 易于演进:向5G等未来网络演进更加平滑。

-

主要采用OFDM和MIMO技术

- OFDM (正交频分复用):

- 作用:将高速的数据流分解成多个并行的低速子数据流,在多个正交的子载波上同时传输。

- 优点:极大地提高了频谱利用率,有效对抗多径衰落(信号反射问题),是实现高速数据传输的关键技术。

- MIMO (多输入多输出):

- 作用:在基站和终端设备上使用多根天线,通过空间分集、空间复用等技术,在同一频段上同时收发多个数据流。

- 优点:在不增加带宽的情况下,成倍地提升了系统容量和数据传输速率,是4G网络容量和覆盖的“倍增器”。

- OFDM (正交频分复用):

-

以LTE/LTE-Advanced为核心标准

- LTE (Long-Term Evolution, 长期演进):是4G的主流技术标准,也常被称为“3.9G”,因为它虽然是4G的基石,但其最初版本不完全满足国际电信联盟对4G的所有要求。

- LTE-Advanced (LTE-A):是LTE的增强版,被国际电信联盟正式定义为“IMT-Advanced”,即真正的4G标准,它通过载波聚合、中继、协作多点传输等技术,进一步提升了性能。

-

高移动性和无缝切换

(图片来源网络,侵删)

(图片来源网络,侵删)- 4G网络支持高速移动场景下的通信,设计目标是在时速500公里(如高铁)的移动状态下,仍能提供稳定的高速数据服务。

- 它支持在不同基站、不同网络(如4G与3G/Wi-Fi之间)之间的快速、无缝切换,保证了用户在移动过程中体验不中断。

业务与应用特点

这些特点直接体现在用户能享受到的服务上,是4G技术成功的直观体现。

-

高速数据传输

- 这是4G最核心、最广为人知的特点,理论峰值下行速率可达100Mbps以上,实际体验通常在10-50Mbps。

- 影响:这使得高清视频流畅观看、大文件快速下载、高质量在线视频通话成为可能。

-

高质量多媒体通信

- 依托高速率,4G网络可以支持高清甚至超高清的视频通话、视频会议,用户体验远超3G时代。

- 为移动电视、视频直播等业务提供了网络基础。

-

真正的移动互联网时代开启

(图片来源网络,侵删)

(图片来源网络,侵删)- 4G的高速率和低时延特性,催生了移动应用生态的爆发。

- 典型应用:

- 社交娱乐:高清图片分享、短视频(如抖音、快手的前身)开始流行。

- 移动出行:网约车、共享单车、实时导航等应用依赖实时数据交换。

- O2O服务:外卖、团购、移动支付等线上线下融合服务普及。

- 云服务:云存储、云办公开始被大众广泛使用。

-

融合与开放

- 4G网络不仅是移动通信网,更是一个融合平台,可以方便地与广播网、互联网等网络互通。

- 开放的API接口吸引了大量开发者,创造了丰富的应用,形成了繁荣的移动互联网产业。

性能指标特点

这些是衡量4G网络性能的量化指标。

-

峰值速率高

- 下行峰值速率:100 Mbps ~ 1 Gbps (LTE-A)

- 上行峰值速率:30 ~ 500 Mbps (LTE-A)

-

传输时延低

- 空中接口的用户面时延可低至10毫秒,控制面时延在100毫秒以内。

- 低时延对于实时交互应用(如在线游戏、远程控制)至关重要。

-

频谱利用率高

通过OFDM和MIMO等先进技术,4G的频谱效率是3G的数倍,意味着在相同的频谱资源下可以承载更多用户。

-

网络容量大

单位面积内可以同时支持更多的用户进行高速数据通信,有效缓解了网络拥堵。

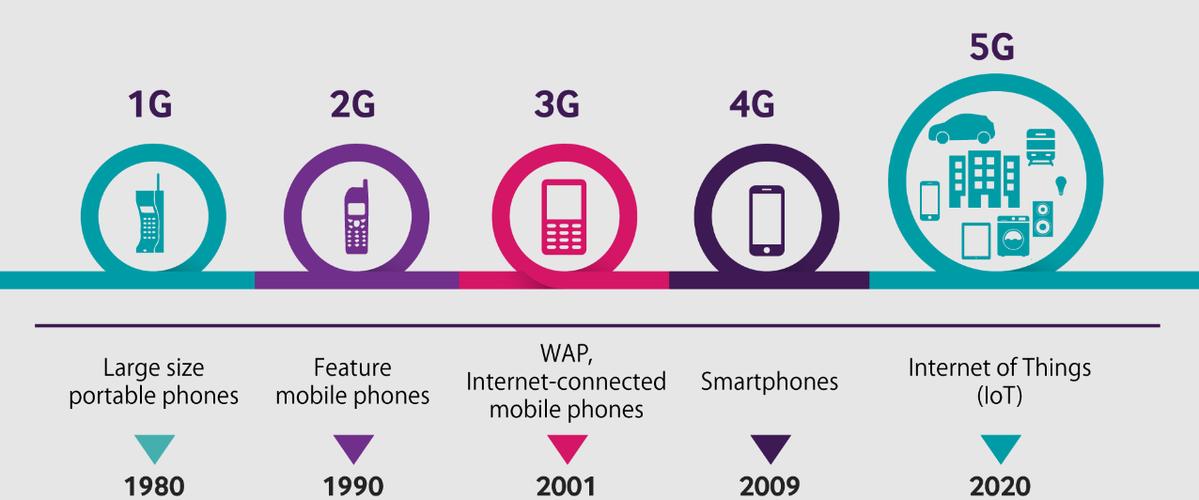

4G技术的特点可以概括为:以全IP为核心架构,采用OFDM和MIMO等关键技术,实现了高速率、低时延、大容量和高移动性,它不仅是一次简单的技术升级,更是一次社会性的变革,将互联网从PC端彻底解放到了移动端,深刻地改变了人们的生活、工作和娱乐方式,为5G时代的到来铺平了道路。