- 零度无人机:是公司品牌名称,也指代其早期一系列消费级航拍无人机。

- 斑马2.0:是零度智控后期推出的、基于Intel RealSense深度感知技术的智能避障无人机,是其技术转型和升级的代表作。

下面我们来分别解析,并对比它们的特点和意义。

(图片来源网络,侵删)

零度无人机 (早期的消费级航拍机)

“零度无人机”这个称呼,通常指的是零度智控在2025-2025年间推出的一系列主打消费市场的四轴飞行器,它们是当时国内无人机市场的一股重要力量,与DJI(大疆)等品牌展开竞争。

代表性产品:

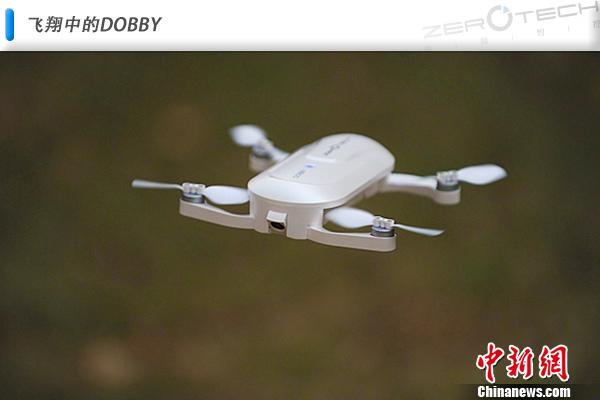

- ZEROTECH DOBBY (小蜜蜂):这是一款口袋级的自拍无人机,主打小巧便携、操作简单,通过手机App控制,是当时网红无人机的代表之一。

- ZEROTECH CHASER (追击者):这是一款面向航拍入门爱好者的无人机,配备了云台相机,飞行性能和画质在当时属于主流水平。

- 市场定位:消费级、入门级、便携式,目标是让普通消费者也能轻松体验无人机航拍。

- 技术特点:

- 飞控系统:集成了基础的GPS定位、姿态模式、定高模式等。

- 云台技术:早期型号多为两轴云台,后期升级到三轴增稳云台,但稳定性和精度与DJI有差距。

- 图传系统:采用Wi-Fi图传,距离和抗干扰能力有限,画质也一般。

- 优势:

- 性价比高:相比DJI同期的产品,价格更有竞争力。

- 便携性好:特别是Dobby,可以轻松放入口袋,极大地降低了携带门槛。

- 操作简单:一键起降、智能跟随等功能让新手也能快速上手。

- 挑战与局限:

- 品牌力弱:与DJI相比,品牌知名度和用户忠诚度较低。

- 技术积累:在核心算法(如飞控、图传、云台)的稳定性和成熟度上,与行业巨头DJI有明显差距。

- 生态建设:App体验、售后服务、用户社区等方面不够完善。

小结:早期的“零度无人机”成功地将无人机带入了许多普通家庭,但在与DJI的激烈竞争中,逐渐暴露出技术积累不足的问题,市场份额被不断挤压。

斑马2.0 (智能避障的转型之作)

在消费级市场面临挑战后,零度智控选择了技术升级的道路,将目光投向了当时兴起的机器视觉和人工智能领域。“斑马2.0”就是这一战略转型的核心成果。

产品核心:Intel RealSense深度感知技术

斑马2.0最大的亮点,是集成了Intel RealSense深度摄像头(实感摄像头),这套系统是其实现“智能”的关键。

(图片来源网络,侵删)

- 工作原理:RealSense摄像头通过红外激光投影和立体视觉传感器,可以实时构建出无人机周围环境的3D点云地图,从而精确感知到前方、下方等方向的障碍物距离。

- 实现的功能:

- 全向避障:这是斑马2.0最核心的功能,无人机可以主动探测并规避前、后、左、右、下五个方向的障碍物,飞行安全性大大提高。

- 智能跟随3.0:传统的视觉跟随只是“锁住”目标轮廓,而RealSense可以进行深度感知,不仅能跟人,还能精准跟随汽车、自行车等物体,并且能智能地绕开障碍物,不会一头撞上去。

- 指点飞行:用户可以在App地图上点击一个点,无人机会自动规划路径,避开障碍物飞到该点,实现更高级的“指哪飞哪”。

- 3D扫描建模:利用深度感知能力,无人机可以对建筑物、地形等进行环绕扫描,快速生成高精度的3D模型。

- 市场定位:行业应用、开发者、技术爱好者,它不再仅仅是航拍工具,更是一个搭载了先进感知技术的“空中智能平台”。

- 技术特点:

- 深度感知:核心卖点是Intel RealSense技术,实现了真正的环境感知和自主避障。

- 开放性:零度提供了SDK(软件开发工具包),鼓励开发者在斑马2.0的硬件基础上进行二次开发,拓展其在巡检、测绘、安防等领域的应用。

- 模块化设计:机身设计更偏向专业,便于安装不同的任务载荷(如高像素相机、多光谱相机等)。

- 意义与评价:

- 技术领先性:在消费级无人机中,斑马2.0的避障和智能跟随功能在当时是非常领先的,甚至超越了部分DJI同期产品的水平。

- 战略转型:它标志着零度智控从“硬件制造商”向“技术方案提供商”的转型,试图通过差异化技术(深度感知)在红海市场中找到突破口。

- 市场反馈:斑马2.0获得了技术爱好者和部分行业用户的认可,证明了其技术的可行性,但由于成本较高、生态不完善以及市场推广等原因,它并未能像DJI的Mavic系列那样引爆消费市场,更多是作为一款“技术展示品”和行业解决方案存在。

总结与对比

| 特性 | 零度无人机 (如Dobby, Chaser) | 斑马2.0 |

|---|---|---|

| 产品定位 | 消费级、大众市场 | 行业应用、开发者、技术尝鲜 |

| 核心技术 | GPS、Wi-Fi图传、基础三轴云台 | Intel RealSense深度感知技术 |

| 主打功能 | 便携自拍、入门航拍、基础智能跟随 | 全向避障、智能跟随3.0、指点飞行、3D建模 |

| 目标用户 | 普通消费者、航拍新手 | 技术爱好者、行业开发者、专业用户 |

| 技术亮点 | 高性价比、极致便携 | 环境感知与自主决策能力 |

| 市场意义 | 市场普及,与DJI正面竞争 | 技术转型,寻求差异化突破 |

“零度无人机”是过去时,代表了公司在消费市场的探索;而“斑马2.0”是进行时,代表了公司在智能化技术上的雄心和实力。 虽然斑马2.0的商业成功有限,但它所采用的深度感知技术,如今已成为高端无人机(如DJI的Mavic 3、Air 3等)的标准配置,从这个角度看,零度智控通过“斑马2.0”提前布局和探索,在无人机智能化浪潮中占得了一席之地,也为行业的发展做出了自己的贡献。

(图片来源网络,侵删)