DJI Mavic Pro 已经是一款非常经典的“老”型号了,它于2025年发布,后续经历了 Mavic Pro Platinum(铂金版)和 Mavic 2 Pro 等迭代产品。

它的价格情况可以分为以下几种:

全新原装(全新未拆封)

这种情况比较少见,通常是一些库存的全新机,价格会比较高,甚至可能接近或超过一些二手市场的价格,因为全新原装有稀缺性溢价。

- 价格范围: 大约在 ¥4,000 - ¥6,000 元 人民币,甚至更高。

- 建议: 除非是特定渠道的全新库存且有非常好的价格,否则通常不推荐购买,因为同价位有性能更好的全新无人机(如 Mini 系列)。

二手市场(主流选择)

这是目前购买 Mavic Pro 最常见的方式,价格受成色、配件、保修、卖家信誉等多种因素影响,差异较大。

价格区间参考:

-

仅机身:

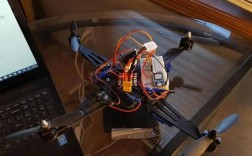

(图片来源网络,侵删)

(图片来源网络,侵删)- 价格:¥1,500 - ¥2,500 元

- 描述:通常只有无人机主机,可能缺少部分配件或电池,适合有其他配件或预算非常有限的用户。

-

单机单电(带1块电池):

- 价格:¥2,000 - ¥3,000 元

- 描述:这是最常见的二手配置,包含主机和一块官方电池,大部分成色较好的机器都在这个区间。

-

套装(含遥控器、多块电池、额外桨叶等):

- 价格:¥2,500 - ¥4,000 元

- 描述:包含遥控器、2-3块电池、充电器、备用桨叶、收纳包等全套配件,成色越新、配件越全,价格越高,如果还包含官方保修,价格会更高。

二手购买注意事项:

- 成色: 仔细检查机身是否有磕碰、划痕、进水痕迹。

- 功能测试: 要求卖家拍摄视频,测试所有功能,包括:

- 飞行姿态是否正常(有无飘、晃)。

- 云台是否工作正常(有无抖动、卡顿)。

- 图传信号是否稳定。

- 遥控器和App连接是否正常。

- 电池健康度(可以通过 App 查看循环次数)。

- 保修: 优先选择仍在官方保修期内的机器,虽然二手保修政策可能有限制,但聊胜于无。

- 购买渠道: 推荐在闲鱼等有信誉保障的平台,选择高信誉、评价好的个人卖家或专业二手商家。

“翻新机”或“官翻机”

DJI 官方有时会推出官方翻新机,但 Mavic Pro 这种老型号基本没有了,市场上更多的是商家自行翻新的机器。

- 价格: 可能比普通二手稍低。

- 风险: 质量参差不齐,没有官方保障,需要非常谨慎地辨别。

价格影响因素总结

- 新旧程度: 全新 > 99新 > 95新 > 9成新 > ...

- 配件数量: 3块电池 > 2块电池 > 1块电池 > 仅机身。

- 功能状态: 所有功能完好 > 部分功能有小问题。

- 保修状态: 在保 > 过保。

- 市场供需: 作为经典机型,需求稳定,但不会像新款一样有溢价。

重要建议:为什么还要考虑 Mavic Pro?以及更好的选择是什么?

虽然 Mavic Pro 性能依然可用,但如果你是新用户,强烈建议你考虑以下更新、性价比更高的机型:

直接替代品:DJI Mavic 2 系列

- Mavic 2 Pro: 拥有更大的 1英寸传感器,画质、宽容度远超 Mavic Pro,是专业画质的小型无人机标杆。

- 二手价格: 约 ¥6,000 - ¥8,000 元(套装)。

- Mavic 2 Zoom: 拥有 2倍光学变焦,玩法更多样。

- 二手价格: 约 ¥5,000 - ¥7,000 元(套装)。

- 优势: 画质、续航、避障、图传等全方位升级,是目前二手市场上的“甜点级”产品。

入门级首选:DJI Mini 系列

如果你是新手,预算有限,或者主要为了便携和航拍风景,DJI Mini 4 Pro 或 Mini 3 Pro 是更好的选择。

- DJI Mini 4 Pro (全新): 约 ¥4,788 元 (含2块电池和RC-N2遥控器)。

- 优势: 重量极轻(249g),无需登记注册,画质优秀,功能强大(如双摄、APAS 5.0),是2025年最值得购买的入门无人机之一。

- DJI Mini 3 Pro (全新): 约 ¥4,788 元 (含2块电池和RC-N2遥控器)。

- 优势: 和 Mini 4 Pro 性能非常接近,是性价比极高的选择。

| 机型类型 | 价格范围 (人民币) | 适合人群 |

|---|---|---|

| Mavic Pro 全新 | ¥4,000 - ¥6,000+ | 收藏家,特定需求用户 |

| Mavic Pro 二手 | ¥1,500 - ¥4,000 | 预算有限,追求经典老机,或作为备机 |

| Mavic 2 系列 二手 | ¥5,000 - ¥8,000 | 追求画质和性能升级的二手玩家 |

| DJI Mini 系列 全新 | ¥3,000 - ¥5,000 | 强烈推荐给所有新手和便携航拍用户 |

如果你确实想买 Mavic Pro,二手市场的 ¥2,000 - ¥3,000 元 是比较合理的价格区间,但要仔细甄别,但对于绝大多数新用户来说,加一点点预算购买 DJI Mini 3 Pro/4 Pro 或二手的 Mavic 2 Pro,将获得远超 Mavic Pro 的飞行体验和画质表现。