这个问题通常不是出在XP上,而是出在Windows 7的设置上,请按照以下步骤,在Windows 7电脑上进行逐一排查和设置,大概率能解决问题。

核心思路:关闭Win7的密码保护共享,并确保XP能以“来宾”或特定用户身份访问。

第一步:基础网络检查(在两台电脑上都进行)

在修改高级设置前,先确保网络基础是通的。

-

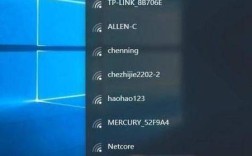

确保在同一局域网:两台电脑必须连接到同一个路由器或交换机,并且能互相

ping通。- 在XP上,按

Win + R,输入cmd,在命令提示符里输入ping 192.168.1.101(替换成你Win7的IP地址)。 - 在Win7上,同样方法

pingXP的IP地址。 - 如果能

ping通,说明网络层是通的。ping不通,请检查防火墙、网线和IP设置。

- 在XP上,按

-

查看并记录计算机名和IP地址:

- Win7: 右键点击“计算机” -> “属性”,记下“计算机名”(

WIN7-PC)。 - XP: 右键点击“我的电脑” -> “属性” -> “计算机名”,记下“完整的计算机名”(

XP-PC)。 - 两台电脑的“工作组”名称必须完全相同,如果不同,请修改成一样的(例如都改成

WORKGROUP)。

- Win7: 右键点击“计算机” -> “属性”,记下“计算机名”(

第二步:在Windows 7上进行关键设置(这是解决问题的关键)

请在Windows 7电脑上完成以下所有设置。

关闭密码保护共享(最常用且最有效的方法)

这是导致XP无法访问的最主要原因,Win7默认要求提供凭据,而XP可能没有设置用户名或密码。

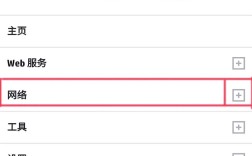

- 打开“控制面板” -> “网络和共享中心”。

- 点击左侧的“更改高级共享设置”。

- 你会看到“家庭或工作”、“公用”等几个网络配置文件。展开你当前所在的网络类型(家庭或工作”)。

- 找到“密码保护的共享”这一项,将其更改为 “关闭密码保护共享”。

- 点击“保存修改”。

启用“来宾账户”(Guest Account)

XP在访问共享资源时,如果没有指定用户,默认会尝试使用“来宾账户”(Guest),确保Win7的来宾账户是启用的。

- 打开“控制面板” -> “用户账户”。

- 点击“管理其他账户”。

- 如果你看到“来宾”账户,并且显示为“来宾账户已关闭”,请点击它,然后选择“启用”。

- 如果没有看到“来宾”账户,可以按

Win + R,输入lusrmgr.msc(如果找不到,可以运行gpedit.msc,在“本地策略”->“用户权利分配”里启用“从网络访问此计算机”,并确保“Guest”在列表中),然后找到“用户”,右键点击“Guest”,选择“属性”,取消“账户已禁用”的勾选。

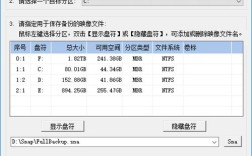

共享文件夹设置正确

- 右键点击你想要共享的文件夹(

D:\Share)。 - 选择“属性” -> “共享”选项卡。

- 点击“共享”按钮。

- 在弹出的窗口中,点击输入框旁边的下拉箭头,选择 “Everyone”。

- 点击“添加”按钮,然后设置权限级别为 “读取” 或 “读取/写入”。

- 点击“共享” -> “完成”。

检查高级共享设置

- 再次回到“控制面板” -> “网络和共享中心” -> “更改高级共享设置”。

- 确保你的网络类型(如“家庭或工作”)下的以下设置是开启的:

- 启用网络发现

- 启用文件和打印机共享

- 关闭密码保护共享 (第一步已经设置)

第三步:在Windows XP上进行设置(辅助步骤)

虽然问题主要在Win7,但XP这边也可以做一些优化。

-

确保文件和打印机共享已启用:

(图片来源网络,侵删)

(图片来源网络,侵删)- 右键点击“网上邻居” -> “属性”。

- 右键点击“本地连接” -> “属性”。

- 确保“Microsoft 网络的文件和打印机共享”被勾选。

-

设置LM兼容性级别(解决身份验证问题):

- 有时XP和Win7的加密级别不匹配也会导致问题。

- 在XP上,按

Win + R,输入secpol.msc打开“本地安全策略”。 - 在左侧导航到“安全设置” -> “本地策略” -> “安全选项”。

- 在右侧找到“网络安全: LAN 管理器身份验证级别”。

- 双击它,将其值改为 “发送 LM 和 NTLM - 如果协商则使用 NTLMv2 会话安全” 或 “仅发送 NTLMv2 响应/协商 NTLMv2 会话安全”,后者更安全,前者兼容性更好。

- 重启XP电脑。

第四步:防火墙设置(常见障碍点)

防火墙是另一个常见的“罪魁祸首”。

Windows 7防火墙:

- 打开“控制面板” -> “Windows 防火墙”。

- 点击左侧的“允许程序或功能通过 Windows 防火墙”。

- 点击“更改设置”(需要管理员权限)。

- 确保勾选了 “文件和打印机共享”,并且应用于你所在的网络类型(如“家庭或工作网络”)。

- 如果你安装了第三方杀毒软件,也请检查其防火墙规则,确保局域网访问是允许的。

Windows XP防火墙:

- 右键点击“本地连接” -> “属性” -> “高级”。

- 确保“Windows 防火墙”是开启的,并且勾选了“不允许例外”之外的选项,或者直接点击“设置”,在“例外”选项卡中确保“文件和打印机共享”被勾选。

总结与排错顺序

如果你按照以上步骤操作后问题依旧,请按以下顺序排查:

- 简化问题:先尝试从 Win7访问XP的共享文件夹,如果可以,说明XP的共享没问题,问题100%出在Win7上。

- 重新设置共享:在Win7上,右键点击要共享的文件夹 -> “属性” -> “共享” -> “高级共享” -> “权限”,确保

Everyone用户有“读取”权限。 - 临时关闭防火墙:在两台电脑上临时关闭所有防火墙(包括第三方杀毒软件的),然后再试,如果可以访问,说明就是防火墙规则的问题,回去仔细检查防火墙设置。

- 使用IP地址访问:在XP上,不要使用

\\WIN7-PC的方式访问,而是尝试使用\\192.168.1.101(Win7的IP地址),如果IP地址可以访问,说明是NetBIOS名称解析的问题,可以检查XP上的TCP/IP NetBIOS Helper服务是否开启。 - 重启所有设备:简单的重启路由器和两台电脑就能解决临时的网络协议问题。

绝大多数情况下,完成第二步(在Win7上关闭密码保护共享并启用来宾账户)就能解决你的问题,祝你好运!