安卓手机

安卓系统由于品牌众多(如小米、华为、OPPO、vivo、三星等),设置路径大同小异,核心都是通过“移动网络”或“SIM卡与移动数据”进入。

通用路径(适用于绝大多数安卓手机)

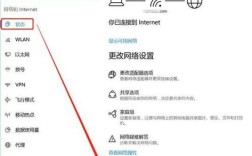

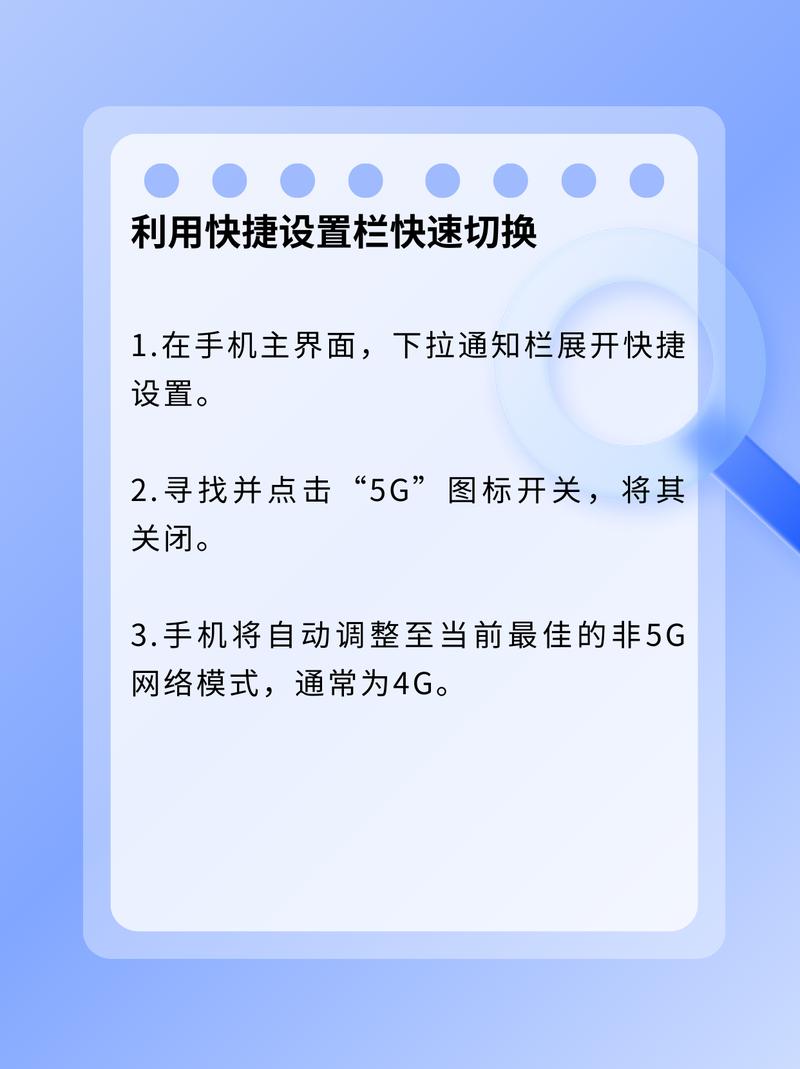

- 打开【设置】应用,你可以在应用列表里找到它,或者从屏幕顶部向下滑动,在快捷设置菜单中找到齿轮图标 ⚙️。

- 进入【移动网络】或【SIM卡与移动数据】。

在设置菜单中,寻找“网络和互联网”、“连接与共享”、“移动网络”或“SIM卡与移动数据”等选项。

- 选择对应的SIM卡。

如果你使用的是双卡手机,系统会提示你选择要设置的SIM卡(SIM 1”或“SIM 2”),选择你主要用来上网的那一张。

- 找到【首选网络类型】。

在SIM卡设置页面,找到“首选网络类型”或类似的选项(有时也叫“移动数据选项”)。

- 选择【4G/3G/2G 自动选择】。

- 点击进入后,你会看到几个选项,

- 4G/3G/2G 自动选择:这是最推荐的选项,手机会优先连接最快的4G网络,当4G信号不好时,会自动切换到3G或2G,确保通话和网络的连续性。

- 仅4G:手机只搜索并连接4G网络,如果在4G信号不好的地方,可能会没有信号。

- 3G/2G 自动选择:较少使用,会优先使用3G网络。

- 点击进入后,你会看到几个选项,

关键路径是:

设置 → 移动网络 → 选择SIM卡 → 首选网络类型 → 选择 4G/3G/2G 自动选择

不同品牌安卓手机的快速指引

-

华为/荣耀:

设置→移动网络→移动数据→移动数据选项→首选网络类型 -

小米/Redmi:

设置→双卡与移动网络→SIM卡1(或SIM卡2) →默认移动数据→首选网络类型 -

OPPO/Realme/一加:

设置→移动网络→SIM卡1(或SIM卡2) →首选网络类型 -

vivo/iQOO:

设置→移动网络→SIM卡1(或SIM卡2) →移动数据→首选网络类型 -

三星:

设置→连接→移动网络→SIM卡1(或SIM卡2) →网络模式→选择 4G/3G/2G (自动连接)

苹果手机

苹果手机的设置路径非常统一和简单。

- 打开【设置】应用。

- 点击【蜂窝网络】。

- 选择你的SIM卡。

如果你使用的是双卡iPhone,请确保顶部选择的是你想要设置4G网络的那个号码(默认语音SIM”)。

- 点击【蜂窝数据选项】。

- 点击【语音与数据】。

- 选择【4G】。

- 这里的选项通常有:

- 5G 自动:如果运营商支持,会优先使用5G,否则使用4G,这是推荐选项。

- 5G 开启:始终尝试使用5G。

- 4G:仅使用4G网络,不使用5G,这就是你需要的选项。

- 3G:仅使用3G网络(较旧)。

- 这里的选项通常有:

苹果手机的路径是:

设置 → 蜂窝网络 → 选择SIM卡 → 蜂窝数据选项 → 语音与数据 → 选择 4G

常见问题与解决方法

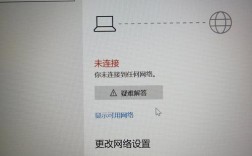

如果按照以上步骤设置后,手机仍然无法使用4G网络,可以尝试以下排查方法:

- 重启手机:这是最简单也最有效的解决方法,可以清除临时性的网络错误。

- 检查信号位置:确保你所在的地方有4G网络覆盖,可以尝试去开阔地带或靠近窗户的位置。

- 检查是否欠费:手机话费或流量套餐是否已用完或已欠费?欠费会导致网络服务中断。

- 检查APN(接入点名称)设置:错误的APN设置会导致无法上网。

- 安卓:在

移动网络->接入点名称 (APN)中,检查APN设置是否正确,你可以联系运营商客服获取正确的APN信息。 - 苹果:通常APN由运营商自动配置,无需手动设置。

- 安卓:在

- 飞行模式开关:确保你没有开启飞行模式,开启后,所有网络都会被关闭。

- 重置网络设置:

- 安卓:

设置->系统->重置选项->重置网络设置。注意: 这会清除所有Wi-Fi密码和蓝牙配对记录。 - 苹果:

设置->通用->传输或还原 iPhone->还原->还原网络设置。注意: 这同样会清除Wi-Fi密码和蓝牙配对记录。

- 安卓:

- 联系运营商客服:如果以上方法都无效,可能是SIM卡损坏或运营商网络故障,请联系你的运营商(如中国移动、中国联通、中国电信)客服寻求帮助。

希望这个详细的指南能帮助你成功打开手机的4G网络!